La migration vers le cloud est devenue l’un des piliers essentiels de la transformation numérique. Cependant, en Espagne, son adoption progresse à des rythmes très divergents. Alors que les grandes entreprises opèrent déjà couramment dans des environnements cloud, les PME restent encore très en retrait. Selon le rapport Cloud Nation

- Cloud

- 5 minutes de lecture

Le marché des cartes graphiques dédiées pour ordinateurs de bureau a clôturé 2025 dans une situation particulièrement défavorable pour AMD et très favorable pour NVIDIA. Les dernières données de Jon Peddie Research, le cabinet d’analyse spécialisé dans le suivi des activités des fabricants de cartes graphiques (AIB), positionnent NVIDIA à

- Cloud

- 6 minutes de lecture

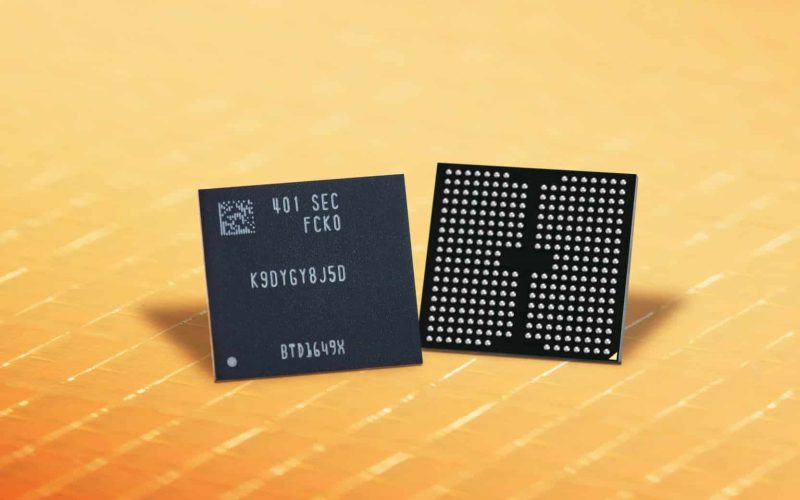

La crise de la mémoire n’est plus un problème dissimulé au sein de la chaîne d’approvisionnement. Elle commence à devenir un facteur capable de modifier ce qui se vend, à quel prix et qui peut continuer à acheter. Gartner a publié une prévision particulièrement pessimiste pour 2026 : les expéditions

- Cloud

- 5 minutes de lecture

Barcelone a de nouveau été la vitrine où les fabricants tentent de définir le prochain cycle du PC. Mais lors du Mobile World Congress (MWC) 2026, Lenovo a choisi une autre stratégie : au lieu de simplement présenter plus de puissance ou un design plus abouti, la société s’est concentrée

- Cloud

- 6 minutes de lecture

Lors du Mobile World Congress (MWC) 2026 de Barcelone, la discussion sur l’Intelligence Artificielle s’est déplacée du simple « chat » vers l’action. L’industrie ne se limite plus à chercher qui répond le mieux à un prompt, mais s’oriente désormais vers la capacité de la IA exécuter des tâches concrètes

- Cloud

- 6 minutes de lecture

Le Mobile World Congress 2026 (MWC26) a clôturé sa édition la plus emblématique à Barcelone, coïncidant avec le vingtième anniversaire de l’événement dans la ville. Pendant quatre jours, le congrès a une nouvelle fois transformé la capital catalane en le principal point de rencontre de l’industrie mondiale de la connectivité,

- Cloud

- 5 minutes de lecture

La reprise rapide prend de l’ampleur dans un environnement industriel plus instable Les fabricants de machines traversent une phase marquée par une forte pression. La volatilité de la chaîne d’approvisionnement, la hausse des coûts, l’instabilité du personnel et des attentes clients de plus en plus élevées obligent les OEM à

- Cloud

- 5 minutes de lecture