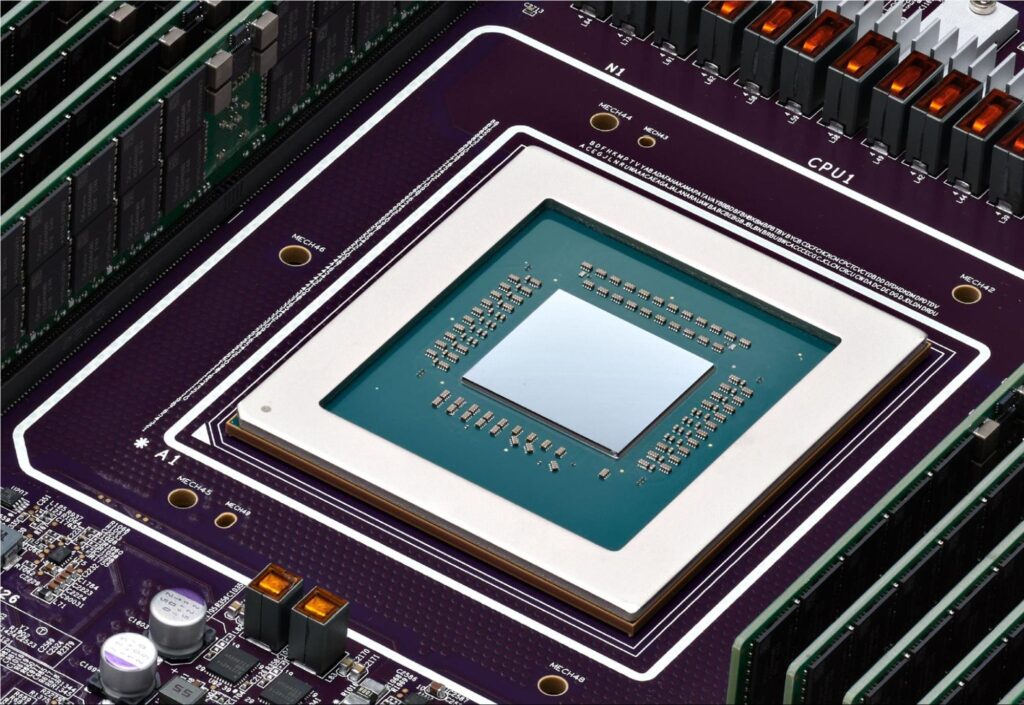

Meta progresse dans sa stratégie d’indépendance matérielle avec le développement de sa première puce d’intelligence artificielle (IA) basée sur l’architecture RISC-V, conçue spécifiquement pour l’entraînement de modèles avancés. Selon un rapport de Reuters, l’entreprise a collaboré avec Broadcom pour concevoir cet accélérateur personnalisé, fabriqué par TSMC, visant à réduire sa dépendance aux unités de traitement graphique (GPU) de Nvidia, telles que les H100, H200, B100 et B200.

Ce développement s’inscrit dans le cadre de l’initiative Meta Training and Inference Accelerator (MTIA), le programme de Meta pour la création de matériel spécialisé en IA. La société a déjà déployé de manière limitée ses premiers accélérateurs afin d’évaluer leur performance avant d’élargir sa production.

Une initiative en faveur de RISC-V et du matériel maison

Meta explore l’architecture RISC-V depuis plusieurs années comme une alternative aux processeurs traditionnels. L’avantage principal de cette architecture réside dans sa nature ouverte et flexible, permettant à Meta de personnaliser le jeu d’instructions sans avoir à payer de licences à des tiers.

Les détails techniques de la nouvelle puce restent inconnus pour l’instant, mais il est attendu qu’elle intègre de la mémoire HBM3 ou HBM3E, étant donné que les modèles d’IA nécessitent une énorme capacité de traitement de données. De plus, il est probable que l’accélérateur utilise une architecture de matrice systolique, similaire à celle d’autres puces d’entraînement, permettant d’effectuer des calculs de manière efficace à travers un réseau structuré d’unités de traitement.

Meta vise à réduire sa dépendance à Nvidia

Le programme MTIA a rencontré plusieurs défis par le passé. En 2022, Meta a arrêté le développement de son premier processeur d’inférence après ne pas avoir atteint les objectifs de performance et d’efficacité énergétique. Cet échec a conduit l’entreprise à passer des commandes massives de GPUs Nvidia pour répondre à ses besoins immédiats en matière d’entraînement de modèles d’IA.

Depuis lors, Meta est devenue un des plus grands clients de Nvidia, acquérant dizaines de milliers de GPUs pour former des modèles tels que Llama Foundation, améliorer ses algorithmes de recommandations et de publicité, ainsi que mener des processus d’inférence sur ses plateformes, qui totalisent plus de trois milliards d’utilisateurs quotidiens.

Cependant, Meta reste déterminée dans sa stratégie de développement de matériel maison. En 2023, elle a commencé à utiliser des puces MTIA pour des tâches d’inférence, et d’ici 2026, elle prévoit d’employer son accélérateur d’entraînement à plus grande échelle, sous réserve qu’il satisfasse aux exigences de performance et de consommation d’énergie.

La puce de Meta pourrait-elle marquer un tournant dans l’industrie RISC-V ?

Si l’accélérateur d’entraînement IA de Meta est également basé sur RISC-V, cela pourrait représenter l’une des puces les plus puissantes jamais créées avec cette architecture ouverte. Cette avancée renforcerait la viabilité de RISC-V dans les applications de haute performance, remettant en question le domination des architectures propriétaires telles que ARM et x86 sur le marché de l’IA.

Alors que Meta progresse dans son objectif de développer des solutions de matériel personnalisées pour ses centres de données, sa nouvelle puce pourrait transformer le paysage du calcul en IA, favorisant un écosystème plus ouvert et efficace pour le développement de modèles d’intelligence artificielle.