Sur le marché de l’intelligence artificielle, la compétition ne se résume plus uniquement à celui qui entraîn tous les meilleurs modèles, mais également à celui qui dispose de l’infrastructure capable de les soutenir. Nvidia confirme une fois de plus sa position en proposant une solution dont la puissance et le coût illustrent parfaitement le moment critique que traverse le secteur : son nouveau rack VR200 NVL72, associé à la plateforme Vera Rubin, pourrait atteindre environ 180 millions de dollars taïwanais, soit environ 5,7 à 6,0 millions de dollars américains, selon les estimations de la chaîne logistique à Taïwan.

Ce chiffre, « douloureux » même pour le standard des grandes entreprises, n’a pas tardé à susciter des étonnements. Mais il sert aussi à rappeler une règle récurrente à chaque cycle technologique : lorsque un fournisseur possède une capacité que ses concurrents ne peuvent égaler (ou ne peuvent livrer dans les délais), le prix cesse d’être un simple chiffre pour devenir un véritable outil de pouvoir.

Un rack qui ne se vend pas comme du « matériel », mais comme une capacité de calcul concentrée

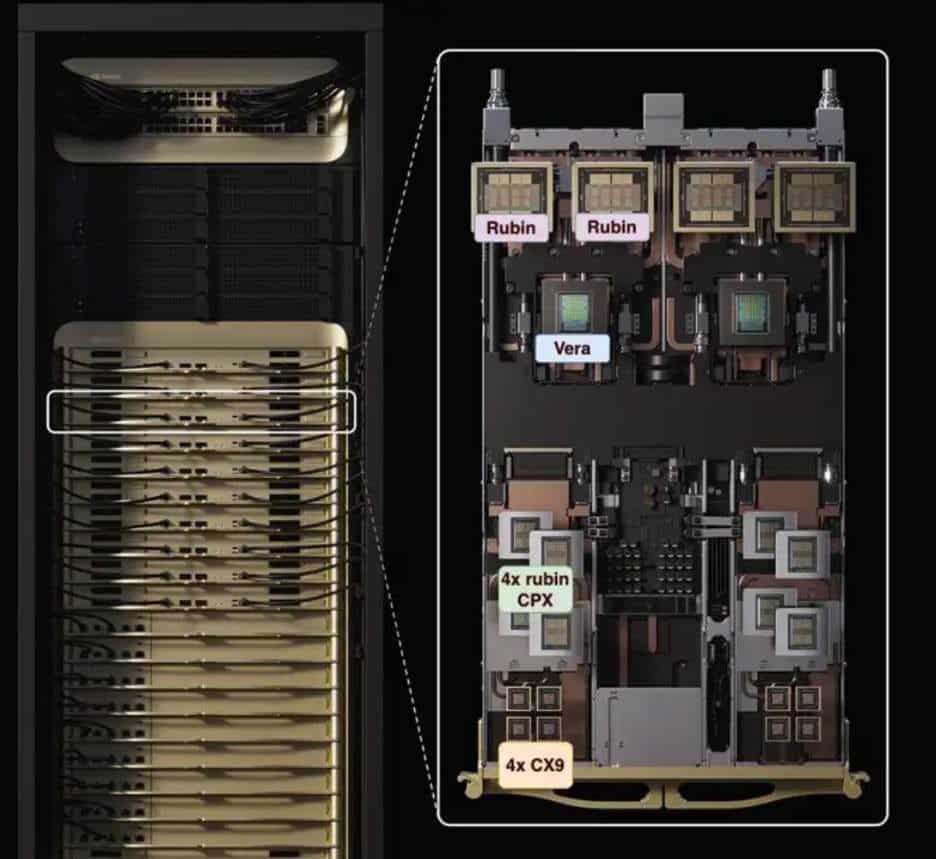

Le VR200 NVL72 n’est pas un serveur conventionnel ni un assemblage de cartes. C’est un système monté en rack, conçu pour déployer une unité de calcul dans de grands clusters d’IA. En pratique, il représente la « pièce » essentielle pour la construction de pods et de fermes d’entraînement et d’inférence à une densité toujours plus poussée.

Selon les données techniques disponibles, ce rack intègre 72 GPU Rubin et 36 CPU Vera, ainsi qu’une architecture d’interconnexion et de commutation conçue pour fonctionner comme un domaine d’accélération à haute performance. En chiffres, le système évolue vers un niveau proche de celui de la supercalculabilité : on parle de 3,6 EFLOPS en inference au format NVFP4, avec une progression significative par rapport aux générations antérieures.

Ce saut ne concerne pas uniquement la puissance de calcul : il concerne également la mémoire et l’alimentation. Le rack exploite massivement la mémoire HBM4, et sa conception exige une refroidissement liquide ainsi qu’une infrastructure électrique adaptée, ce qui, en conditions réelles, nécessite souvent de redimensionner certains éléments du centre de données.

De 2,9 à 6,0 millions : la montée en prix à l’ère du « rack à grande échelle »

Le prix annoncé du VR200 ne s’inscrit pas dans le vide. Le marché lui-même reconnaît que les infrastructures sérieuses d’IA se négocient désormais en millions par rack. À Taïwan, on estime que le précédent GB200 NVL72 aurait coûté environ 2,9 millions de dollars, tandis que le GB300 aurait atteint environ 4 millions. Aujourd’hui, avec un VR200 plus élaboré, intégrant davantage de composants et imposant des exigences thermiques et électriques accrues, ce seuil pourrait se situer autour de 5,7 à 6,0 millions.

Ce chiffre est important car il ne se limite pas au coût du matériel : il reflète aussi celui de l’accès à cette capacité. Sur un marché où la demande de puissance de calcul pour l’IA ne cesse de croître, mais où l’offre de composants clés — mémoire HBM, techniques d’emballage avancées, réseaux, alimentation — reste limitée, le prix devient une forme de rationnement. Celui qui peut payer en avance, ou rapidement, obtient une priorité dans la file d’attente.

L’infrastructure comme facteur de puissance : repenser le centre de données

La face cachée du VR200, c’est qu’il ne s’achète pas seulement comme un rack. On achète aussi le droit de rénover le centre de traitement de données (CPD) pour accueillir véritablement cette infrastructure. Les analyses sectorielles indiquent que le VR200 NVL72 engendre des exigences accrues en termes de puissance électrique, avec des évolutions dans l’architecture électrique et la distribution, et nécessitant une refroidissement liquide comme composant central du design.

Dans ce type de systèmes, la question ne se limite plus à savoir si le serveur a besoin de plus de ventilateurs : il faut également que le bâtiment puisse supporter cette augmentation de densité. Dans ce contexte, le coût de plusieurs millions par rack prend une autre dimension : pour un acheteur important, la différence entre la capacité aujourd’hui ou dans six mois peut dépasser le coût de l’équipement lui-même.

« Si vous détenez quelque chose que d’autres n’ont pas, vous fixez le prix » : le pouvoir de fixation des prix en IA

Ce que l’on entend souvent dans le secteur —« si vous avez quelque chose que d’autres n’ont pas, vous fixez le prix »— résume une dynamique que Nvidia sait exploiter parfaitement. La société ne vend pas seulement des puces ; elle pousse le marché vers des solutions intégrées où le client acquiert un bloc complet : calcul, réseau, mémoire, refroidissement, conception du système et validation.

Cette intégration a un effet direct : elle déplace une partie de la valeur depuis le fabricant de serveurs ou l’intégrateur vers celui qui domine le cœur technologique. Sur le plan commercial, c’est une manière de capturer plus de marge tout en transformant l’offre en un « produit rare » avec des barrières d’entrée élevées.

Le VR200 s’inscrit dans cette tendance, avec une approche stratégique : acheter une infrastructure d’IA en tant qu’actif clé, et non comme un simple prototype. En 2026, les clients qui optent pour des racks de 5,7 à 6 millions de dollars ne seront pas de petites structures ou laboratoires, mais des hyper-scalers, de grandes plateformes, des gouvernements, ou des entreprises cherchant à entraîner des modèles de pointe ou à déployer l’inférence à grande échelle.

L’interrogation cruciale : combien de demande réelle pour un rack à 6 millions ?

La grande question n’est pas seulement si le VR200 est cher (ce qui est indéniable), mais combien d’unités le marché peut absorber durablement. La chaîne logistique taïwanaise, selon diverses sources, évoque des estimations très variables quant au volume d’expéditions, précisément parce que la hausse du prix et les exigences en infrastructure réduisent le nombre de potentiels acheteurs.

Cependant, la logique du secteur reste claire : tant que la puissance de calcul constituera un goulet d’étranglement pour l’IA de pointe, ces systèmes de haute performance continueront de trouver preneurs. Dans cette optique, le VR200 ne se vend pas seulement comme un « rack » mais comme une ressource temporelle : le temps de former plus rapidement, de servir une inférence avec moins de latence, de lancer des produits avant la concurrence.

Dans l’économie réelle de l’IA, le marché montre qu’il existe des clients prêts à payer pour cette avancée.

Questions fréquentes

Quel est le prix estimé du rack Nvidia VR200 NVL72 ?

Les estimations du secteur à Taïwan placent le VR200 autour de 180 millions de dollars taïwanais, soit environ 5,7 à 6,0 millions de dollars américains. Il s’agit toutefois d’estimations non officielles, car Nvidia n’a pas publié de prix officiel.

En quoi le VR200 NVL72 se distingue-t-il des racks précédents comme le GB200 ou le GB300 ?

L’intégration accrue et la puissance du système, grâce à la plateforme Vera Rubin, avec 72 GPU Rubin et 36 CPU Vera, ainsi que les améliorations en matière d’interconnexion, de mémoire et de conception pour une exploitation à grande échelle, font toute la différence.

Quelles sont les exigences pour un centre de données doté d’un rack d’IA comme le VR200 ?

Ces systèmes nécessitent généralement une refroidissement liquide, une densité électrique élevée et une adaptation spécifique de l’infrastructure électrique du centre. Il ne s’agit pas simplement d’acheter le rack : il faut aussi pouvoir « l’alimenter » et le refroidir de façon stable.

Pourquoi Nvidia peut-il fixer des prix si élevés pour ses infrastructures d’IA ?

Parce que la demande en puissance de calcul dépasse souvent l’offre disponible, et Nvidia détient une position dominante en matière d’accélération et de systèmes intégrés. Lorsque l’approvisionnement est limité et que la performance constitue un avantage concurrentiel, le prix se maintient.

✳️Le nouveau rack VR200 de Nvidia pourrait être estimé à environ NT$180 millions, ce qui équivaut à environ 5,7 millions de dollars US. Il offre une puissance de calcul bien supérieure, mais la tarification reste très élevée.

Voilà comment fonctionne le marché : si vous détenez quelque chose que d’autres n’ont pas… pic.twitter.com/UlSmga2mJ4

— SemiVision👁️👁️ (@semivision_tw) 28 janvier 2026