NVIDIA redéfinit l’inférence avec Rubin CPX : moins HBM, plus d’efficacité contextuelle

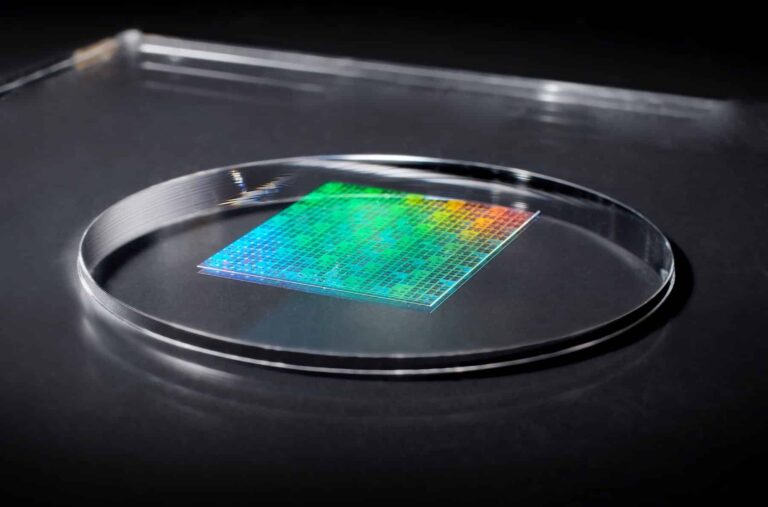

Ces derniers jours, un argument percutant est devenu viral : NVIDIA aurait « admit » que son architecture est « cassée » parce qu’elle a présenté une puce dédiée à l’intelligence artificielle qui omet la mémoire HBM au profit de la mémoire GDDR. Cette déclaration peut faire sensation sur les réseaux sociaux, mais la réalité est plus complexe — et surtout, plus nuancée : NVIDIA réagit à une évolution fondamentale dans la manière dont l’Intelligence Artificielle est déployée en production, où la compétition ne se limite plus à l’entraînement des modèles, mais porte aussi sur leur mise en service rentable quand le contexte s’étend à des centaines de milliers ou millions de tokens. La pièce centrale de cette évolution est