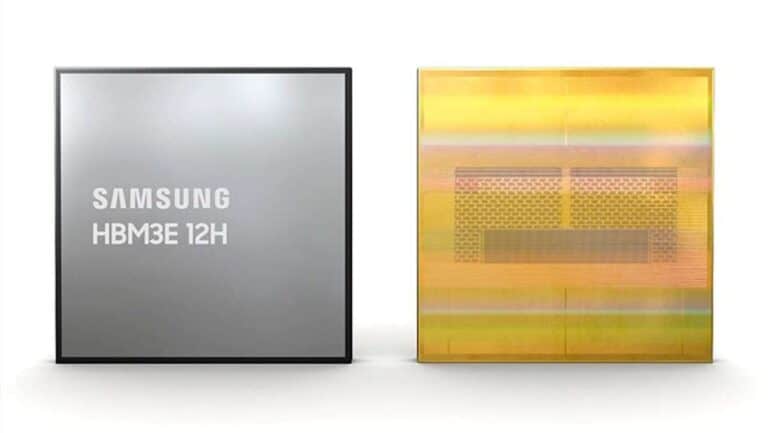

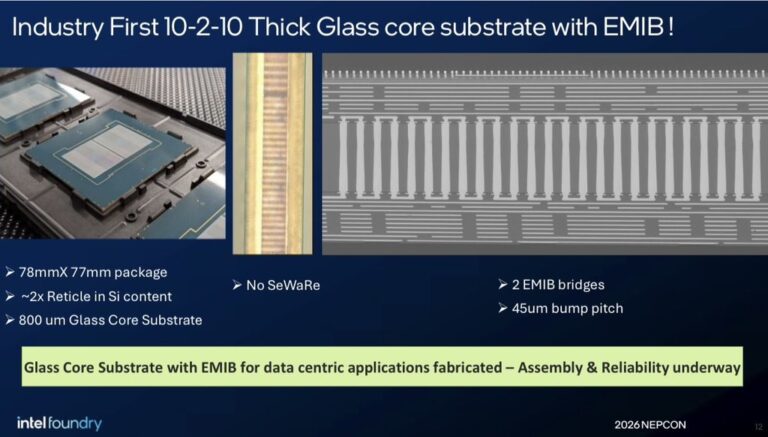

Intel présente son « core en verre » avec EMIB : le substrat en verre réapparaît comme pièce maîtresse pour faire évoluer les puces d’intelligence artificielle

Intel redéfinit de nouveau l’attention vers une technologie longtemps considérée comme obsolète : les sustrats avec noyau en verre appliqués au packaging avancé. Lors du salon NEPCON Japan 2026, Intel Foundry a présenté une implémentation combinant un “core épais” en verre à un EMIB (Embedded Multi-die Interconnect Bridge), une solution conçue pour intégrant plusieurs chiplets dans un même paquet, facilitant ainsi la montée en puissance vers les accélérateurs et systèmes HPC de nouvelle génération. Cette démonstration intervient dans un contexte industriel sensible : la demande pour les modules destinés aux centres de données pousse le packaging vers des formats plus grands, davantage de couches et des tolérances mécaniques strictes, avec une chaîne d’approvisionnement déjà sous tension en matière de matériaux