Amazon Web Services (AWS) a confirmé algo que muchos clientes llevan meses intuyendo en silencio: cuando la demanda de GPU excede la oferta, los plazos tecnológicos dejan de ser una regla inquebrantable. Según el CEO de AWS, Matt Garman, la compañía continúa operando servidores con Nvidia A100 —una GPU lanzada en 2020— y asegura que no ha retirado ninguna, en parte porque la capacidad disponible aún no cubre toda la demanda del mercado.

Garman explicó esto durante una charla con Jeetu Patel, presidente y director de producto de Cisco, en un evento reciente del sector. Su diagnóstico fue claro: la presión por capacidad sigue siendo tan elevada que los chips “antiguos” mantienen una demanda significativa, hasta el punto de que AWS afirma estar completamente vendido en instancias basadas en A100. Este mensaje, más allá del titular, indica un cambio estructural: la nube ya no se rige solo por ciclos de renovación, sino por uso y disponibilidad.

Una señal de época: el hardware no se jubila si sigue siendo útil

En el ámbito del cloud, “retirar” hardware no tiene que ver con sentimientos, sino con cálculos fríos que consideran coste operativo, eficiencia energética, densidad de rendimiento y soporte técnico. Sin embargo, la Inteligencia Artificial ha modificado esa lógica. El auge en entrenamiento e inferencia, junto con la adopción de modelos cada vez más grandes y costosos de operar, hace que cualquier GPU capaz de ofrecer resultados rentables siga siendo relevante.

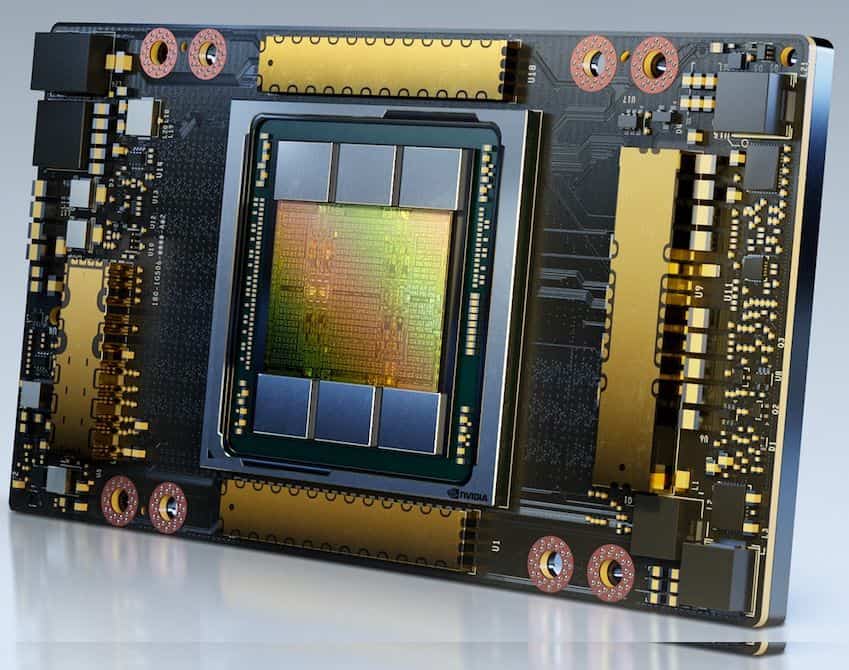

La A100, aunque pertenece a una generación anterior respecto a arquitecturas más recientes como H100 o H200, sigue siendo imprescindible en numerosos escenarios: inferencia intensiva, pipelines de datos, o entrenamientos “suficientes” para equipos que no requieren lo último en tecnología. Y cuando la alternativa es esperar, pagar primas o rediseñar cargas de trabajo, la decisión práctica suele ser evidente.

Google y sus TPU también: “siete u ocho años” a plena capacidad

Lo que dice AWS no está aislado. Garman comparó esta situación con lo que ya explicó Google en otro foro: Amin Vahdat, vicepresidente y responsable de IA e infraestructura, afirmó que la compañía mantiene siete generaciones de TPU en producción, con hardware de “siete u ocho años” en funcionamiento al 100 % de uso. La clave es que no solo las GPU se mantienen en uso prolongado: también el silicio propietario cuando la demanda requiere continuidad y sobredimensionamiento.

Desde la perspectiva de mercado, esto desmonta el mito de que ganar en velocidad requeriría siempre cambiar de chip con frecuencia. La realidad es que quien aprovecha más horas útiles por vatio, euro o rack, con lo que ya tiene desplegado, puede obtener mejores resultados que quien se limita a esperar las últimas versiones.

No todo es demanda: la importancia de la precisión en HPC

Lo más revelador en el comentario de Garman no fue solo que AWS sigue usando A100, sino el motivo técnico por el que algunos clientes no quieren migrar automáticamente a las generaciones más nuevas. El CEO explicó que en la industria se han logrado mejoras sustanciales reduciendo la precisión (menos bits, mayor rendimiento aparente) en muchas cargas de IA. Pero no todos se benefician de esta tendencia.

Algunos usuarios han manifestado que no pueden desplazarse hacia arquitecturas más modernas porque trabajan en entornos HPC donde la precisión numérica es fundamental. En tareas como simulaciones, ciencia, ingeniería, finanzas cuantitativas o modelado físico, perder precisión puede ser un error catastrófico, no solo un “trade-off”. En definitiva, la carrera por acelerar la IA mediante menor precisión convive con un mundo donde la exactitud sigue siendo innegociable.

Este conflicto explica por qué el hardware previo continúa en uso: no solo sigue siendo funcional, sino que en ciertos casos, funciona mejor para parte del mercado.

Reducción de precios en 2025: sacar partido de la inversión y competir en volumen

AWS dejó también una pista relevante sobre su estrategia comercial. En junio de 2025, anunció una reducción de costes en instancias con Nvidia H100, H200 y A100, con una bajada del 33 % en el precio bajo demanda para las instancias A100 en los tipos P4d y P4e.

Más allá del dato, este movimiento responde a un patrón clásico: cuando la plataforma ya cuenta con capacidad desplegada y amortizada, reducir el precio puede estimular la demanda y aumentar la utilización. En un mercado de GPUs muy tensionado, esta estrategia resulta aún más efectiva: hacer atractiva la “generación anterior” permite absorber picos de consumo sin depender exclusivamente de la llegada de hardware nuevo.

¿Qué cambios implica para empresas y desarrolladores?

Para el cliente final, la conclusión no es tan espectacular, pero sí más práctica: planificar infraestructura de IA en la nube ya no basta con escoger la GPU “más reciente”. Es fundamental evaluar aspectos como:

- Disponibilidad real (qué se puede contratar hoy, no solo qué está en catálogo).

- Compatibilidad y reproducibilidad (modelos, drivers, librerías, niveles de precisión).

- Coste total (precio por hora, pero también tiempos de espera, migración y rediseño).

- Riesgo de dependencia (si se agota un tipo de instancia, ¿existe un plan alternativo?).

Para los proveedores de servicios en la nube, la lección es clara: en la era de la IA, retirar hardware por calendario puede ser un lujo que no siempre está al alcance. La prioridad es mantener la capacidad en funcionamiento, porque la demanda no permite retrasos.

Preguntas frecuentes

¿Por qué AWS sigue usando Nvidia A100 si hay GPUs más nuevas?

Porque la demanda continúa superando la oferta y, además, muchos clientes logran resultados competitivos con A100, especialmente cuando el coste y la disponibilidad son ventajosos.

¿Qué cargas se benefician de mantener hardware “antiguo”?

Inferencia, entrenamiento de tamaño medio, procesamiento de datos y ciertos trabajos donde la estabilidad, compatibilidad o coste prevalecen sobre el avance tecnológico.

¿Por qué algunos clientes no migran a GPUs más nuevas?

En tareas tipo HPC, la precisión numérica puede ser crítica. Si una arquitectura prioriza rendimiento con menor precisión, podría no ser apta para simulaciones o cálculos sensibles.

¿Qué significa la bajada del 33 % en instancias A100 (P4d/P4e)?

AWS busca hacer más atractiva esa capacidad, manteniendo altas tasas de utilización y ofreciendo una opción competitiva cuando las GPUs más recientes escasean o son más costosas.

vía: datacenterdynamics