La course à la « relocalisation » de la chaîne de valeur de l’Intelligence Artificielle (IA) aux États-Unis atteint un nouveau jalon avec une date clé. Micron Technology a annoncé que le 16 janvier 2026 marquera le lancement officiel de la construction de sa gigafactory de mémoire avancée dans le comté d’Onondaga (secteur de Clay, au centre de l’État de New York). Ce projet, évalué à 100 milliards de dollars, la société le présente comme la plus grande installation de fabrication de semi-conducteurs jamais réalisée dans le pays.

Ce n’est pas un simple geste symbolique. Selon Micron, cela fait suite à l’achèvement des examens environnementaux et à l’obtention des permis nécessaires pour commencer la préparation du terrain et les travaux de construction. L’événement réunira des dirigeants de l’entreprise ainsi que des responsables fédéraux, étatiques et locaux, et culminera avec un programme d’activités à l’Université de Syracuse. Selon son PDG, Sanjay Mehrotra, il s’agit d’un “moment décisif” tant pour la société que pour les États-Unis, dans un contexte où l’économie amorce une transition vers l’ère de l’IA.

La mémoire n’est pas “un composant de plus”: c’est le goulot d’étranglement de l’IA

La clé réside dans la mémoire — DRAM, NAND et, de plus en plus, HBM (High-Bandwidth Memory) — qui devient l’un des facteurs déterminants du rythme de déploiement de l’IA à l’échelle. À mesure que les modèles grossissent, que les centres de données se multiplient et que la demande de transfert et d’alimentation de données à grande vitesse augmente, l’absence de mémoire avancée limite l’efficacité du reste du système (GPU, réseaux, CPU et logiciels).

Dans cette optique, l’engagement de Micron est clair : une installation pouvant comporter jusqu’à quatre usines (fabs) visant à renforcer la capacité de production de mémoire de pointe sur le sol américain, particulièrement crucial lorsque la pénurie mondiale de composants critiques devient une question économique et de sécurité nationale.

De plus, ce projet s’inscrit étroitement dans la politique industrielle américaine. La page officielle du programme CHIPS (NIST/Department of Commerce) indique que Micron a reçu une financement direct de 6,44 milliards de dollars pour soutenir sa vision sur deux décennies : investir environ 100 milliards de dollars dans l’État de New York et 50 milliards en Idaho, dans le but d’accroître la part de fabrication de mémoire avancée aux États-Unis, passant de moins de 2 % actuellement à environ 10 % d’ici 2035. Ce même cadre mentionne également des financements pour la formation de la main-d’œuvre et des restrictions relatives aux incitations du CHIPS Act, rappelant que la relocalisation industrielle s’accompagne de conditions.

En termes d’emplois, les estimations varient selon l’étendue (directe, indirecte et chaîne d’approvisionnement). Le projet a été présenté comme la plus grande invasion privée de l’histoire de l’État de New York et, selon Reuters, il devrait générer plus de 50 000 emplois sur 20 ans, en comptant emplois directs et induits. La préparation de l’infrastructure énergétique suit également son cours : l’État a approuvé un câble de transmission souterrain de 345 kV pour relier une station électrique voisine à la future usine, une preuve tangible que l’industrie des semi-conducteurs est aussi une industrie électrique.

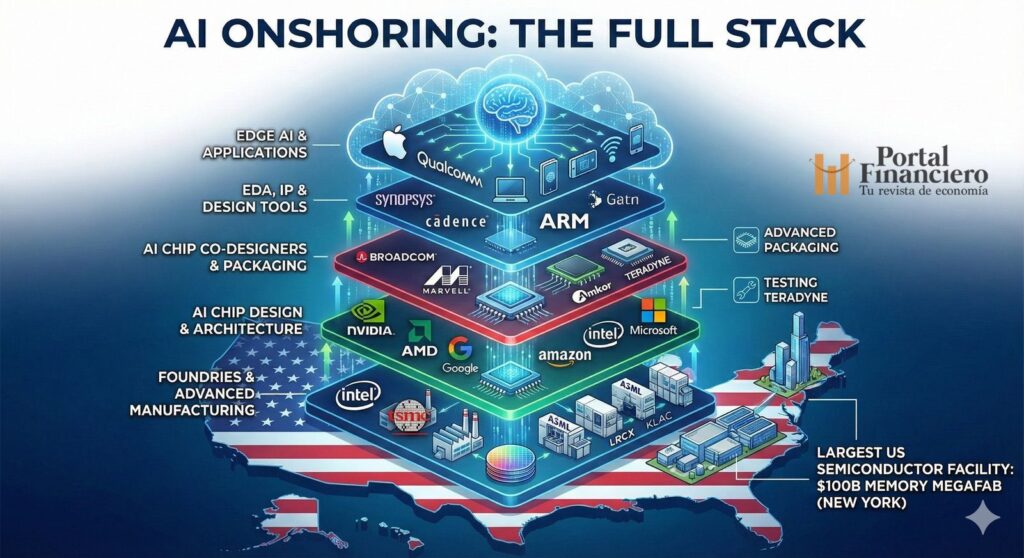

“Onshoring” de l’IA : la cartographie complète va bien au-delà de la mémoire

La nouvelle de Micron illustre une idée de plus en plus répandue dans le secteur : la mémoire n’est qu’une couche. Relocaliser l’IA implique de renforcer (et de reconstruire) un « stack » industriel complet, allant de la conception à l’emballage final.

1) Conception de puces pour l’IA (et la rivalité entre hyper-scalaires et fournisseurs)

L’entraînement, ainsi qu’une partie croissante de l’inférence, gravite encore essentiellement autour de la plateforme GPU, où NVIDIA maintient une position dominante pour l’entraînement selon les analyses du marché par Reuters. Cependant, le marché est devenu plus concurrentiel : AMD renforce son rôle en tant qu’alternative stratégique ; Google développe des TPU optimisées pour l’entraînement et l’inférence ; et AWS travaille sur Trainium et Inferentia pour réduire les coûts dans son cloud. Microsoft, de son côté, prône une approche « silice au service » avec ses propres puces pour Azure, afin d’optimiser toute son infrastructure.

2) Co-conception : systèmes « sur-mesure »

Parallèlement, la montée en puissance du silicium personnalisé pousse des acteurs comme Broadcom et Marvell — souvent présentés comme partenaires technologiques — à co-concevoir des composants et systèmes intégrant calcul, mémoire et réseaux, adaptés aux charges spécifiques de l’IA.

3) EDA et propriété intellectuelle : le coût invisible avant la fabrication

Avant même qu’un puce ne soit fabriquée, elle doit être conçue et validée à l’aide d’outils de EDA (Electronic Design Automation). Synopsys et Cadence jouent un rôle central dans ce secteur : sans leurs plateformes, le passage du design à un « silicium fonctionnel » serait beaucoup plus difficile. La propriété intellectuelle concerne également les architectures CPU : Arm, avec ses licences et ses architectures largement utilisées, constitue une composante essentielle de la computation dans les mobiles, l’edge et, de plus en plus, dans les serveurs.

4) Fonderies : qui fabrique le design (et où)

Même si les États-Unis encouragent le retour de capacités de production, l’industrie reste dépendante de grands fabricants sous contrat : TSMC demeure un acteur clé pour la fourniture de semi-conducteurs avancés. Par ailleurs, Intel cherche à se positionner comme une « seconde source » stratégique avec ses investissements dans la fonderie et la fabrication domestique, une ambition devenue pertinente dans un contexte géopolitique où calendriers et capacités sont influencés par la politique mondiale.

5) Équipements : le véritable « centre de gravité »

Dans la fabrication moderne, peu de noms ont autant d’impact qu’ASML, dont les machines de lithographie (notamment EUV) sont indispensables pour la production de nœuds avancés et de DRAM de pointe. Autour d’eux gravitent Lam Research, KLA et Tokyo Electron — parmi d’autres — qui fournissent des processus de dépôt, gravure, métrologie et contrôle, rendant possible la production à grande échelle. Applied Materials et Teradyne complètent ces étapes critiques, telles que la gestion des matériaux, l’implantation ou les tests et validations.

6) Emballage avancé : transformer la mémoire et le calcul en système

Enfin, la couche souvent décisive en termes de performance : l’emballage. Fusionner GPU et HBM ou autres composants dans des modules avancés requiert une industrie spécialisée. Amkor se distingue dans cette étape en aidant à transformer les puces en systèmes informatiques prêts pour les centres de données.

7) IA de proximité : l’IA aussi « relocalisée » dans la poche

La relocalisation ne concerne pas uniquement les grandes usines. Apple, avec sa Neural Engine et l’apprentissage automatique intégré, illustre la tendance à approcher l’inférence directement sur l’appareil, avec des bénéfices pour la vie privée et la latence. De son côté, Qualcomm développe NPUs et outils pour accélérer l’inférence à faible consommation dans les mobiles et appareils connectés, renforçant le rôle de l’edge dans l’architecture globale de l’IA.

Un message en filigrane : l’IA est déjà une politique industrielle

Le mégacomplexe de Micron, au-delà de sa dimension, adresse un signal : l’IA n’est plus simplement une course dans le logiciel. Elle concerne également une course aux usines, à l’énergie, aux talents et aux chaînes d’approvisionnement. Dans cette compétition, les États-Unis tentent de reconstruire des pièces longtemps délocalisées.

La question qui reste en suspens est de savoir si le « stack » complet pourra s’aligner. Car fabriquer de la mémoire avancée est une étape énorme, mais une IA « onshore » ne devient concrète que lorsque conception, outils, fonderie, équipements, emballage et déploiement s’harmonisent parfaitement, aussi exigeants qu’un seul circuit.

Questions fréquentes

Pourquoi la mémoire HBM est-elle si cruciale pour l’IA générative dans les centres de données ?

Parce qu’elle fournit aux accélérateurs (comme les GPU) une bande passante bien supérieure à celle des mémoires traditionnelles, évitant ainsi les goulets d’étranglement lors de l’entraînement et de l’inférence à grande échelle.

Que signifie que Micron soit « le seul fabricant américain de mémoire » ?

Que, face à un marché historiquement concentré en Asie pour la mémoire avancée, Micron incarne la base industrielle domestique aux États-Unis dans ce secteur, ce qui est crucial pour la résilience et la sécurité d’approvisionnement.

Comment le CHIPS Act influence-t-il des projets comme la megafab de Micron à New York ?

Il offre des incitations et un financement public pour accélérer les investissements privés, avec des conditions et un suivi des étapes, afin d’augmenter la capacité de production nationale de semi-conducteurs stratégiques.

Quelles parties du « stack » industriel de l’IA sont les plus difficiles à relocaliser ?

Ceux qui dépendent de machines et de savoir-faire très spécialisés (lithographie et processus de fabrication), ainsi que celles nécessitant des écosystèmes matures (EDA, emballage avancé, chaîne de fournisseurs et main-d’œuvre qualifiée).

Source : Portal Financiero