La technologie de mémoire pour les cartes graphiques est sur le point de faire un bond significatif avec l’introduction de la mémoire HBM4HBM4 est la prochaine évolution dans la technologie de mémoire,…, qui promet de doubler la bande passante disponible pour les GPU dédiés à l’intelligence artificielle. Contrairement à ses prédécesseurs, la HBM4 de nouvelle génération présentera une interface impressionnante de 2 048 bits, ouvrant de nouvelles possibilités en termes de performance et de capacité.

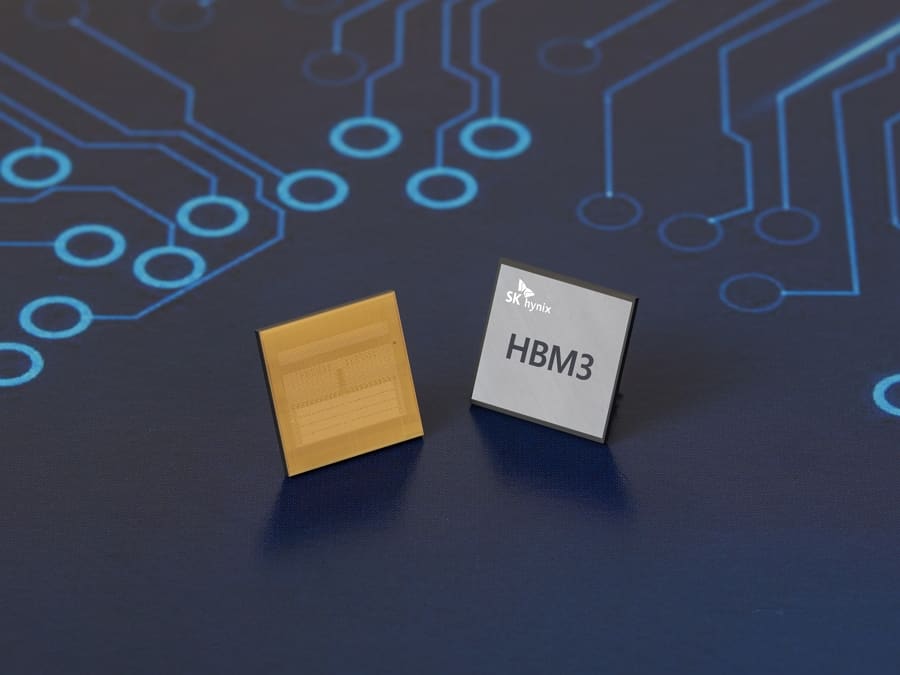

Depuis ses débuts en 2015 avec l’AMD Radeon R9 Fury X, la mémoire à haute bande passante (HBM) a été une technologie transformatrice dans le domaine des cartes graphiques. Toutefois, les limitations initiales en matière de capacité et de vitesse ont été surmontées avec chaque nouvelle génération, culminant avec la HBM3E, qui atteint des vitesses allant jusqu’à 1,2 To/s par empilement. Maintenant, la HBM4 cherche non seulement à poursuivre cette tendance, mais aussi à établir de nouvelles normes d’efficacité et de performance.

Innovations et améliorations de la HBM4

La mémoire HBM4 se distingue non seulement par sa bande passante impressionnante, mais aussi par sa capacité à réduire le nombre de couches d’empilement nécessaires. Avec une interface de 2 048 bits, la HBM4 pourrait nécessiter seulement la moitié des empilements comparée à la HBM3 pour atteindre une interface totale équivalente. Cela pourrait signifier une moindre consommation d’énergie et une plus grande efficacité dans l’empaquetage des puces.

Ce développement est crucial pour les applications d’intelligence artificielle, où la vitesse et la capacité de traitement sont fondamentales. Avec la promesse de la HBM4, les GPU pourront traiter de grands volumes de données plus rapidement, ce qui est essentiel pour entrainer des modèles d’IA plus complexes et effectuer des inférences en temps réel.

Collaborations stratégiques et l’avenir de la HBM4

Des entreprises leaders telles que NVIDIA et SK Hynix collaborent étroitement pour optimiser l’intégration de la mémoire HBM4 directement sur le GPU. Cette approche, semblable à la technologie 3D V-Cache d’AMD, cherche à minimiser la latence en plaçant la mémoire aussi près que possible du cœur de traitement du GPU. Cette intégration améliore non seulement la performance, mais reflète également une avancée significative dans la conception matérielle pour les applications gourmandes en données.

Impact sur le marché et défis futurs

Bien que la HBM4 ne sera pas disponible avant la révélation récente de la HBM3E en 2023, son développement est étroitement suivi par l’industrie. Les implications d’une mémoire plus rapide et plus efficace sont énormes, non seulement pour la conception matérielle, mais aussi pour l’avancement des technologies émergentes comme l’intelligence artificielle et l’apprentissage profond.

Toutefois, les défis ne sont pas moindres, en particulier en termes d’intégration et de coûts de production. L’adoption généralisée de la HBM4 dépendra de la manière dont ces défis sont gérés dans les années à venir, ainsi que de la capacité de l’industrie à suivre le rythme des demandes croissantes de traitement de données.

En résumé, la mémoire HBM4 est configurée pour être un changement de jeu dans le monde des GPU pour l’IA, offrant des améliorations significatives en termes de bande passante et d’efficacité. Avec son lancement en vue, elle pourrait très bien inaugurer une nouvelle ère dans la conception et la fonctionnalité des cartes graphiques.