Google lance sa septième génération de TPU, "Ironwood", pour révolutionner l’inférence en IA

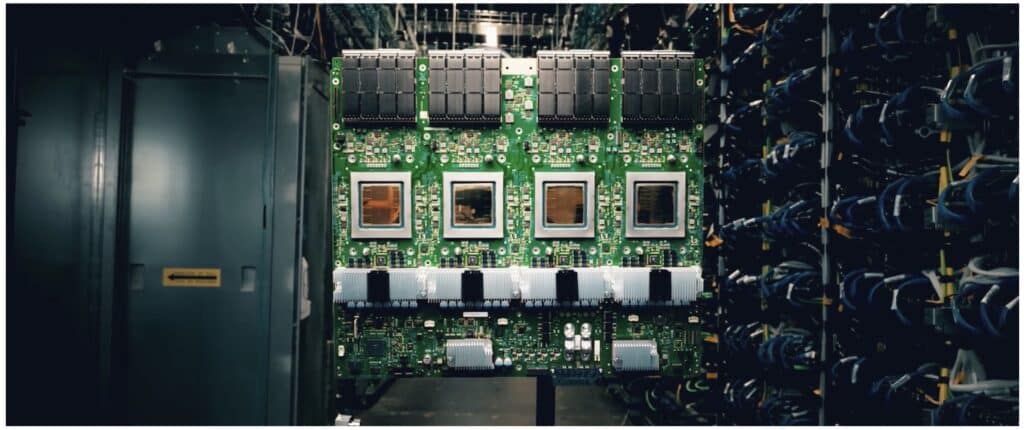

Lors de l’événement Google Cloud Next 2025, la célèbre entreprise technologique a présenté "Ironwood", son nouveau TPU (Tensor Processing Unit) de septième génération. Conçu entièrement pour accélérer l’inférence des modèles d’intelligence artificielle dans le cloud, "Ironwood" représente un saut technologique sans précédent depuis le lancement de la première TPU en 2016.

Avec cette nouvelle architecture, Google réinvente son infrastructure d’intelligence artificielle pour s’adapter à un nouveau paradigme : le passage de modèles réactifs à des modèles pouvant penser et agir proactivement. Ce changement marque le début de ce que Google appelle l’“ère de l’inférence”.

Une avancée spectaculaire en puissance de calcul

Ironwood peut évoluer jusqu’à 9 216 puces par pod, offrant une puissance brute de 42,5 exaflops, plus de 24 fois la capacité de l’ordinateur le plus puissant au monde, El Capitan (1,7 exaflops). Chaque puce atteint un rendement de 4 614 teraflops (FP8) et est dotée de 192 Go de mémoire HBM, avec 7,2 To/s de bande passante, des chiffres qui repoussent toutes les limites précédentes de l’informatique dans le cloud.

Cette puissance massive est conçue pour gérer des modèles tels que Gemini 2.5 ou AlphaFold, ainsi que de futures architectures de LLMs (Large Language Models) et MoEs (Mixture of Experts), nécessitant un traitement parallèle extrême et un accès à une mémoire ultra-rapide.

Conçue pour l’inférence, pas seulement pour l’entraînement

Alors que de nombreuses architectures d’IA actuelles sont optimisées pour l’entraînement, Ironwood a été développée spécifiquement pour maximiser l’inférence à grande échelle. Cela se traduit par des latences plus faibles, une efficacité énergétique améliorée, et une capacité supérieure à servir des modèles à des milliers d’utilisateurs simultanément dans le cloud.

Sundar Pichai, PDG de Google, déclare : "L’ère de l’inférence est celle où les modèles ne se contentent pas de réagir, mais comprennent, interprètent et agissent. Ironwood est notre engagement à mener cette transition."

Une architecture optimale pour la performance et l’efficacité

Ironwood ne brille pas seulement par sa puissance, mais aussi par son efficacité thermique et énergétique. Grâce à un système de refroidissement par liquide et à une ingénierie des puces optimisée, Ironwood réalise un rendement deux fois supérieur par watt par rapport à la génération précédente, Trillium, et jusqu’à 30 fois plus efficace que la TPU v2 de 2018.

Deux configurations pour s’adapter à chaque charge de travail

Ironwood sera disponible en deux configurations principales dans Google Cloud :

- Ironwood 256 : destinée aux startups et aux entreprises nécessitant des performances avancées sans déployer une infrastructure de grande échelle.

- Ironwood 9 216 : ciblée vers les leaders du secteur, tels que les laboratoires de recherche et les fournisseurs de LLMs, nécessitant l’entraînement et le service de modèles avec des billions de paramètres en temps réel.

Une solution flexible pour des workloads non traditionnels

Ironwood n’est pas seulement conçue pour les LLMs ou les modèles génératifs, mais incorpore également des améliorations dans SparseCore, un accélérateur d’inférence spécialisé dans les grands embeddings, de plus en plus courants dans les secteurs des finances, de la santé et des simulations scientifiques.

Conclusion : Ironwood, l’avenir de l’inférence en IA

En consolidant sa position comme le fournisseur le plus expérimenté en informatique pour l’IA avec Ironwood, Google inaugure une offre de AI-as-a-Service permettant à toutes les entreprises de déployer des modèles puissants sans avoir à construire leur propre infrastructure.

Ironwood marque une avancée significative dans l’infrastructure cloud pour l’intelligence artificielle, ouvrant la voie vers un avenir où l’entraînement et le service de modèles seront un atout concurrentiel pour ceux qui se fieront à la cloud comme plateforme d’innovation.

Source : Blog Google