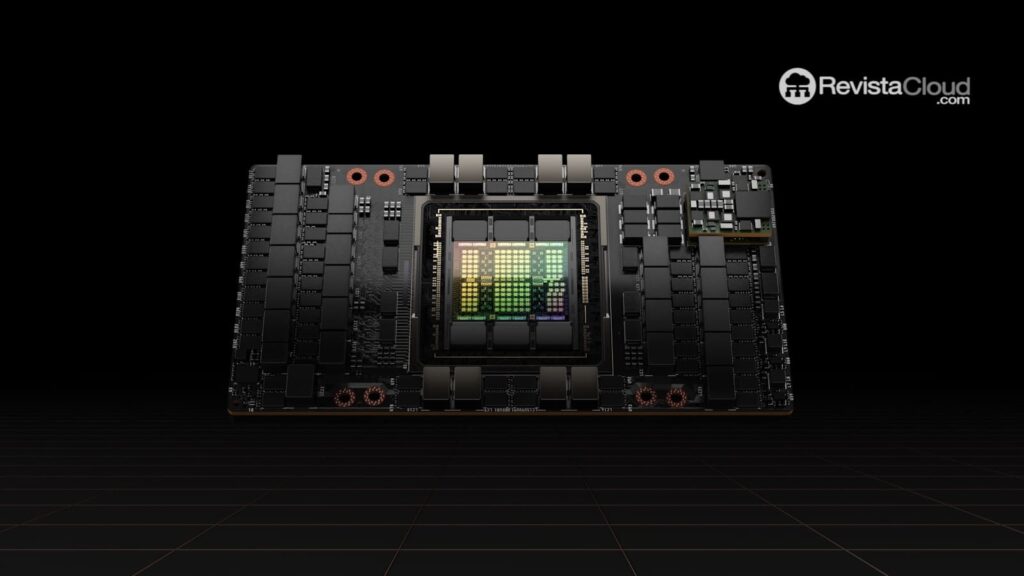

IBM a franchi une étape significative dans l’amélioration de ses capacités de calcul dans le cloud en annonçant l’intégration des GPU Nvidia H100 à sa plateforme IBM Cloud. Cette mise à jour permettra aux clients d’accéder à des performances supérieures pour leurs charges de travail en intelligence artificielle (IA), tant pour les tâches d’entraînement que d’inférence.

Amélioration significative des performances

L’introduction des GPU H100 représente une avancée notable par rapport aux précédents Nvidia A100, que IBM avait implémentés l’année dernière. Selon les informations fournies par Nvidia, ces nouveaux processeurs graphiques offrent des performances d’inférence jusqu’à 30 fois plus rapides que leurs prédécesseurs.

Une variété d’options pour différents besoins

En plus des puissants H100, IBM Cloud continue de proposer une gamme diversifiée de GPU pour s’adapter à différentes échelles de projets d’IA :

- GPU Nvidia A100 : Pour des charges de travail d’IA de haute performance.

- GPU Nvidia L40S et L4 : Conçus pour des tâches d’IA à plus petite échelle, telles que l’entraînement de modèles de petite taille ou la mise en place de chatbots.

Disponibilité mondiale et plans futurs

Les nouvelles instances avec H100 sont disponibles dans les régions multi-zones d’IBM en Amérique du Nord, en Amérique Latine, en Europe, au Japon et en Australie. De plus, la compagnie a annoncé des plans pour proposer les processeurs IA Intel Gaudi 3 à travers IBM Cloud au début de 2025, élargissant encore plus ses choix de matériel spécialisé.

Positionnement sur le marché

Malgré cette avancée, il est important de souligner que IBM Cloud est en retard par rapport à ses principaux concurrents dans l’adoption des GPU H100. Des entreprises telles qu’Amazon Web Services (AWS), Google, Microsoft et Oracle ont lancé des instances avec ces GPU il y a plus d’un an. Même des startups spécialisées dans les GPU dans le cloud, telles que CoreWeave et Cirrascale, ont eu un accès prioritaire à cette technologie.

L’avenir des GPU dans le cloud

Le marché des GPU pour l’IA évolue rapidement. Les principaux fournisseurs de services en cloud, y compris Oracle, Amazon, Microsoft et Google, ont déjà annoncé des plans pour déployer la prochaine génération de GPU Nvidia, connue sous le nom de série Blackwell. Nvidia s’attend à expédier « plusieurs milliards de dollars » de GPU de dernière génération au quatrième trimestre de 2024.

Restructuration chez IBM Cloud

Au milieu de ces avancées technologiques, des changements significatifs ont été rapportés dans la structure du personnel d’IBM Cloud. Selon des rapports récents, la division serait en train de mener un programme de licenciements à grande échelle, bien que de manière discrète. IBM a répondu à ces allégations en indiquant que les ajustements dans la main-d’œuvre représenteraient un pourcentage très bas de son effectif global, en espérant maintenir des niveaux d’emploi similaires à ceux du début de l’année 2024.

L’intégration des GPU Nvidia H100 à IBM Cloud marque un jalon important dans la stratégie de la compagnie pour concurrencer sur le marché des services d’IA dans le cloud, bien que l’impact réel de cette mise à jour sur sa position concurrentielle reste encore à voir.

via: DCD