La course à la mémoire HBM4 — le « carburant » qui alimente les GPU pour l’intelligence artificielle — entre dans une phase particulièrement critique : celle des derniers ajustements avant la validation finale. Dans cette pression, le leader actuel du marché, SK Hynix, a une nouvelle fois modifié sa stratégie avec une série d’échantillons améliorés destinés à Nvidia, dans l’objectif de finaliser rapidement le processus de qualification au cours du premier trimestre. Parallèlement, Samsung Electronics se positionne comme un concurrent sérieux pour intégrer la chaîne d’approvisionnement de Nvidia avec son HBM4 de 12 couches, laissant entrevoir une possible mise en production pour des clients dans les semaines à venir.

Au-delà de ces titres, se cache une réalité moins spectaculaire mais essentielle : dans le domaine des mémoires empilées comme le HBM, la transition générationnelle ne se limite pas à plus de performance. Elle repose sur une combinaison équilibrée entre performance, fiabilité et fabricabilité. C’est cette harmonie qui explique pourquoi SK Hynix revoit et révise sans cesse ses échantillons finaux, même après livraison de Customer Samples (CS) et après avoir dû repenser le circuit suite à des tests SiP (System-in-Package).

Que signifie « qualifier » le HBM4 avec Nvidia (et pourquoi ces révisions répétées) ?

La validation par un client comme Nvidia n’est pas un simple processus : c’est un filtre rigoureux. Les mémoires HBM s’empilent, s’interconnectent et s’intègrent dans un package complexe où chaque paramètre — latences, intégrité du signal, stabilité thermique, comportement sous charge, marges de tension — peut impacter la performance… et surtout, la performance à grande échelle.

Une seule évaluation positive d’un échantillon ne garantit pas sa conformité pour la production en série. Un échantillon peut fonctionner en laboratoire mais échouer lors de sa fabrication fiable, avec un yield acceptable, ou ne pas répondre aux exigences de vitesse et de consommation fixées par le client. Dans ce contexte, il est habituel que l’industrie passe par plusieurs cycles d’optimisation : correction des détails détectés lors des tests de lot (SiP), ajustement des marges pour préserver le yield, et modifications du design pour satisfaire des exigences spécifiques du client.

Chez SK Hynix, il s’agit d’une phase finale de polissage. La société continue à fournir des échantillons modifiés, y compris à titre payant, tout en élaborant une nouvelle version encore plus affinée pour les tests de qualification, avec des résultats attendus dans le premier trimestre.

Nvidia ne peut pas attendre : « Rubin » nécessite une cadence de livraison stable

Le calendrier est dicté par la prochaine plateforme de Nvidia. La société prépare la transition vers « Rubin » — sa prochaine génération — et, selon les dynamiques du marché, l’objectif n’est pas seulement d’arriver en avance : il faut aussi assurer un volume suffisant. C’est là que SK Hynix a une carte cruciale : bien que Samsung puisse accélérer le rythme de qualification, SK Hynix vise à maintenir une part importante de l’approvisionnement total pour l’année grâce à des contrats de volume négociés en amont.

En toile de fond, la dépendance du secteur de l’IA à l’égard de la chaîne d’approvisionnement en mémoires avancées devient de plus en plus évidente. Face à une demande croissante pour l’infrastructure IA, les fournisseurs de HBM deviennent des acteurs stratégiques, et tout goulet d’étranglement — qu’il s’agisse de capacité, de validation ou d’empaquetage — engendre des retards et des coûts supplémentaires.

Samsung intensifie ses efforts : 12 couches et ambition d’intégrer le « club Nvidia »

De son côté, Samsung a intensifié ses déclarations publiques concernant le HBM4 et sa compétitivité, tandis que le marché interprète ces signaux comme une possibilité de démarrer la production pour clients dès que les étapes restantes seront conclues.

Au-delà du marketing, la démarche est cohérente : dans le domaine du HBM, être parmi les premiers à intégrer la plateforme gagnante constitue presque une moitié de la victoire. Si Nvidia pousse « Rubin » vers la production, le gain pour le fournisseur qui parviendra à devenir une seconde source crédible — ou une alternative capable — est considérable. La dynamique concurrentielle indique que, même lorsqu’un fournisseur est en tête, le client cherche à réduire les risques et à améliorer ses marges de négociation.

Volume, pouvoir de négociation et enjeu prix

Un autre point délicat concerne le prix. Il est aujourd’hui admis que le HBM4 sera plus coûteux que la génération précédente, non seulement en raison de la complexité technique accrue, mais aussi à cause de la demande croissante et de la pression sur l’empaquetage avancé. Selon les estimations du secteur, le prix d’un HBM4 à 12 couches dépasse les 600 dollars, et des scénarios évoquent une parité entre fournisseurs lors des négociations, ce qui est notable comparé aux différences de prix plus importantes par le passé.

Ce détail revêt une importance stratégique : le HBM est l’un des composants qui influencent le plus le coût total d’une GPU IA. En conséquence, il impacte directement le coût par token, par entraînement ou par inférence dans les centres de données. Autrement dit, il ne s’agit pas seulement d’une avancée technologique : c’est une bataille sur la marge tout au long de la chaîne d’approvisionnement.

Le rôle discret de TSMC et le dilemme « plus rapide » versus « plus fiable »

La dernière étape d’optimisation implique souvent des choix difficiles. Si le client exige plus de vitesse, le design peut être poussé dans cette direction — mais cela peut compromettre la fabricabilité et le yield. C’est là qu’intervient un facteur de plus en plus évoqué dans le secteur : la coordination avec l’ensemble des acteurs de la chaîne (fonderies et intégrateurs) pour garantir un “marge” de sécurité, évitant que l’amélioration des performances ne se solde par un problème d’approvisionnement.

Au fond, la réussite ne dépend pas seulement du premier à présenter un échantillon fonctionnel, mais de celui qui livrera un produit capable de passer la qualification, d’être produit en volume et de maintenir une stabilité. Pour cette raison, dans le cas du HBM4, les révisions successives ne traduisent pas une faiblesse mais indiquent que le produit entre dans la phase critique où tout se joue.

Les prochaines étapes

Si la qualification est finalisée dans le premier trimestre, le marché passera à une seconde étape : la montée en cadence réelle, avec contrats, capacité engagée et une chaîne d’approvisionnement prête à répondre à une demande destinée à s’intensifier encore davantage pour cette nouvelle génération.

De leur côté, Nvidia compte sur la mémoire pour accompagner la ambition de « Rubin ». Samsung doit prouver que son HBM4 est non seulement compétitif, mais aussi sérieusement approvisionnable. Quant à SK Hynix, son objectif est de conserver le leadership, non seulement par la technologie, mais aussi en étant capable de garantir une capacité suffisante quand le moment viendra, avec un « oui » ferme à la clé.

Foire aux questions

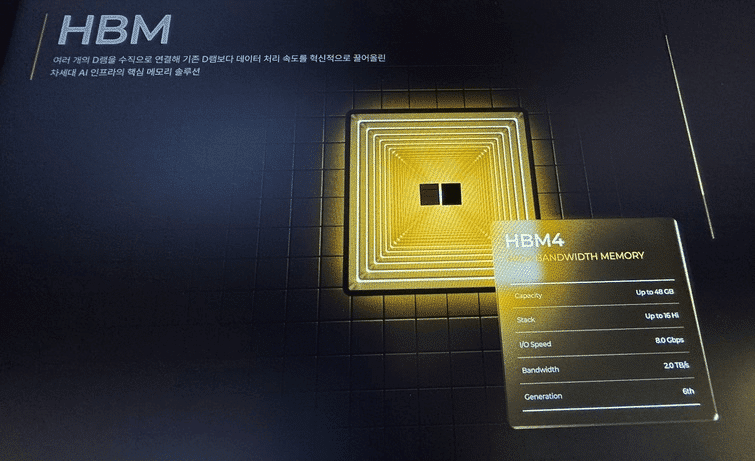

Qu’est-ce que la mémoire HBM4 et pourquoi est-elle si cruciale pour les GPU d’IA ?

La HBM4 représente une génération de mémoire empilée 3D à haut débit, conçue pour offrir une vitesse exceptionnelle et une efficacité énergétique optimale. Dans le domaine de l’IA, elle permet d’alimenter rapidement les accélérateurs en données, évitant ainsi les goulets d’étranglement qui limiteraient le rendement global.

Que signifie pour Nvidia « qualifier » une HBM4 ?

Cela signifie que la mémoire doit passer une série rigoureuse de tests techniques et de fiabilité dans un contexte précis de packaging et de plateforme. Il ne suffit pas qu’elle fonctionne : elle doit assurer stabilité, marges suffisantes et cohérence pour une production et un déploiement à grande échelle.

Pourquoi les échantillons sont-ils revus si souvent avant la production en série ?

Car la dernière étape consiste à équilibrer performance, consommation, stabilité thermique et rendement de fabrication (yield). Augmenter la performance peut réduire le yield, ce qui influence le volume et le coût final. Ces cycles de révision permettent d’optimiser ces paramètres pour assurer une production rentable et fiable.

Comment le prix de la HBM4 impacte-t-il le coût de formation ou de service des modèles d’IA ?

La HBM est un composant clé et coûteux dans l’équipement IA. Toute augmentation de son prix ou toute restriction de disponibilité influe sur le coût total des systèmes, ce qui se répercute sur le coût par entraînement ou inférence, affectant la viabilité économique du déploiement de ces modèles.

via : dealsite.co.kr