Depuis des années, la conversation dans les centres de données et les équipes IT oscillait entre deux extrêmes : des serveurs physiques dédiés pour les applications critiques et, de l’autre côté, des machines virtuelles permettant la consolidation et une plus grande flexibilité. Aujourd’hui, le paysage s’enrichit davantage. La virtualisation et la conteneurisation coexistent—et dans de nombreux environnements, elles se combinent pour répondre à une même exigence : faire plus avec moins, déployer plus rapidement et maintenir un contrôle rigoureux sur la sécurité, les coûts et l’exploitation.

Cette comparaison n’est pas nouvelle, mais le contexte lui, l’est. L’accélération du cloud hybride, l’essor de Kubernetes, l’obsession pour l’automatisation et l’avancée de l’IA ont transformé ces deux approches en une sorte de « grammaire » incontournable pour comprendre toute architecture moderne. Et bien qu’elles soient souvent perçues comme alternatives, en pratique, la véritable question est généralement autre : quelle combinaison offre le meilleur équilibre pour chaque charge de travail ?

Bare metal : la performance pure… avec un coût opérationnel

Le modèle bare metal (serveur physique avec système d’exploitation et applications s’exécutant directement dessus) demeure la référence quand il s’agit de performance sans couches intermédiaires. C’est une approche « traditionnelle » encore utilisée pour des charges exigeant des latences minimales, un accès direct au matériel ou des configurations très spécifiques (par exemple, certaines bases de données, le calcul haute performance ou des besoins réseau et stockage particuliers).

La valeur est claire : performance maximale et, souvent, comportement plus prévisible. Mais ses limites sont tout aussi évidentes : chaque serveur tend à devenir une « île », avec un utilisation irrégulière des ressources, un déploiement plus lent et une gestion moins flexible. Dans un monde où les équipes doivent déplacer des charges, tester des versions et automatiser rapidement les déploiements, le bare metal pur est généralement réservé aux cas où ses avantages justifient le coût de sa gestion.

Virtualisation : isolation renforcée et consolidation, au prix d’un « poids » supplémentaire

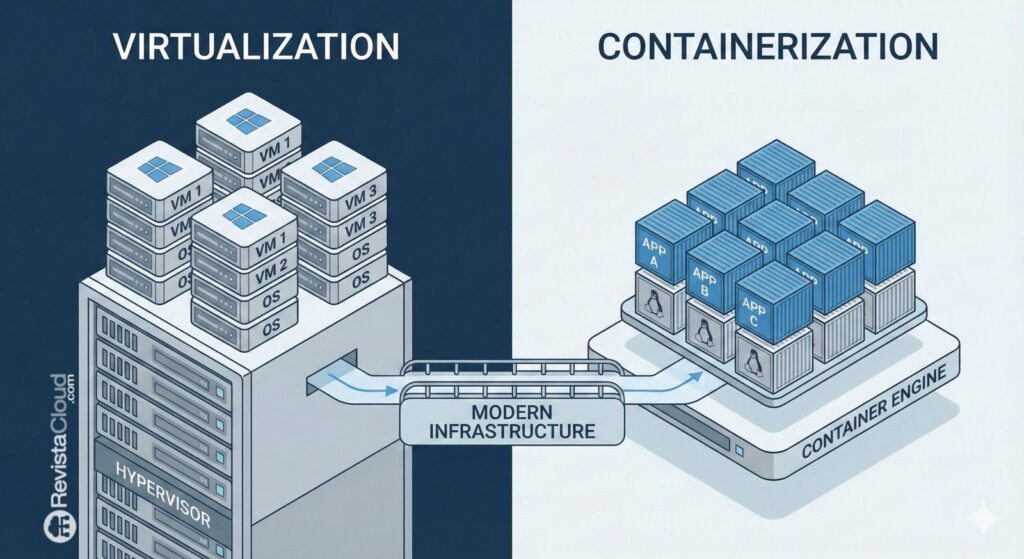

La virtualisation a changé la donne en permettant à un seul serveur physique d’héberger plusieurs machines virtuelles (VM) via un hyperviseur. Chaque VM inclut son propre système d’exploitation invité, assurant un isolement très robuste entre les environnements. Sur le plan professionnel, cette capacité a été clé : séparer applications, départements ou clients dans des compartiments plus sûrs, avec un niveau d’indépendance au niveau système.

La virtualisation brille particulièrement dans les scénarios où il faut :

- Une séparation claire entre charges (production vs testing, différents clients, environnements réglementés).

- Une compatibilité avec des systèmes d’exploitation hétérogènes (par exemple, coexistence de Linux et Windows).

- Des outils matures pour la haute disponibilité, les snapshots, la migration à chaud et la gestion centralisée (selon la plateforme).

La contrepartie est connue : chaque VM supporte le coût de son propre système d’exploitation. Cela signifie une augmentation de la consommation CPU et mémoire, davantage de correctifs, une surface d’administration plus grande et, dans certains cas, un rendement légèrement inférieur par rapport à une exécution directe (selon la charge de travail et la configuration).

Néanmoins, l’équilibre reste très attractif pour des milliers d’organisations. Il n’est pas rare que des noms comme VMware, Hyper-V, Proxmox ou des solutions basées sur KVM fassent partie des éléments essentiels de toute infrastructure moderne.

Conteneurisation : rapidité et efficacité, avec une isolation différente

La conteneurisation a popularisé une approche plus légère : au lieu d’isoler tout un système d’exploitation par application, les conteneurs partagent le noyau du système d’exploitation hôte et empaquettent l’application avec ses dépendances. Le résultat est une unité beaucoup plus portable, rapide à démarrer et facile à dupliquer.

Des moteurs et runtimes tels que Docker (historiquement très répandu en développement), ainsi que des technologies aujourd’hui courantes en production comme containerd ou CRI-O, en particulier dans l’écosystème Kubernetes, entrent en jeu.

Leurs atouts sont résumés en trois idées :

- Efficacité : moins de surcharge qu’une VM traditionnelle.

- Vitesse : déploiements et scalabilités beaucoup plus rapides.

- Portabilité : « fonctionne partout » dès que la base et le runtime sont compatibles.

C’est pourquoi la conteneurisation est devenue le langage naturel des microservices, des pipelines CI/CD, des équipes DevOps et des plateformes cloud-native.

Il est aussi important de souligner sa limite la plus discutée : l’isolation. Bien que les conteneurs isolent processus, réseau et système de fichiers à un niveau très utile, ils ne sont pas équivalents à une VM en termes de séparation du noyau. Cela ne signifie pas qu’ils soient « non sécurisés » par défaut, mais qu’ils exigent de la discipline : politiques de sécurité, contrôle des permissions, hardening de l’hôte, gestion des images, détection des vulnérabilités et, lorsque nécessaire, outils comme seccomp, AppArmor/SELinux ou des profils restrictifs.

Conteneurs sur virtualisation : la combinaison qui domine le monde réel

En pratique, le modèle le plus répandu chez les entreprises et fournisseurs cloud est celui hybride : conteneurs exécutés dans des machines virtuelles. Autrement dit, d’abord la virtualisation pour isoler les environnements et simplifier l’exploitation ; ensuite, la conteneurisation pour gagner en agilité et efficacité à l’intérieur de chaque domaine.

La logique est simple :

- Les VM offrent un périmètre d’isolation renforcé et un cadre opérationnel bien connu.

- Les conteneurs permettent de déployer et de faire évoluer rapidement les applications, de standardiser l’empaquetage et d’automatiser.

Cette approche est particulièrement fréquente avec Kubernetes, où un cluster tourne souvent sur des nœuds virtualisés (ou physiques, selon le cas). Pour de nombreuses organisations, cette couche de VM apporte une tranquillité d’esprit : segmentation, contrôle du cycle de vie du système d’exploitation du nœud, compatibilité avec des outils de sauvegarde/snapshots et une frontière claire entre équipes ou clients.

Le résultat est un « meilleur des deux mondes » qui, même avec un léger surcoût, correspond au type d’opération privilégié : plateformes multi-tenant, environnements hybrides, déploiements par étapes et besoin constant d’automatisation.

Alors, que choisir ?

Il n’y aucune réponse universelle. Le choix dépend souvent de quatre variables :

- Performance et latence : si le matériel prime, le bare metal ou la virtualisation très optimisée sont préférés.

- Isolation et conformité : si la séparation est cruciale, la virtualisation reste la norme standard.

- Agilité et scalabilité : si des déploiements fréquents et une montée en charge automatisée sont nécessaires, la conteneurisation devient difficile à ignorer.

- Opérations et outils : la capacité de l’équipe à gérer efficacement, si elle n’implique pas de compromis sur les exigences métier.

La conclusion n’est pas que l’un remplace l’autre, mais que les deux constituent des couches complémentaires pour bâtir des infrastructures plus efficaces, évolutives et automatisées.

Preguntas frecuentes

Quelle différence y a-t-il entre une machine virtuelle et un conteneur en termes d’isolation ?

Une machine virtuelle inclut son propre système d’exploitation invité et isole au niveau de l’hyperviseur, tandis qu’un conteneur partage le noyau du système hôte et isole processus et ressources à l’aide de mécanismes du système d’exploitation.

Quand privilégier le bare metal plutôt que la virtualisation ou les conteneurs ?

Il est généralement conseillé pour des charges nécessitant des performances très strictes, une faible latence ou un accès direct à un matériel dédié (par exemple, certaines bases de données, réseaux à très haute vitesse ou configurations avancées).

Pourquoi de nombreuses entreprises exécutent Kubernetes sur des machines virtuelles ?

Parce que les VM offrent une couche supplémentaire d’isolation et simplifient la gestion avec des outils connus (segmentation, snapshots, politiques de sauvegarde, séparation par environnement ou client), tout en permettant à Kubernetes d’automatiser et d’orchestrer les conteneurs.

La conteneurisation remplace-t-elle VMware, Hyper-V ou Proxmox ?

Pas nécessairement. Dans beaucoup d’environnements, la conteneurisation s’appuie sur la virtualisation pour renforcer l’isolation et l’organisation. Ces technologies ont tendance à cohabiter et à se compléter plutôt qu’à s’affronter directement.

Comment favoriser une communication plus fluide entre les équipes et éviter la communication fragmentée ?