L’explosion de la demande en intelligence artificielle ne se limite pas à la transformation des centres de données : elle pousse également la computation à se rapprocher des utilisateurs, en sortant du cœur du réseau. Dans cette compétition pour réduire la latence — et pour garantir la souveraineté des données — chaque kilomètre de fibre optique compte. C’est pourquoi l’annonce provenant de Barcelone par Submer, fournisseur d’infrastructures pour l’IA, ne se résume pas à un simple titre corporatif : elle répond à une pièce que de nombreux acteurs tentaient d’insérer de force dans leur stratégie.

Submer a annoncé son acquisition de Radian Arc Operations Pty Ltd, un fournisseur de plateforme d’infrastructure en tant que service (IaaS) destinée à déployer des services cloud GPU souverains « intégrés » dans les réseaux de télécommunications. Cette opération, dévoilée le 10 février 2026, poursuit une vision claire : offrir une pile technologique complète qui relie des usines d’IA situées dans des centres de données avec une capacité de calcul accélérée en périphérie, directement dans le réseau de l’opérateur.

De la GPU dans le centre de données… à la GPU dans le réseau de transport

Une réalité inconfortable s’installe sur le marché : l’IA devient une question d’infrastructure, et cette infrastructure dépend désormais de l’emplacement géographique. Pour des scénarios d’inférence à faible latence, de jeux en cloud, de vidéos intelligentes, d’analyses en temps réel ou d’assistants réagissant « en direct », le trajet jusqu’à un centre de données distant peut faire la différence entre un service utilisable et un service insupportable.

Radian Arc intervient précisément sous cet angle. Selon ses communications, sa plateforme est utilisée dans les réseaux télécoms pour supporter des charges telles que le cloud gaming et les workloads d’IA, où la performance et la retardation (latency) sont primordiales. De plus, elle met en avant un avantage de plus en plus valorisé en Europe et dans de nombreux pays : traiter les données « dans le pays », au sein d’une infrastructure locale, avec une intégration totale dans les systèmes de l’opérateur (y compris la facturation et la gestion des données).

Autrement dit : il ne s’agit pas simplement de louer des GPU, mais de transformer le réseau de l’opérateur en un plan de calcul distribué.

Une architecture à deux niveaux : le cœur et l’edge, avec la souveraineté comme message clé

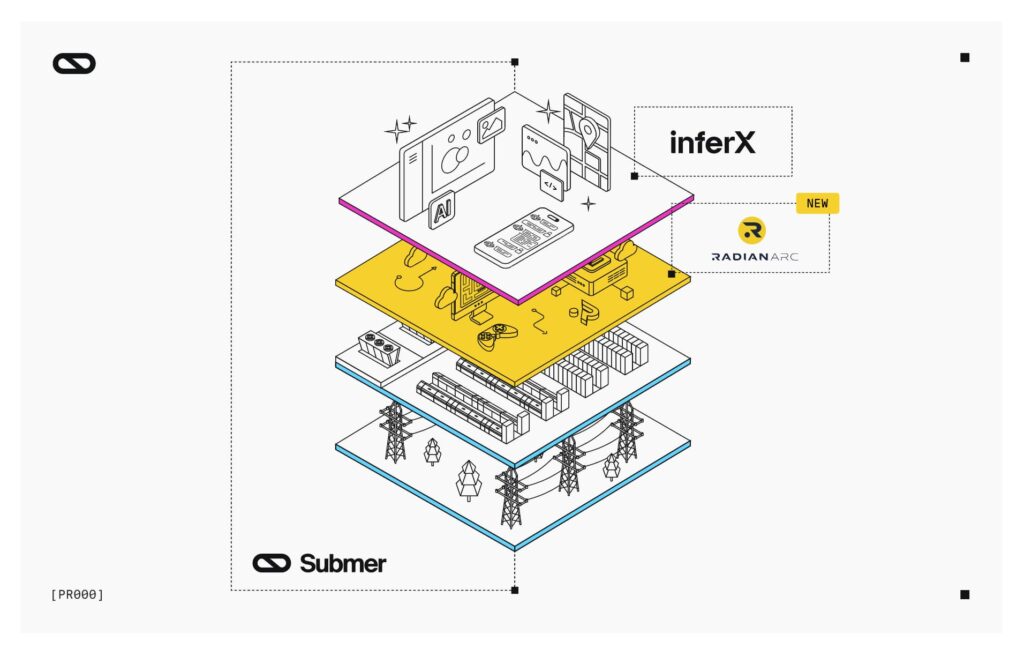

Cette acquisition s’inscrit dans la narrative que Submer souhaite bâtir autour de sa plateforme. La société explique que cette opération complète son offre « full-stack » en intégrant InferX — sa plateforme sous partenariat avec NVIDIA Cloud — avec la couche GPU en périphérie apportée par Radian Arc.

Le résultat, selon Submer, est une proposition à « double plan » :

- Plan central (core) pour déploiements d’IA à haute densité.

- Plan périphérique (edge, intégré aux réseaux telco) pour exécuter des services près de l’utilisateur final, avec une latence réduite et un contrôle local des données.

Radian Arc apporte également une dynamique opérationnelle : son communiqué mentionne des déploiements chez plus de 70 clients dans le secteur télécom et en périphérie à l’échelle mondiale, avec des milliers de GPU déjà en service. De son côté, Submer insiste sur son positionnement en tant que « partenaire unique » capable de couvrir l’ensemble du cycle, « de la puce à l’opération », en s’appuyant sur son expertise en refroidissement liquide, en conception et déploiement d’infrastructures modulaires.

Ce que cela change pour les opérateurs et les entreprises : moins de théorie, plus de produits

Au-delà des slogans, cette opération illustre une tendance qui se confirme en 2026 : les opérateurs cherchent à monétiser leur présence capillaire (et leurs investissements en 5G et fibre) via des services à valeur ajoutée, tout en évitant de devenir des intégrateurs incapables de gérer une multitude de composants incompatibles. Embrasser une plateforme unifiée, une opération intégrée et une livraison simplifiée accélère le délai de lancement commercial (« time to revenue »).

Concrètement, cette approche peut être particulièrement pertinente dans quatre scénarios :

- Services d’IA souverains pour le secteur public et réglementé

Lorsque la sécurité et la localisation des données exigent qu’elles restent « dans le pays », une infrastructure distribuée dans le réseau telco peut s’avérer un levier opérationnel essentiel. - Inference à faible latence et workloads interactifs

Jeux en cloud, copilotes industriels, analyses en streaming ou vidéos intelligentes en temps réel voient leur performance renforcée par une latence minimale et un jitter réduit. - Déploiements hybrides

Entraîner ou ajuster un modèle dans le cœur de réseau et déployer l’inférence en périphérie devient une tendance de plus en plus courante. La valeur dépasse le domaine technique en intégrant des considérations financières : où se paie le transport, l’énergie, la sortie de données ? - Scalabilité rapide « as-a-service »

Submer souligne que leur offre accélère les déploiements, surtout dans un contexte où la demande est imprévisible, tout en évitant d’importants investissements initiaux.

Une lecture stratégique : le edge redevenu central

Pendant de nombreuses années, le terme « edge » demeurait une promesse floue. La montée en puissance de l’IA le transforme en besoin essentiel. Si l’entraînement massif mobilise d’immenses clusters, l’inférence ubiquitaire exige d’être proche de l’utilisateur. La souveraineté — comprise comme contrôle territorial, réglementaire et opérationnel — devient un argument d’achat, au-delà du simple débat politique.

Submer va également plus loin, en évoquant une échelle élargie : leur communiqué mentionne un pipeline de sites et d’énergies de plus de 5 GW via des consortiums partenaires au Royaume-Uni, aux États-Unis, en Inde et au Moyen-Orient. Dans un marché où le véritable goulot d’étranglement n’est pas toujours la puissance GPU mais plutôt l’obtention des permis, la capacité et la refroidissement, cette déclaration souligne une intention claire.

Résumé rapide : ce que chaque composant apporte au « stack »

| Couche | Ce qu’elle apporte | Utilisations principales |

|---|---|---|

| Submer (infrastructure) | Conception, construction et exploitation d’infrastructures IA à haute densité | Fabrication d’IA à grande échelle et déploiements massifs |

| InferX (plateforme) | Plan opérationnel/délivrance pour cloud GPU (partenaire NVIDIA Cloud) | Offre de capacités GPU sous gouvernance comme service |

| Radian Arc (edge telco) | Plateforme IaaS de GPU intégrée aux réseaux opérateurs | IA et cloud gaming avec faible latence et souveraineté locale |

Questions fréquemment posées

Que signifie concrètement « GPU cloud souverain » ?

Cela implique que le traitement et le stockage des données peuvent se faire dans un pays ou une juridiction spécifique, sous contrôle opérationnel local, ce qui est crucial pour la gestion publique et les secteurs fortement régulés.

Pourquoi une telco serait-elle intéressée à intégrer des GPU dans son réseau ?

Pour offrir des services à faible latence (IA en temps réel, gaming, analytique) tout en monétisant sa présence large. Cela permet aussi de réduire la dépendance à des emplacements distants.

Cela remplace-t-il ou concurrence-t-il avec les géants du cloud ?

Souvent, cela vient en complément : le cœur du réseau peut continuer à utiliser les clouds publics ou privés, tandis que la périphérie couvre les cas où la latence, le coût ou la souveraineté sont décisifs.

Quels types de workloads profitent le plus du GPU en périphérie ?

Les inférences interactives, le cloud gaming, la vision par ordinateur en temps réel, le traitement vidéo, ainsi que les assistants avec réponse immédiate et l’analyse d’événements avec des exigences strictes en matière de latence.