La Chine a une nouvelle fois modifié la donne dans la course mondiale à l’intelligence artificielle. L’Institut d’automatisation de l’Académie chinoise des sciences (CASIA) a récemment dévoilé SpikingBrain-1.0, un modèle représentant non seulement une avancée technique notable, mais aussi un véritable coup géopolitique: pour la première fois, un modèle de pointe a été entraîné sans recourir aux puces NVIDIA ni à l’écosystème CUDA, et en adoptant une architecture différente de celle dominante dans le secteur.

Ce projet marque deux ruptures majeures avec le statu quo :

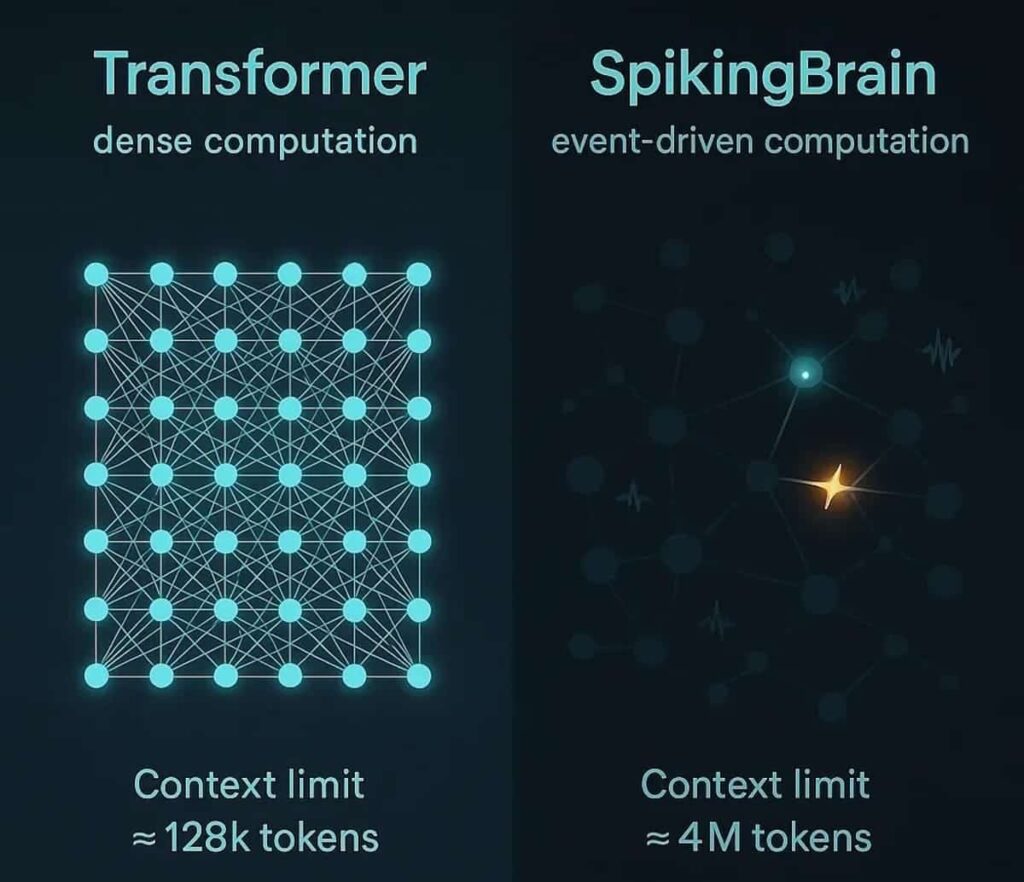

- Architecture innovante : au lieu des transformers, il utilise des réseaux neuronaux de pics (SNNs), inspirés du cerveau humain.

- Souveraineté technologique : l’entraînement s’est effectué exclusivement sur des GPU MetaX C550, produits en Chine.

Réseaux neuronaux de pics : une efficacité inspirée du cerveau

Les SNNs fonctionnent différemment des transformers. Au lieu d’activations continues, les neurones envoient des pulsations discrètes lorsqu’ils atteignent un seuil, à l’image du système nerveux biologique. Ce modèle de calcul orienté événement et hautement dispersé permet de diminuer la consommation énergétique tout en améliorant la rapidité de traitement sur de longues séquences.

Selon leur rapport technique, SpikingBrain-1.0 peut traiter des séquences allant jusqu’à 4 millions de tokens, une avancée considérable par rapport à la gamme de 128 000 à 1 million offerte par les modèles LM traditionnels. De plus, la version de 7 milliards de paramètres offre :

- 26 fois plus de vitesse en inférence pour 1 million de tokens.

- 100 fois plus rapide en inférence pour 4 millions de tokens.

Entraînement sans NVIDIA : la stratégie MetaX C550

Ce second pilier de cette avancée est le matériel. La Chine a réussi à entraîner SpikingBrain-1.0 sur des centaines de GPU MetaX C550, des accélérateurs conçus comme alternative nationale aux NVIDIA A100/H100.

Il s’agit d’un désolidarisation stratégique de l’infrastructure technologique dominée par les États-Unis, démontrant que Pékin peut progresser sur les modèles de pointe malgré les restrictions à l’export. Ce n’est pas seulement une prouesse technique : c’est aussi un message politique, visant à bâtir un stack d’IA souverain composé de matériel et de software indépendants.

Comparatif : SpikingBrain-1.0 face aux leaders actuels

Pour mieux comprendre l’impact de ce modèle, voici une comparaison avec les principaux LLM du marché :

| Modèle | Architecture | Matériel d’entraînement | Tokens max de contexte | Vitesse en contexte long | Dépendance à NVIDIA |

|---|---|---|---|---|---|

| SpikingBrain-1.0 | Réseaux de pics (SNN) | GPU MetaX C550 (Chine) | 4 000 000 | 26× plus rapide (1M), 100× plus rapide (4M) | Non |

| GPT-4.1 | Transformer | GPU NVIDIA H100 + CUDA | 200 000 – 1 000 000 | Élevée, mais avec une consommation énergétique importante | Oui |

| Claude Sonnet (Anthropic) | Transformer | GPU NVIDIA A100/H100 | 200 000 – 1 000 000 | Efficace en raisonnement, mais limité pour de longues séquences | Oui |

| Gemini 1.5 (Google DeepMind) | Transformer | TPUv5 + GPU NVIDIA | 1 000 000 | Optimisé pour le multimodal, pas pour des ultra-contexte | Partiel |

| Llama 3.1 (Meta) | Transformer (open source) | GPU NVIDIA A100/H100 | 128 000 – 256 000 | Correct pour l’inférence standard, non adapté pour de très longues séquences | Oui |

Une avancée aux implications mondiales

Le lancement de SpikingBrain-1.0 dépasse le seul aspect technique. Il marque le début d’un chemin alternatif à l’approche Silicon Valley, caractérisé par :

- La diversification architecturale : une démonstration que l’IA ne dépend pas uniquement des transformers.

- L’efficacité énergétique : les SNNs pourraient réduire drastiquement la consommation dans les centres de données.

- La souveraineté technologique : la Chine montre qu’elle peut entraîner des modèles de pointe sans dépendre des États-Unis.

- La géopolitique de l’IA : se reinforce l’idée d’un “monde bifurqué” en matière d’intelligence artificielle.

Une première étape vers l’IA neuromorphique

Bien que SpikingBrain-1.0 n’égale pas encore la capacité globale de géants comme GPT-4.1, sa valeur réside dans l’affirmation d’une direction différente. La computation neuromorphique, inspirée du cerveau, pourrait dépasser les limites actuelles de scalabilité et de durabilité, ouvrant la voie à une nouvelle génération d’IA.

Aujourd’hui, c’est une preuve de concept ambitieuse. Demain, elle pourrait devenir la norme.

Conclusion

Le lancement de SpikingBrain-1.0 dépasse le simple cadre académique : c’est une mise en garde pour le monde entier. La Chine ne souhaite pas seulement concurrencer l’IA, mais le faire avec son propre modèle technologique et politique. Bien qu’il lui reste du chemin avant de rivaliser avec les LLM leaders, l’accent mis sur les architectures neuromorphiques et le matériel national pourrait positionner le pays en leader dans la prochaine décennie.

En résumé : moins de transformers, plus de neurones intelligents, et pas d NVIDIA à l’horizon.

Questions fréquentes

Quels avantages offre SpikingBrain-1.0 par rapport à des modèles comme GPT-4 ?

Il propose des contextes beaucoup plus longs (jusqu’à 4 millions de tokens) et des performances jusqu’à 100 fois supérieures en inférence sur de longues séquences, tout en consommant moins d’énergie.

Sur quel matériel a été entraîné le modèle ?

Il a été entraîné sur des GPU MetaX C550, fabriquées en Chine, sans dépendre de NVIDIA ni de CUDA.

SpikingBrain-1.0 peut-il concurrencer GPT-4 ou Claude ?

Pas encore. Bien qu’il ne rivalise pas encore totalement en termes de performance globale, il ouvre une voie alternative prometteuse vers des architectures plus efficaces et durables.

Que signifie cet avancement d’un point de vue géopolitique ?

Il prouve que la Chine peut développer des modèles de pointe sans matériel américain, renforçant ainsi sa souveraineté technologique et accélérant le découplage entre les écosystèmes d’IA de l’Orient et de l’Occident.

via : ArViX