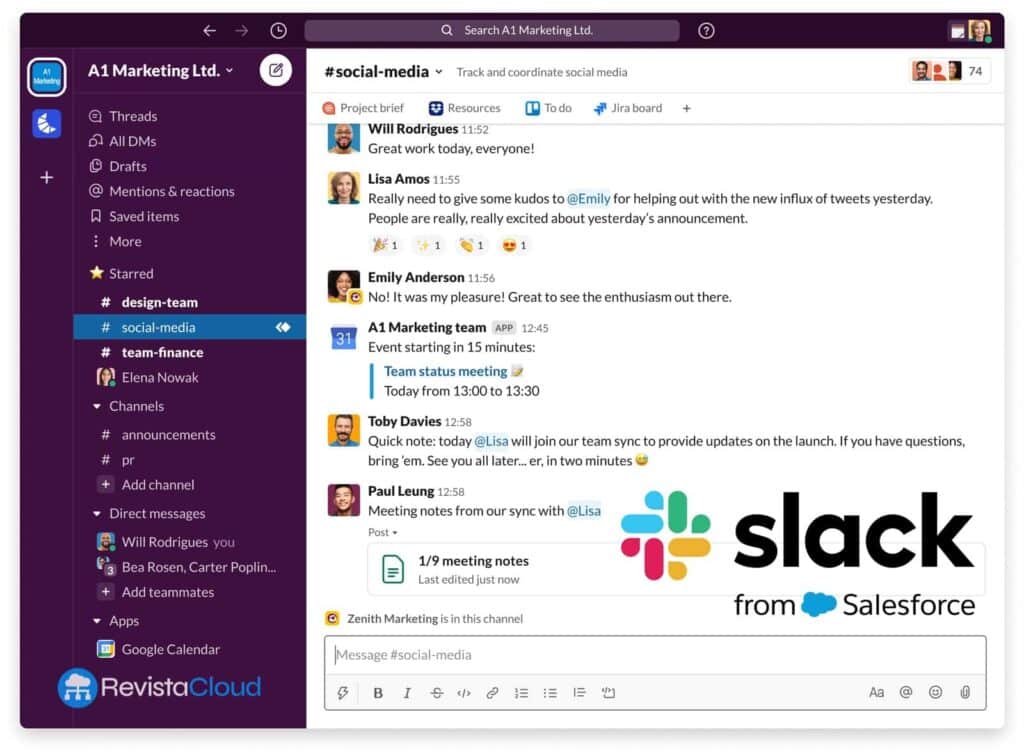

Slack, la plateforme de messagerie d’entreprise de Salesforce, souhaite devenir la couche de travail où résident — et sont réellement utiles — les agents d’IA. La société a présenté deux innovations techniques dans cette optique : une API de recherche en temps réel (RTS) et un serveur du Model Context Protocol (MCP). Ensemble, elles promettent quelque chose d’encore difficile à atteindre jusqu’à présent : permettre aux applications d’IA d’accéder, avec des permissions fines et sans copier les données, au contexte déjà présent dans Slack — messages, canaux, fichiers — et de l’utiliser pour répondre, décider et agir directement dans le flux de travail.

Ce mouvement n’est pas anodin. Dans l’économie des agents, les données conversationnelles sont l’or. Réunions, décisions, accords, doutes, “choses à faire”… Tout commence ou finit dans un fil de discussion. Mais ce corpus est souvent désorganisé et encastré. Slack veut l’ouvrir de façon contrôlée pour que l’IA cesse de répondre “en général” et commence à répondre précisément à des requêtes comme “ce que mon équipe a dit hier à 11h03 dans #ventes-emea”.

En plus de ces deux composants phares, la plateforme intègre Slack Work Objects (un standard pour intégrer des données d’applications tierces dans la conversation) et de nouvelles outils pour développeurs : pratiques recommandées pour l’IA, tableaux Block Kit pré-construits, un CLI amélioré pour les apps Bolt, et des améliorations du cycle de vie du développement. Tout cela repose sur une promesse essentielle : une sécurité de niveau entreprise et un respect total des permissions, demi-parcours à l’échelle utilisateur et canal.

Pourquoi maintenant : trop d’applications, peu d’usage, et 40 % de productivité perdue entre onglets

Slack place l’annonce dans un contexte connu mais persistant : la fragmentation. D’après ses données, il existe plus de 200 000 entreprises SaaS dans le monde, et une grande société utilise plus de 1 000 applications. Résultat : des sauts constants entre outils, du copier-coller, et un changement de contexte qui, selon Slack, peut réduire la productivité jusqu’à à 40 %. Presque la moitié des licences SaaS s’avèrent être du shelfware.

Slack mise sur implanter l’IA et les données directement dans la conversation — là où sont déjà les employés — plutôt que de les pousser vers une autre fenêtre. La PDG de Slack, Denise Dresser, résume : “L’avenir du travail est agentique et le succès de l’IA dépend de son intégration fluide dans les flux humains”. Si seulement 2 % du budget informatique est consacré à Slack, l’objectif est que ces 2 % maximisent le rendement du 98 % restant, indique la société.

API RTS : la conversation comme source de connaissance, sans “aspirer” de données

La Real-Time Search API fait office de canal. Elle permet à une application ou un agent de questionner Slack en temps réel pour obtenir des messages, fichiers et canaux pertinents en fonction des permissions de l’utilisateur qui lance la requête. Plutôt que de copier les données dans un autre service ou de faire un download en masse, l’agent demande uniquement ce qui est nécessaire (“donne-moi les cinq derniers messages où “SLA Q4 Europe” a été discuté dans les canaux auxquels j’ai accès”), reçoit uniquement ce qui est pertinent, et agit directement dans Slack.

Voici la proposition de valeur :

- Contexte à jour : réponses basées sur la conversation la plus récente, plutôt que sur une image obsolète.

- Moins d’hallucinations : l’agent ancre ses réponses dans des messages/fichiers réels, minimisant l’invention ou l’interprétation erronée.

- Gouvernance : la RTS respecte les permissions et limites; elle ne “ouvre” pas des DMs ou canaux privés à des personnes non autorisées.

Slack affirme que ses clients exploitant la connaissance conversationnelle peuvent en moyenne gagner 97 minutes par semaine et accélérer la prise de décision de 37 %, tout en répondant 36 % plus vite aux clients. Ce sont des chiffres internes, mais qui servent de boussole à la proposition.

Serveur MCP : un langage commun pour que les LLM découvrent le contexte et accomplissent des tâches

Le Model Context Protocol (MCP) est l’autre composante essentielle. Imaginez-le comme un bus entre LLMs, applications et Slack : un protocole unifié qui standardise comment un modèle accède à l’information contextuelle et exécute des tâches au nom de l’utilisateur, sans que le développeur ait besoin d’intégrer chaque service individuellement ou de décrire toutes les actions possibles.

Avec MCP, une app définit les données qu’elle peut exposer et les actions qu’elle peut réaliser (“créer un ticket”, “marquer une tâche comme terminée”, “joindre ce fichier”), et le LLM découvre ces possibilités avec un schéma unifié. Fini le catalogue de webhooks et d’endpoints hétérogènes par fournisseur : une seule route, en respectant les permissions.

Work Objects et outils pour développeurs : des données tierces “visibles et manipulables” dans le fil

Les Slack Work Objects apportent une couche visuelle et interactive. Un développeur peut lier les données de son application — descriptions, images, statuts, documents — à la conversation avec avancement enrichi. L’objectif : que l’utilisateur voit la pièce de travail (ticket Asana, dossier CRM, plan marketing) et agisse (par exemple, clôturer) sans quitter Slack.

Pour faciliter le quotidien du développeur, Slack lance des tables (Block Kit Tables) prêtes à l’emploi, des guides de bonnes pratiques IA, et un CLI pour Bolt avec ressources actualisées. La promesse : réduire le temps passé en infrastructure pour se concentrer sur l’expérience utilisateur finale.

Les acteurs majeurs qui s’engagent : Anthropic, Google, Perplexity, Writer, Dropbox, Notion…

Slack affirme que de grands noms utilisent déjà la RTS et/ou MCP :

- Claude (Anthropic) : l’assistant intervient dans Slack via DM, tableau ou @mention. Avec la RTS, cherche dans canaux, messages et fichiers (avec permissions) et fournit des réponses ancrées dans le contexte réel du travail en équipe.

- Google Agentspace : plateforme pour créer et gérer des agents à grande échelle. Avec la RTS, injecte le contexte de Slack dans Agentspace et inversement: insights d’Agentspace dans Slack.

- Perplexity Enterprise : fusionne les web et les conversations d’équipe pour fournir des réponses contextuelles, depuis Slack ou Perplexity.

- Dropbox Dash : exploite la RTS pour offrir un accès en temps réel à du contenu de Slack et Dropbox, en respectant les permissions.

- Notion AI : permet de questionner des fils ou discussions perdues ; la RTS facilite la recherche dans canaux publics, privés et en DM avec permissions, pour que Notion “reflète” l’état de Slack.

Le reste de l’écosystème — Writer, Cognition Labs, Vercel, Cursor — avance sur la même voie : apporter l’intelligence au flux de travail sans compromettre la sécurité ni copier les données.

Sécurité, conformité et marketplace : des éléments rassurants pour la DSI

Slack insiste sur son “approche de sécurité de niveau entreprise” : permissions granulaires, confidentialité et contrôles pour les tiers. Le message implicite : pas besoin d’extraire la conversation pour que l’IA la comprenne ; celle-ci arrive en respectant les mêmes règles que les utilisateurs.

Toutes ces applications sont hébergées dans le Slack Marketplace, qui agit comme une plateforme unique pour la distribution et le contrôle. Il ne s’agit pas seulement de connecter des outils : l’objectif est de construire un écosystème unifié de collaboration homme-IA où il est plus simple de découvrir, d’approbuer et de gérer les agents.

Disponibilités et feuille de route

- RTS API et MCP server : bêta fermée ; déploiement général prévu pour début 2026.

- Slack Work Objects : GA pour tous les développeurs d’ici fin octobre.

- Outils de développement orientés agents : déjà disponibles.

- Agents tiers utilisant ces capacités : déjà en place sur Slack Marketplace.

Slack précise que ces informations ne doivent pas servir de guide pour l’achat ; les délais et fonctionnalités peuvent évoluer selon la politique de Salesforce.

Ce que cela signifie pour les entreprises et les développeurs (au-delà du “buzz”)

Pour les entreprises, la promesse est double : moins de friction (l’IA “vit” là où travaillent les gens) et plus de confiance (permissions respectées, sans export massif). Si le bot doit voir quelque chose, il le demande ; sinon, il ne le voit pas. La gouvernance n’est pas une feuille Excel à part : c’est le même modèle que Slack.

Pour les développeurs, l’approche change : le pont n’est plus un connecteur générique mais un agent contextuel. Avec RTS + MCP, un LLM découvre ce qu’il peut faire et demande précisément le contexte dont il a besoin. L’agence devient plus précise, fiable et organisée. Et surtout, distribuable : le marketplace résout une des barrières traditionnelles — que les employés utilisent les applications — en les intégrant directement dans leur environnement de travail habituel.

Quelles questions restent ouvertes ? Trois axes :

- Coûts : les appels en temps réel aux données conversationnelles ne sont pas gratuits; il faudra jongler entre latence, coût par requête et valeur.

- Confidentialité : même en respectant les permissions, les organisations voudront des politiques explicites pour les DMs et canaux sensibles.

- Risque de bruit : un agent contextuel peut devenir intrusif s’il intervient trop souvent. L’expérience utilisateur (et la fonction “mute”) seront aussi cruciales que la précision.

Exemple concret : du “recherche dans Drive” au “clôture du dossier #8412”

Imaginez un agent de support client qui, dans #incidences-SaaS, reçoit la question : “Que convenions-nous avec le client Daylight concernant le SLA de support premium ?”. Avec RTS, l’agent cherche dans les fils récents où ont été discutés “Daylight” et “SLA”, extrait le message où un gestionnaire a précisé : “Réponse en 2 heures, 24/7”, et renvoie une réponse citant ce message. Avec MCP, l’agent peut également ouvrir un objet de travail lié au cas dans le CRM et permettre de le clôturer sans quitter le fil. Si des permissions sont nécessaires, elles sont respectées : si l’utilisateur ne peut pas voir certains DMs, l’agent ne les verra pas non plus.

C’est le type de productivité réelle — et de gouvernance — que les entreprises souhaitent atteindre.

Conclusion : du bot “colle-montage” à l’agent avec contexte

Pendant une décennie, Slack a été le colle entre outils. Avec la RTS et le MCP, il veut devenir le tissu nerveux où l’IA non seulement connecte, mais comprend le contexte et agit en respectant les permissions. Si la promesse est tenue — et que les échéances sont respectées — 2026 pourrait devenir l’année où la conversation ne sera plus une boîte noire pour l’IA, mais le carburant qui la rend véritablement utile.

En attendant, la bêta fermée et un écosystème déjà en place (Anthropic, Google, Perplexity, Writer, Dropbox, Notion…) montrent déjà les premiers usages. Le défi n’est pas minime, mais la voie tracée est claire : l’IA avec contexte, au cœur de votre lieu de travail.

Questions fréquentes

Qu’est-ce que l’API RTS de Slack et en quoi diffère-t-elle d’une exportation de données ?

La RTS permet à une application ou un agent de questionner messages, fichiers et canaux en temps réel, uniquement ce qui est pertinent et en respectant les permissions. Elle n’impliquera pas de télécharger ou de compliquer des conversations en masse, ce qui réduit les risques et facilite la conformité.

À quoi sert le Model Context Protocol (MCP) dans Slack ?

Le MCP est un protocole unifié pour que les LLMs et applications découvrent le contexte et effectuent des tâches dans Slack, sans intégrations ad hoc. Il standardise la façon dont un modèle accède aux données et réalise des actions en respectant les permissions.

Comment Slack garantit-il la confidentialité si des agents peuvent lire des conversations ?

Les appels à la RTS respectent les permissions existantes (canaux publics/privés, DMs), et ne renvoient que des fragments pertinents. Il n’y a pas de téléchargement massif ni de copie» de données hors de Slack, et les administrateurs conservent un contrôle granulaire.

Quand ces fonctionnalités seront-elles accessibles à tous ?

La RTS API et le MCP sont en bêta fermée et devraient être disponibles en déploiement général début 2026. Work Objects sera en GA à la fin octobre, et les outils pour développeurs sont déjà opérationnels.

Source : salesforce