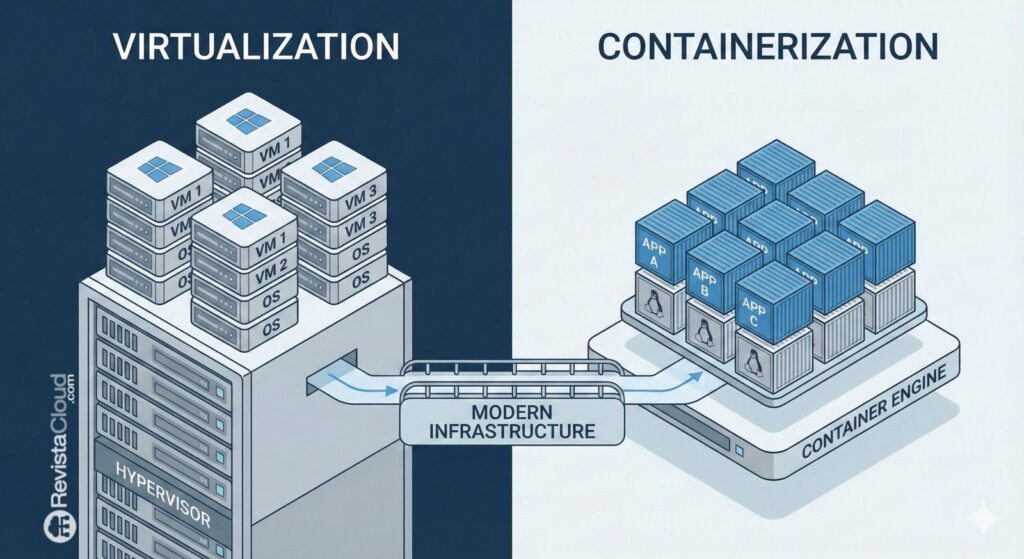

La virtualisation, longtemps considérée comme la « base solide » sur laquelle s’appuyaient les centres de données et les clouds privés, connaît aujourd’hui une phase de réévaluation profonde. Il ne s’agit pas simplement de remplacer un hyperviseur par un autre, mais de repenser complètement le modèle opérationnel : où résident les charges, comment elles sont gérées, comment elles sont protégées et, surtout, comment se préparer à une nouvelle ère marquée par l’intelligence artificielle, la pression sur la performance et l’im prévisibilité des coûts.

C’est la thèse centrale d’une nouvelle étude publiée par HPE : plus de deux tiers des entreprises prévoient des changements importants dans leur stratégie de virtualisation dans les deux prochaines années, mais seulement 5% estiment être pleinement préparées à les mettre en œuvre. Ce constat illustre un marché en pleine mutation, tout en révélant un déficit d’exécution qui inquiète les responsables IT et leurs équipes : l’intention de transformer est présente, mais elle n’est pas toujours accompagnée de plans, de ressources et de capacités suffisants.

Du plan à l’action : 12 à 24 mois décisifs

HPE considère que les 12 à 24 prochains mois constituent un tournant essentiel : le passage de la « planification » à la « transformation active ». L’enquête — menée auprès de près de 400 organisations à l’échelle mondiale — dresse le portrait d’un environnement où la virtualisation n’est plus une décision statique, mais un composant devant évoluer en fonction du rythme des affaires et de l’adoption de l’intelligence artificielle.

Dans cette « grande réinitialisation », le rapport met en lumière une idée qui bouleverse la vision simpliste véhiculée ces derniers trimestres : le coût des licences ne serait pas le seul moteur d’évolution. En réalité, seulement 4% des entreprises interrogées citent cela comme principal catalyseur. La mise en avant la plus forte proviendrait de la préparation pour l’IA, de la nécessité d’une flexibilité hybride et de l’équilibre entre performance, opération et sécurité dans des environnements de plus en plus complexes.

Les obstacles : contraintes budgétaires, complexité et risques de migration

La transformation, aussi séduisante soit-elle en présentation, devient plus difficile lorsqu’il faut déplacer des charges critiques. HPE identifie les principaux freins : restrictions budgétaires (28%), complexité technique (24%) et risque lié à la migration (21%), suivis de près par la lacune en compétences (20%).

Le message est clair : beaucoup d’organisations savent qu’elles doivent évoluer, mais craignent le coût réel — non seulement économique, mais aussi opérationnel — et les risques d’interruption. La virtualisation demeure le « cœur » de nombreux services, ce qui oblige à aborder sa modernisation avec prudence et préparation.

Ce n’est pas un simple échange d’hyperviseur : c’est une refonte du modèle opérationnel

Un autre chiffre clé montre l’orientation : 57% des entreprises envisagent une stratégie par étapes pour « sécuriser » leur infrastructure pour l’avenir. Dans ce processus, le modèle hybride apparaît comme la voie privilégiée, notamment pour répondre aux exigences de performance liées à l’IA.

L’étude fournit également une cartographie des approvisionnements selon différents environnements (non exclusifs) : 78% en cloud public, 61% en clusters virtualisés, 48% en cloud privé et 32% en edge. La conclusion est claire : le « lieu » d’hébergement est important, mais la manière dont on opère est encore plus cruciale lorsque les charges sont distribuées entre plusieurs domaines.

La sécurité, l’observabilité et la gouvernance des données en tête du classement

Si l’hyperviseur n’est plus le seul acteur principal, quelles nouvelles priorités émergent ? HPE souligne trois piliers indispensables dans la stratégie moderne de virtualisation :

- Sauvegarde unifiée et cyber-récupération (70%)

- Gouvernance multiplateforme (61%)

- Observabilité intégrée et AIOps (55%)

Autrement dit : la conversation évolue vers la résilience, la visibilité et le contrôle transversal. Cela répond à la pression croissante de l’IA : plus de données, davantage de services, une dépendance accrue et des coûts supérieurs en cas de défaillance.

Brian Gruttadauria, CTO Cloud Hybride chez HPE, résume cette tension en déclarant que les entreprises « réévaluent leurs fondamentaux IT » pour équilibrer anticipation des coûts, préparation à l’IA et performance. Il ajoute que ce n’est pas une substitution rapide, mais plutôt une évolution vers un modèle plus flexible et simplifié.

Danfoss, Morpheus et le discours sur la « stabilité pour l’ère de l’IA »

Le communiqué d’HPE intègre également des témoignages clients et partenaires. Danfoss, par exemple, voit dans cette transformation une opportunité de préparer ses opérations pour un modèle cloud plus simple et adapté à l’ère de l’IA, dans le cadre de HPE Private Cloud Enterprise avec HPE Morpheus. Bien que ces exemples soient souvent utilisés à des fins de positionnement commercial, ils offrent un contexte concret : le marché ne parle plus seulement de consolidation de machines virtuelles, mais de construction d’une base opérationnelle « stable », où la virtualisation est un moyen, et non une fin en soi.

Le point de vue européen : alternatives ouvertes et fournisseur en pleine expansion avec Proxmox

En parallèle de ces évolutions, le « reset » de la virtualisation ouvre la voie à des solutions open source. Parmi elles, Proxmox VE connaît une adoption croissante parmi les CIOs et responsables d’infrastructures, grâce à sa combinaison de virtualisation, gestion centralisée et approche communautaire/entreprise.

En Europe, des fournisseurs comme Stackscale (groupe Aire) capitalisent sur cette tendance : en promouvant la migration vers Proxmox VE comme levier pour gagner en flexibilité et réduire la dépendance à un seul fournisseur. Ils offrent également un accompagnement pour les migrations et déploiements sur infrastructures bare-metal, spécifiquement orientés vers Proxmox.

Cela rejoint la conviction centrale de l’étude HPE : le marché ne cherche pas simplement un « hyperviseur supplémentaire », mais une nouvelle façon de reprendre le contrôle — sur les coûts, l’opération et la résilience — tout en restant innovant. Et c’est précisément dans ces capacités que les entreprises veulent investir prioritairement : sauvegarde et récupération, gouvernance transversale, observabilité et automatisation.

Un « reset » méthodologique indispensable

La conclusion de cette étude est aussi simple que stratégique : d’ici 2026 et 2027, la virtualisation pourrait connaître un tournant déterminant, mais le succès dépendra moins du choix du produit que de la démarche adoptée. Inventorier les dépendances, évaluer les risques, former les équipes, planifier par étapes, renforcer la cyber-récupération et bâtir une observabilité efficace — autant de décisions plus importantes que le simple logo de l’hyperviseur.

Car si seule l’interface logicielle évolue, sans changer le modèle opérationnel, la réinitialisation reste incomplète.

Questions fréquemment posées

Qu’est-ce que le « Great Virtualization Reset » et pourquoi concerne-t-il autant d’entreprises à partir de 2026 ?

Il s’agit du processus par lequel les organisations reviennent sur leur stratégie de virtualisation pour s’adapter aux changements de licences, à la pression sur les coûts et, surtout, aux nouvelles exigences en matière de performance et d’opérations liées à l’IA et aux modèles hybrides.

Quels sont les principaux risques lors de la migration de machines virtuelles vers une autre plateforme de virtualisation ?

Les principaux risques concernent les interruptions de service, la compatibilité réseau et stockage, les dépendances vis-à-vis des outils de sauvegarde/monitoring et le manque de compétences internes. C’est pourquoi beaucoup privilégient des migrations par étapes ou des environnements pilotes.

Quelles capacités une entreprise doit-elle prioriser lors de la modernisation de sa virtualisation pour l’IA ?

Au-delà de l’hyperviseur, la cyber-récupération, la sauvegarde unifiée, la gouvernance multi-plateforme et l’observabilité avec automatisation/AIOps sont essentielles pour gérer des charges réparties avec contrôle et résilience.

Pourquoi Proxmox apparaît-il comme une alternative dans le « reset » de la virtualisation ?

Parce qu’il propose une approche ouverte et flexible adaptée aux stratégies hybrides, et gagne en popularité dans des projets européens souhaitant réduire leur dépendance à un fournisseur unique et renforcer leur contrôle opérationnel.