Ces derniers mois, l’attention médiatique s’est concentrée sur les GPU pour l’intelligence artificielle. Chaque nouveau déploiement de clusters d’entraînement se chiffre en milliards d’unités et en mégawatts, et la conversation tourne principalement autour de qui obtiendra le plus de cartes et la capacité de calcul la plus importante.

Mais alors que les gros titres évoquent les GPU, un changement tout aussi profond — mais bien moins visible — se prépare dans d’autres segments de la chaîne : mémoire, stockage et serveurs standards. La prochaine hausse des coûts d’infrastructure ne concernerez pas uniquement ceux qui entraînent des modèles géants, mais aussi ceux qui souhaitent monter un « serveur normal » pour des bases de données, la virtualisation ou des services web.

L’IA bouleverse le marché de la mémoire

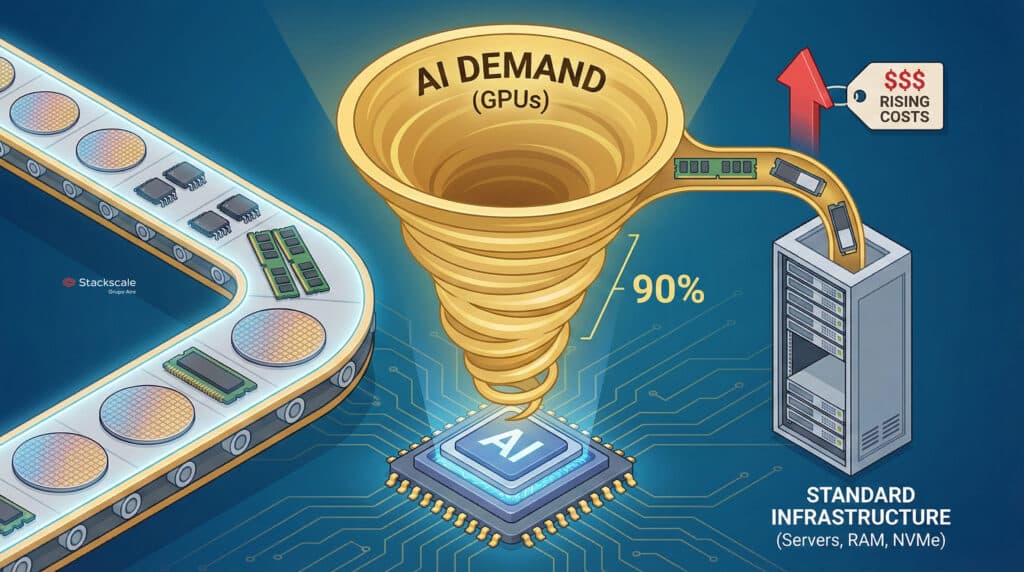

Le point de départ est simple : la demande en IA détourne une part croissante de la capacité mondiale de fabrication de mémoire vers des puces plus rentables, celles intégrées dans les GPU de dernière génération.

Cela signifie que :

- Les fabricants privilégient la mémoire haut de gamme (HBM, GDDR, NAND de haute gamme) pour les grands clusters IA.

- Il y a moins de capacité effective pour produire des modules RAM « classiques » ou des unités NVMe qui alimentent le reste du marché : data centers traditionnels, PME, hébergement, stockage d’entreprise, etc.

Lorsque la production totale n’évolue pas au même rythme que la demande, le résultat est prévisible : les prix augmentent, même pour des produits ne portant pas l’étiquette « IA ».

Ce qui nous attend : des serveurs entre 15 % et 35 % plus chers

Les prévisions internes du secteur indiquent un scénario difficile pour quiconque doit planifier ses achats de matériel :

- Un même serveur, fabriqué en décembre 2026, pourrait coûter entre 15 % et 35 % de plus qu’en décembre 2025.

- Cette pression ne se limite pas au coût du GPU, mais englobe l’ensemble : RAM, NVMe, certains types de CPU et composants associés.

La chaîne d’approvisionnement commence déjà à réagir. De nombreux acteurs — fournisseurs d’infrastructure, hyperscalers, grands intégrateurs — achètent des composants plusieurs mois à l’avance pour se prémunir contre ces hausses.

Ce mouvement défensif, toutefois, a un effet secondaire : il accélère la hausse des prix. Lorsque la moitié du marché tente de sécuriser ses stocks en avance, le phénomène de stockage anticipé, observé lors de la crise des puces en 2020–2021, se répète : plus de tension, d’incertitude et de volatilité.

Du matériel à la cloud : la facture en hausse aussi dans le cloud

Dans l’univers du cloud, cette pression sur les coûts matériels finit tôt ou tard par se répercuter sur les catalogues publics.

Avec les conditions actuelles, certains fournisseurs évoquent :

- Une augmentation moyenne de 5 à 10 % sur certains services entre avril et septembre 2026, si les dynamiques de marché ne changent pas.

Ce ne sera pas un choc brusque, mais une série d’ajustements : nouvelles générations d’instances légèrement plus coûteuses, révision des prix pour le stockage haute performance, réévaluation des tarifs pour certains blocs de RAM et NVMe.

Celui qui ne regarde que le prix du GPU sera surpris : L’inflation liée à l’IA impactera aussi l’infrastructure « support », depuis les nœuds de bases de données jusqu’aux serveurs de virtualisation généralistes.

L’angle Stackscale : anticiper la tempête, pas seulement en parler

Dans ce contexte, des fournisseurs de cloud privé et bare-metal comme Stackscale (Groupe Aire) ne peuvent se contenter d’observer. Ils doivent redessiner leur stratégie à l’avance.

La société indique qu’elle travaille déjà sur plusieurs axes :

- Optimisation des achats, en anticipant certains commandes tout en évitant la spirale spéculative.

- Ajustements fins des configurations, visant des serveurs offrant un meilleur rapport performance/prix et une meilleure efficacité énergétique.

- Augmentation de la densité et de l’utilisation pour maximiser chaque nœud physique et rentabiliser au mieux la mémoire et le stockage investis.

L’objectif est clair : absorber une partie de l’impact sans le répercuter immédiatement sur le client final.

Selon le cofondateur David Carrero :

« Aussi souvent que possible, nous allons chercher à maintenir stables les prix de la nouvelle infrastructure, en proposant des environnements haute performance et, surtout, une certaine prévisibilité à long terme. Nous savons que de nombreuses entreprises dépendent d’un cadre tarifaire stable pour planifier leurs investissements IT, notamment dans les projets critiques et liés à l’IA. »

En résumé : la bataille ne se limite pas à la technologie, elle concerne également la gestion économique.

Ce que peuvent faire les entreprises : de la réaction à la stratégie

Pour les organisations dépendant de l’infrastructure — que ce soit dans le cloud public, privé ou dans des modèles hybrides — la conclusion est claire mais douloureuse : il faut se préparer dès maintenant, et ne pas attendre la prochaine hausse des coûts.

Voici quelques pistes d’action raisonnables :

- Réviser l’inventaire des charges de travail

- Identifier quels projets nécessitent réellement des GPUs et lesquels peuvent continuer avec des CPU et du stockage standard.

- Éviter de « payer la taxe IA » sur des services qui ne l’exigent pas.

- Planifier à 2-3 ans

- Ne pas aborder l’infrastructure comme une série d’achats ponctuels, mais comme une stratégie de capacité.

- Anticiper renouvellements, consolidations et expansions avant que les prix ne deviennent prohibitifs.

- Négocier des modèles de tarification prévisibles

- Privilégier les fournisseurs offrant des cadres tarifaires stables ou des grilles tarifaires claires à moyen terme, plutôt que des tarifs opaques sujets à changement constant.

- Valoriser les solutions de cloud privé et de bare-metal lorsque la consommation est stable ou prévisible ; dans de nombreux cas, le CAPEX bien planifié permet d’amortir une inflation prolongée.

- Optimiser l’efficacité avant d’acheter davantage de matériel

- Revoir la configuration des machines virtuelles, éliminer le surprovisionnement et optimiser le stockage.

- Investir dans l’observabilité et la gestion financière (FinOps) : on ne peut optimiser ce que l’on ne mesure pas.

L’IA se fait aussi sentir là où on ne l’attend pas

La narration dominante présente l’IA comme une succession de grands modèles, de lancements spectaculaires et de records de performance sur GPU. Mais son impact réel est bien plus discret et transversal.

Dans les mois qui viennent, la pression sur la chaîne d’approvisionnement en mémoire et stockage montrera que la révolution IA ne se limite pas aux grands clusters d’entraînement, mais touche aussi les composants apparemment plus courants : modules RAM, unités NVMe, serveurs généralistes.

Pour l’écosystème technologique — fournisseurs, intégrateurs, entreprises clientes — le message est clair :

- Il ne suffit pas de parler IA, il faut faire des calculs d’infrastructure.

- Il ne suffit pas de courir après la dernière GPU, il faut aussi veiller à ce que le reste du matériel ne devienne pas une surcharge financière.

- Et il ne suffit pas de réagir aux hausses, il faut aussi choisir ses partenaires avec soin et leur demander plus que de la simple capacité de calcul.

Ce que la dernière décennie a montré, c’est que la technologie avance à toute vitesse, mais que les budgets, eux, ne suivent pas. La différence à venir sera faite par ceux qui comprendront que la prochaine vague majeure de coûts ne viendra pas seulement sous forme de cartes de 700W noires, mais aussi dans cette « peinture et carrosserie » habituelle qui, jusqu’ici, semblait peu chère et abondante.

Ceux qui se préparent dès aujourd’hui, avec une stratégie d’infrastructure solide et des partenaires alignés, auront moins de surprises demain… et plus de marge pour investir dans ce qui compte vraiment : créer des produits et services exploitant l’IA, plutôt que de payer la facture de ses externalités.