Ce lundi matin 20 octobre, une secousse majeure a secoué la moitié d’Internet : Amazon Web Services (AWS) connaît une panne majeure qui perturbe le fonctionnement de nombreux services tels que Amazon, Alexa, Snapchat, Fortnite, Epic Games Store et Epic Online Services, ChatGPT, Prime Video, Perplexity, Airtable, Canva, Duolingo, Zoom, l’application de McDonald’s, Roblox et Clash Royale, entre autres. Le tableau de bord d’état d’AWS signale une “augmentation des erreurs et des latences” en US-EAST-1 (Virginie du Nord) — la région la plus utilisée du fournisseur — et indique qu’il œuvre activement pour atténuer l’incident et en déterminer la cause profonde.

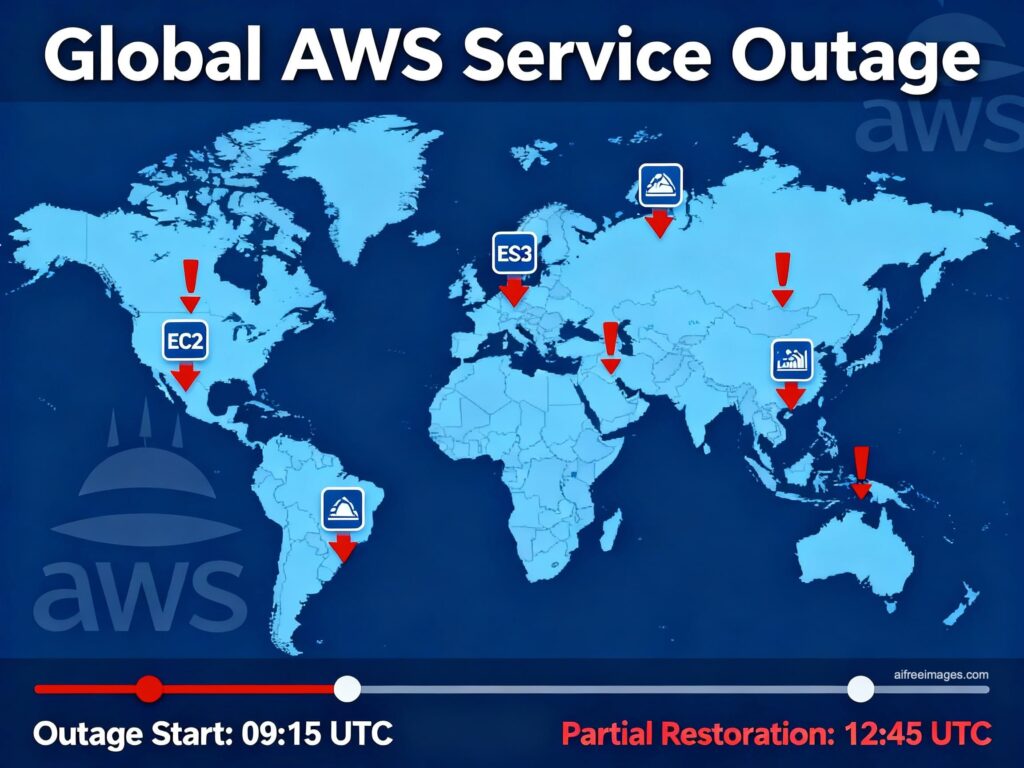

Selon le registre interne de la plateforme cloud d’Amazon, les problèmes ont été détectés à 03h11 ET (09h11 en Espagne péninsulaire), avec un premier rapport technique promettant une mise à jour “dans 45 minutes”. Parallèlement, à partir de 08h40 (heure péninsulaire), les rapports d’indisponibilité ont commencé à affluer sur des sites comme DownDetector, tandis que sur les forums et réseaux sociaux, des milliers d’utilisateurs confirmaient que Alexa ne répondait pas aux requêtes ni n’exécutait ses routines — y compris les alarmes préconfigurées — et que des jeux ou applications populaires étaient inaccessibles ou rencontraient des erreurs intermittentes. La portée est globale, bien que l’impact varie selon les régions et la dépendance de chaque service vis-à-vis de l’infrastructure affectée.

“Perplexity est actuellement hors service. La cause profonde provient d’un problème chez AWS. Nous travaillons à sa résolution”, a reconnu Aravind Srinivas, le directeur général de Perplexity, sur X.

Quels sont les dysfonctionnements et pourquoi cela se ressent-il autant ?

AWS décrit cet incident comme une augmentation des erreurs et des latences affectant plusieurs services en US-EAST-1. Bien qu’il ne concerne “qu” une région, sa poids disproportionné dans l’écosystème cloud d’Amazon explique l’effet domino : de nombreuses entreprises hébergent leurs charges dans la région de Virginie du Nord pour des raisons historiques, économiques, de latence ou de disponibilité des services ; en outre, certains plans de contrôle et dépendances internes (authentification, files d’attente, DNS internes, orchestration) utilisent des composants multi-clients qui, en dégradant, propagent le problème vers d’autres régions. C’est pourquoi aujourd’hui, même les services en Europe ressentent l’impact, avec échecs de connexion, charges partielles ou picos de latence.

Concrètement, les utilisateurs constatent souvent quatre symptômes :

- Pages qui ne chargent pas ou renvoient des codes 5xx.

- APIs qui répondent de façon erratique ou expirent.

- Impossible de télécharger ou uploader du contenu (images, pièces jointes).

- Les services “intelligents” — assistants vocaux, recommandations, automatisations — sont en silence.

Parmi les plateformes touchées figurent des géants du divertissement et de la communication — Fortnite, Snapchat —, les assistants vocaux — Alexa —, des applications professionnelles (Airtable, Canva), des services d’IA (ChatGPT, Perplexity) et des applications grand public (Prime Video, McDonald’s). La popularité d’AWS, utilisé par Netflix, Spotify, Reddit ou Airbnb — entre autres — Amplifie la portée de chaque panne.

Chronologie connue de l’incident

- 03h11 ET (09h11 en Espagne). Le tableau de bord d’AWS signale un incident en US-EAST-1 avec des erreurs et des latences élevées.

- 03h51 ET. Amazon publie une mise à jour : “Nous travaillons à atténuer le problème et comprendre sa cause profonde. Une mise à jour sera fournie dans 45 minutes ou plus tôt si de nouvelles informations émergent.”

- 08h40 (heure péninsulaire). Des utilisateurs en Espagne et ailleurs en Europe commencent à constater des pannes de connectivité et des dysfonctionnements dans les services dépendant d’AWS.

- Midi (Europe). Les perturbations persistent avec des comportements intermittents selon le service et la région. La cause reste officiellement non confirmée et aucun ETA pour la reprise totale n’est encore prévu.

Pas une première : le précédent de US-EAST-1

La région US-EAST-1 a été le théâtre de plusieurs incidents marquants ces dernières années. En 2020, 2021 et 2023, des défaillances ont causé des perturbations généralisées durant plusieurs heures. Ce patron — une affectation à Virginie du Nord avec des effets visibles à l’échelle mondiale — a conduit de nombreux ingénieurs à repenser leur architecture pour éviter de concentrer plans de contrôle et données critiques en un seul point de défaillance.

Impacts en Espagne et en Europe

Ce matin, la situation présente une carte inégale : certains services fonctionnent normalement, d’autres échouent lors de la connexion ou du téléchargement, et certains ne chargent tout simplement pas. L’impact varie au fil des minutes, en fonction de la gestion par AWS de ses composants internes ou de la redistribution de la charge. La configuration des plateformes, notamment si une société est multirégionale, modifie aussi la résilience de leur expérience utilisateur.

Ce que disent les entreprises concernées

En plus du message officiel d’AWS, plusieurs équipes ont reconnu publiquement leur dépendance au fournisseur. Perplexity a été très explicite sur X. Des études de jeux, des plateformes de design ou des applications de productivité ont publié des notifications sur leurs pages de statut ou réseaux sociaux, en désactivant certaines fonctionnalités en attendant la normalisation.

Le cas d’Alexa est exemplaire : étant un service cloud-first, la panne d’AWS a rendu inopérantes des opérations quotidiennnes comme l’allumage des lumières, le lancement de routines ou la consultation du temps. Sur un plan plus professionnel, des organisations utilisant des SaaS sur Amazon ont signalé des lenteurs, des erreurs intermittentes ou des échecs d’authentification.

Pourquoi “Internet tombe en panne” quand une hyperéchelle vacille

La cloud computing permet de louper des ressources (calcul, stockage, bases de données, messageries) plutôt que de les acquérir. Cette économie d’échelle, grande promesse du cloud, entraîne une concentration : si trop de services dépendent d’un même plan (par exemple, US-EAST-1 et ses composants communs), un incident peut se propager. L’usage des meilleures pratiques recommande une architecture en multi-AZ (zones de disponibilité multiples), multi-régionale ou même multi-cloud lorsque la criticité le justifie. Toutefois, toutes les plateformes ne mettent pas systématiquement en pratique cette stratégie, en raison de coûts, de complexité ou de legacy.

Actions à prendre pour utilisateurs et entreprises

Utilisateurs finaux

- Consulter régulièrement le tableau de bord d’état du service utilisé ainsi que celui d’AWS.

- Éviter de réinstaller des applications ou d’effacer des données si le problème provient du fournisseur.

- Recommencer l’opération plus tard : l’intermittence pourrait diminuer à mesure que la mitigation progresse.

Équipes IT

- Ne pas effectuer de changements urgents de configuration durant l’incident sauf si une solution de mitigation claire est en place (ex : basculement vers une autre région déjà prête).

- Si l’architecture le permet, migration du trafic vers des régions saines (mode actif-actif ou actif-passif).

- Communiquer avec les clients et collaborateurs sur l’état du service et les délais estimés ; prévoir des files d’attente pour réessayer une fois la situation stabilisée.

- Réviser après la normalisation : quelles dépendances critiques étaient en monorégion ? Quelles alarmes se sont déclenchées ? Quel SLA/SLO a été violé ?

Ce que l’on sait (et ce que l’on ignore)

- Confirmé : US-EAST-1 subit des erreurs et de fortes latences dans plusieurs services AWS ; l’impact est mondial mais à des degrés divers.

- Signalé : des plateformes comme Alexa, Fortnite, Snapchat, Prime Video, Perplexity, Airtable, Canva, Duolingo, Zoom, Roblox, Clash Royale, ChatGPT et Epic ont été affectées en tout ou partie.

- Non confirmé : la cause exacte de l’incident ni le délai pour une restauration complète (AWS poursuit ses investigations).

Les leçons potentielles à tirer de cette panne

- US-EAST-1 ne peut pas tout contenir. Centraliser contrôle et données dans cette région peut s’avérer pratique mais comporte un risque majeur.

- Multi-AZ n’est pas suffisant. Lorsqu’un composant transversal échoue, la présence de plusieurs Zones de disponibilité dans une seule région ne garantit pas l’absence d’interruption.

- Multi-région et “chaos-gamedays”. Testez régulièrement les processus de failover et de dégradation contrôlée, en condition réelle ou simulée, autant que la rédaction du runbook.

- Transparence. La communication précoce et les mises à jour régulières sont essentielles pour réduire l’incertitude des clients et usagers.

Foire aux questions (FAQ)

Qu’est-ce exactement que US-EAST-1 et pourquoi sa panne impacte autant de services ?

US-EAST-1 est la région AWS en Virginie du Nord, l’une des plus utilisées pour des raisons historiques, économiques ou de catalogue de services. De nombreuses plateformes y hébergent une partie du plan de contrôle ou des charges essentielles. Un incident dans cette région peut donc se propager au-delà de ses limites et affecter d’autres services ailleurs.

Quels services ont été affectés aujourd’hui par la panne AWS ?

En tout ou en partie : Amazon, Alexa, Prime Video, Snapchat, Fortnite, Epic Games Store/Epic Online Services, ChatGPT, Perplexity, Airtable, Canva, Duolingo, Zoom, Roblox, Clash Royale. L’impact varie en fonction de la région et du degré de dépendance de chaque plateforme à US-EAST-1.

Quelle est la durée potentielle d’une panne AWS, et quoi faire en attendant ?

Cela dépend des causes et de l’étendue. Des précédents en 2020, 2021 et 2023 montrent que cela peut durer plusieurs heures. Pendant ce temps, il est conseillé de ne pas faire de modifications risquées, de communiquer avec ses utilisateurs, de basculer vers d’autres régions si possible et de documenter les incidents pour le bilan.

Comment limiter l’impact des futures pannes AWS ou autres hyperéchelles ?

En adoptant une architecture multi-AZ, multi-régions (réelles), séparant contrôles et données, en utilisant des files de messages idempotentes, en planifiant des tests de basculement (“failover” et “gamedays”) et en envisageant, si nécessaire, une stratégie multi-cloud avec DNS/CDN contrôlés.

Note : cette analyse s’appuie sur des sources publiques, notamment le tableau de bord d’état d’AWS, les déclarations des entreprises concernées et les retours d’utilisateurs en temps réel. La situation peut évoluer et les informations seront mises à jour en conséquence.

via : Downdetector