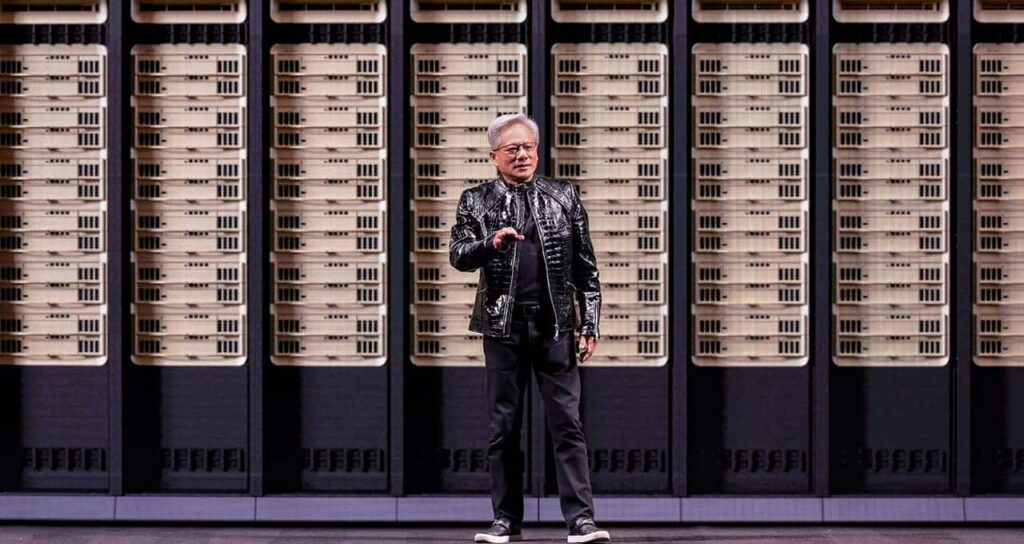

NVIDIA a profité du lancement du CES 2026 à Las Vegas pour présenter quelque chose de plus ambitieux qu’un simple catalogue de produits : une vision de plateforme. Jensen Huang est monté sur scène au Fontainebleau avec un message clair : l’intelligence artificielle n’est plus une simple couche logicielle supplémentaire, mais le moteur qui reconstruit toute la pile informatique, depuis le silicium et le réseau jusqu’au stockage et aux modèles.

Dans ce contexte, la société a déployé trois piliers résumant ses ambitions pour les années à venir : Rubin, sa nouvelle plateforme d’IA « extrême-conçue » ; une stratégie de modèles ouverts par domaines ; et une infrastructure pensée pour une IA intelligente et contextuelle, où le contexte — la « mémoire » opérationnelle — devient une ressource critique.

Rubin : la plateforme à six puces qui vise à réduire le « prix par token »

L’annonce centrale a été NVIDIA Rubin, successeur de Blackwell, présentée comme la première plateforme d’IA à six puces conçue en co-conception extrême. Le concept est simple : lorsque l’IA atteint une « gigascale », il ne suffit plus de fabriquer une GPU plus rapide ; il faut concevoir de manière coordonnée GPU, CPU, interconnexion, réseau, DPUs, stockage et logiciel, car les goulots d’étranglement évoluent.

Rubin se décrit comme une plateforme « construite du centre de données vers l’extérieur » et, dans sa composition, NVIDIA mentionne :

- Rubin GPUs avec 50 pétaflops en inférence via NVFP4.

- Vera CPUs, orientées flux de données et traitement pour les systèmes intelligents.

- NVLink 6 pour une montée en échelle « scale-up ».

- Spectrum-X Ethernet Photonics pour une montée en puissance « scale-out ».

- ConnectX-9 SuperNICs et BlueField-4 DPUs comme socle pour la connectivité et l’accélération infrastructurelle.

Huang a déclaré que l’objectif est de réduire drastiquement le coût du déploiement de l’IA à grande échelle : cette plateforme promet de fournir des tokens à environ un dixième du coût de la génération précédente, orientant l’économie de l’IA vers un domaine plus « industriel » que purement expérimental.

Le nouveau défi du contexte : le cache KV et la mémoire opérationnelle

Selon NVIDIA, en 2026, l’IA va dépasser le simple chatbot de « réponse unique » pour adopter des systèmes capables de maintenir des conversations longues, d’enchaîner des tâches, de consulter des outils, et de conserver un historique — ce qu’on appelle aujourd’hui une IA agentielle.

Un goulot d’étranglement apparaît : la mémoire de contexte KV cache, cette mémoire qui permet aux modèles de raisonner sur plusieurs tours tout en conservant la cohérence.

NVIDIA insiste sur un point : le KV cache ne peut pas rester indéfiniment dans la GPU sans pénaliser la latence en inférence en temps réel. C’est pourquoi, en parallèle de Rubin, la société a présenté un concept de stockage natif pour l’IA : une couche spécifique pour gérer le contexte.

“Stockage natif pour l’IA” : une couche de mémoire de contexte hors GPU

Sous l’égide de BlueField-4, NVIDIA a introduit la Inference Context Memory Storage Platform, une couche de KV cache conçue pour l’inférence longue et les agents à plusieurs tours.

Les chiffres sont ambitieux :

- Jusqu’à 5× plus de tokens par seconde,

- Jusqu’à 5× meilleur rapport coût/performance,

- et jusqu’à 5× meilleure efficacité énergétique par rapport aux solutions de stockage traditionnelles.

Au-delà de ces multiplicateurs, le message stratégique est clair : si les agents nécessitent une mémoire partagée entre nœuds et une persistance du contexte, le stockage ne doit plus être un simple dépôt passif, mais devenir une composante active de la performance.

Modèles ouverts par domaines : Clara, Earth-2, Nemotron, Cosmos, GR00T et Alpamayo

Une autre ligne phare de la conférence est l’insistance de NVIDIA sur un catalogue de modèles ouverts entraînés sur ses propres supercalculateurs, organisés par domaines, afin d’être une base réutilisable par les entreprises et industries.

Les secteurs cités couvrent :

- Clara (santé)

- Earth-2 (climat)

- Nemotron (raisonnement et multimodalité)

- Cosmos (robotique et simulation)

- GR00T (intelligence incarnée)

- Alpamayo (conduite autonome)

La stratégie repose sur la notion que ces modèles évoluent via des cycles plus courts, et que l’écosystème — téléchargements, adaptations, évaluations, « garde-fous » — fait partie intégrante du produit. NVIDIA se positionne comme un « constructeur de frontières » pour ces modèles, mais avec une ouverture permettant à des tiers de les ajuster, évaluer et déployer.

Alpamayo : raisonner pour la longue traîne de la conduite autonome

Dans le domaine automobile, Alpamayo se présente comme une famille de modèles VLA (vision-langage-action) avec raisonnement, destinés à relever le principal défi de la conduite autonome : la long tail, ces scénarios rares et complexes qui ne se retrouvent pas fréquemment dans les données d’entraînement.

Parmi les annonces, NVIDIA a mis en avant :

- Alpamayo R1, le premier modèle VLA de raisonnement « ouvert » pour la conduite autonome.

- AlpaSim, un modèle de simulation ouverte pour tester ces systèmes en conditions réalistes de haute fidélité.

Huang a lié cette avancée à une application concrète dans l’automobile grand public : le premier véhicule de série équipé d’Alpamayo sur la plateforme NVIDIA DRIVE sera bientôt sur la route, dans le Nouveau Mercedes-Benz CLA, avec une conduite dictée par l’IA, en commercialisation aux États-Unis cette année, et bénéficiant d’une récente note maximale de cinq étoiles par EuroNCAP.

L’IA « personnalisée » : DGX Spark, agents locaux et robots de bureau

Une autre composante du discours vise à recentrer l’IA sur le local et le personnel, en s’éloignant du seul imaginaire de datacenter. Huang a présenté des démonstrations d’agents exécutés sur DGX Spark, incarnés par un robot (Reachy Mini) et utilisant des modèles de Hugging Face.

NVIDIA indique que DGX Spark offre jusqu’à 2,6× plus de performance pour les grands modèles, avec support pour LTX-2 et FLUX en génération d’images, et sera bientôt compatible avec NVIDIA AI Enterprise.

Jeux vidéo et création : DLSS 4.5 et l’écosystème RTX comme vitrine

Bien que le CES soit également une plateforme pour le divertissement, NVIDIA n’a pas omis de présenter ses avancées dans le jeu et la création. La société a dévoilé DLSS 4.5, avec Génération de Fragments Multi-Dynamique, un nouveau mode 6X Multi Frame Generation et un transformer de deuxième génération pour la super résolution DLSS.

Plus de 250 jeux et applications supportent déjà DLSS 4, avec plusieurs titres en ligne dès leur lancement (notamment 007 First Light, Phantom Blade Zero, PRAGMATA ou Resident Evil Requiem). NVIDIA a également évoqué RTX Remix Logic, des démonstrations avec NVIDIA ACE, et de nouveaux déploiements de GeForce NOW sur davantage d’appareils.

Questions fréquentes (FAQ)

Que signifie que Rubin soit une plateforme « extrême-conçue » à six puces ?

Cela signifie que NVIDIA conçoit comme un ensemble coordonné GPU, CPU, réseau, DPU et interconnexion afin de réduire les goulots d’étranglement à l’échelle du rack et diminuer le coût total de formation et d’inférence.

Pourquoi le cache KV est-il devenu un enjeu infrastructurel ?

Parce que les agents et les contextes longs génèrent de grands volumes de mémoire d’état. Le garder indéfiniment dans la GPU limite la latence en inférence en temps réel et augmente les coûts, en particulier dans les systèmes multi-tours et multi-agents.

Que cherche à résoudre le stockage natif pour l’IA de NVIDIA ?

Créer une couche spécifique pour stocker et partager le contexte (cache KV) hors GPU avec une grande vitesse, afin d’augmenter les tokens par seconde et améliorer l’efficacité énergétique lors de l’inférence à grande échelle.

Qu’est-ce qu’Alpamayo et pourquoi est-ce crucial pour la conduite autonome ?

C’est une famille de modèles et d’outils (incluant simulation et datasets) centrée sur le raisonnement dans des scénarios rares (« longue traîne »), le grand défi pour faire évoluer la conduite autonome en toute sécurité.

Source : Nvidia