NVIDIA, la société qui a impulsé comme aucune autre la fièvre actuelle autour de l’intelligence artificielle, se trouve désormais dans une situation inédite : devoir louer ses propres GPU. Selon les informations rapportées par The Information, la société dirigée par Jensen Huang aurait conclu un contrat important avec la startup cloud Lambda, spécialisée dans la fourniture de services de calcul pour l’IA, pour louer une partie des serveurs graphiques que Lambda a lui-même achetés précédemment à NVIDIA.

Ce partenariat témoigne non seulement de la pénurie mondiale de puces haute performance, mais aussi du nouvel équilibre de pouvoir qui se dessine dans l’économie de l’IA.

Un contrat de 18 000 GPU en deux phases

Selon les sources, l’accord se divise en deux étapes :

- 10 000 GPU en leasing pour quatre ans, d’une valeur estimée à 1,3 milliard de dollars.

- Un second lot de 8 000 GPU supplémentaires, probablement de générations antérieures ou de gamme plus modérée, évalué à environ 200 millions de dollars.

Au total, l’opération représenterait une valeur de 1,5 milliard de dollars, faisant de NVIDIA le client le plus important de Lambda à ce jour.

Qui est Lambda ?

Fondée en 2012, Lambda s’est imposée comme une startup spécialisée dans le matériel et les services de calcul pour l’intelligence artificielle. Son activité principale consiste à louer des capacités de serveurs GPU à des entreprises souhaitant entraîner et déployer des modèles d’IA. Parmi ses clients figurent des géants tels que Microsoft, Amazon et Google, ainsi que des acteurs clés du secteur comme OpenAI, Anthropic ou xAI (la société d’Elon Musk).

NVIDIA, en plus d’être fournisseur de matériel, est également investisseur dans Lambda, ce qui renforce leurs liens stratégiques dans un contexte de forte demande et de pénurie de GPU.

NVIDIA devient… son propre client

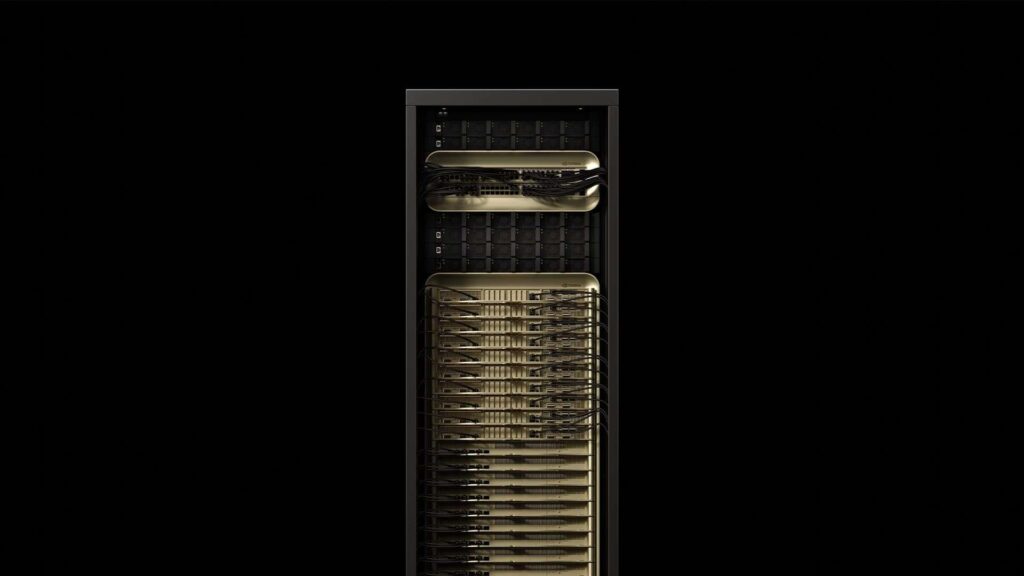

Ce qui intrigue particulièrement, c’est que NVIDIA, qui conçoit les puces GPU les plus cotées au monde (comme les H100 et A100), a choisi de louer sa capacité de calcul via un tiers détenant déjà son matériel.

Ces serveurs loués ne seront pas accessibles au marché grand public, mais principalement destinés à l’usage interne des chercheurs de NVIDIA. Le modèle est similaire à celui d’Amazon ou Microsoft, qui utilisent aussi Lambda à des fins internes.

Ce cas rappelle celui de CoreWeave, une autre startup cloud soutenue par NVIDIA, qui a signé des arrangements équivalents, allant jusqu’à utiliser sa réserve de GPU H100 comme garantie pour un prêt de 2,3 milliards de dollars en 2023.

Contexte : la pénurie de puces et la course à l’IA

La décision de NVIDIA de louer son propre matériel via Lambda illustre la pression énorme exercée sur le marché du calcul pour l’IA.

- Les grands fournisseurs de services cloud (AWS, Azure, Google Cloud) monopolisent une bonne partie de la production de GPU de dernière génération.

- Des startups comme CoreWeave et Lambda ont su tirer profit de leur capacité à sécuriser des lots de puces dès les phases initiales, souvent grâce à un soutien direct de NVIDIA.

- Par ailleurs, la demande pour entraîner des modèles IA (de chatbots à la vision par ordinateur et la génération d’images) ne cesse de croître exponentiellement, obligeant même le plus gros fabricant de GPU à recourir à des accords de leasing pour répondre à ses besoins internes.

Une étape vers l’introduction en bourse de Lambda

Un autre aspect clé de cet accord est qu’il intervient à un moment crucial pour Lambda, qui se prépare à une IPO dans les prochains mois. Le contrat avec NVIDIA renforce sa crédibilité auprès des investisseurs, en lui assurant un client de premier plan et une source de revenus à long terme.

Dans un marché où la crédibilité est surtout mesurée par l’installation capable de fournir et ses clients de référence, Lambda bénéficie ainsi d’un soutien stratégique susceptible d’accroître sa valorisation sur les marchés financiers.

Conclusion

L’accord entre NVIDIA et Lambda illustre une paradoxale réalité de l’ère de l’intelligence artificielle : même le leader mondial du GPU ne possède pas en interne toute la capacité nécessaire pour ses propres besoins.

Il met également en lumière le rôle croissant des startups cloud comme Lambda et CoreWeave, qui, avec le soutien de NVIDIA, façonnent désormais un écosystème où l’infrastructure devient une véritable arme compétitive.

Dans ce contexte, le contrôle de l’accès aux GPU de dernière génération, en termes de disponibilité et de conditions, sera déterminant pour définir les gagnants et les perdants de la course mondiale à l’IA.

Questions fréquentes (FAQ)

1. Pourquoi NVIDIA loue-t-elle ses GPU plutôt que de les produire pour elle-même ?

Parce que la demande dépasse largement sa capacité de production. En louant ses GPU à Lambda, NVIDIA peut combler ses besoins immédiats de recherche sans attendre de nouvelles productions de puces.

2. Qu’est-ce qui différencie Lambda des autres fournisseurs cloud comme AWS ou Google Cloud ?

Lambda se concentre sur une infrastructure optimisée pour l’IA, avec des prix et des configurations plus souples. Elle bénéficie aussi d’accords exclusifs avec NVIDIA, renforçant son attractivité.

3. Quel impact cet accord a-t-il sur le secteur ?

Il consolide Lambda comme un acteur clé dans le cloud IA, tout en témoignant du phénomène de startups soutenues par NVIDIA qui deviennent des intermédiaires stratégiques pour l’accès aux GPU.

4. Quelles conséquences pour les chercheurs et entreprises ayant besoin de GPU ?

L’accès restera probablement limité et coûteux à court terme, avec une dépendance accrue aux intermédiaires ayant sécurisé l’inventaire NVIDIA.

via : tomshardware et the information