L’inférence est devient le nouveau champ de bataille de l’intelligence artificielle. Les modèles actuels ne se contentent plus d’être de simples générateurs de texte ou d’images : ils évoluent vers des systèmes agéntiques capables de raisonner sur plusieurs étapes, de maintenir une mémoire persistante et de gérer des contextes de plusieurs millions de tokens. Pour répondre à ce défi, NVIDIA a présenté Rubin CPX, un GPU conçu spécifiquement pour accélérer les charges de travail à contexte massif avec des performances et une efficacité accrues.

Le défi de l’inférence à grande échelle

Alors que l’IA s’intègre dans davantage de secteurs, les exigences évoluent. Dans le développement logiciel, par exemple, les copilotes de programmation doivent analyser des référentiels entiers, les dépendances entre fichiers et la structure des projets. En vidéo, la génération de contenus longs nécessite une cohérence soutenue sur des heures de métrage, ce qui peut représenter plus de un million de tokens par contexte.

Ces charges dépassent les limites des infrastructures traditionnelles, conçues initialement pour des contextes relativement courts. Le problème n’est pas seulement computationnel : il affecte aussi la mémoire, la bande passante réseau et l’efficacité énergétique, obligeant à repenser la manière de faire évoluer l’inférence.

Inférence disaggregée : diviser pour optimiser

NVIDIA propose une architecture d’inférence disjointe, où le traitement se divise en deux phases distinctes :

- Phase de contexte : intensive en calcul. Le système doit ingérer et analyser de grands volumes de données pour préparer la première sortie.

- Phase de génération : intensive en mémoire. Elle requiert des transferts rapides et une interconnexion efficace pour produire des résultats token par token.

La séparation de ces phases permet d’optimiser les ressources de manière spécifique, en consacrant plus de puissance à l’ingestion initiale et plus de bande passante à la génération continue. Cependant, elle introduit aussi de nouvelles complexités : gestion des caches clé-valeur (KV cache), routage sensible au modèle et gestion avancée de la mémoire.

C’est là qu’intervient NVIDIA Dynamo, la plateforme d’orchestration qui synchronise ces processus et qui a été essentielle dans les récents records de MLPerf Inference.

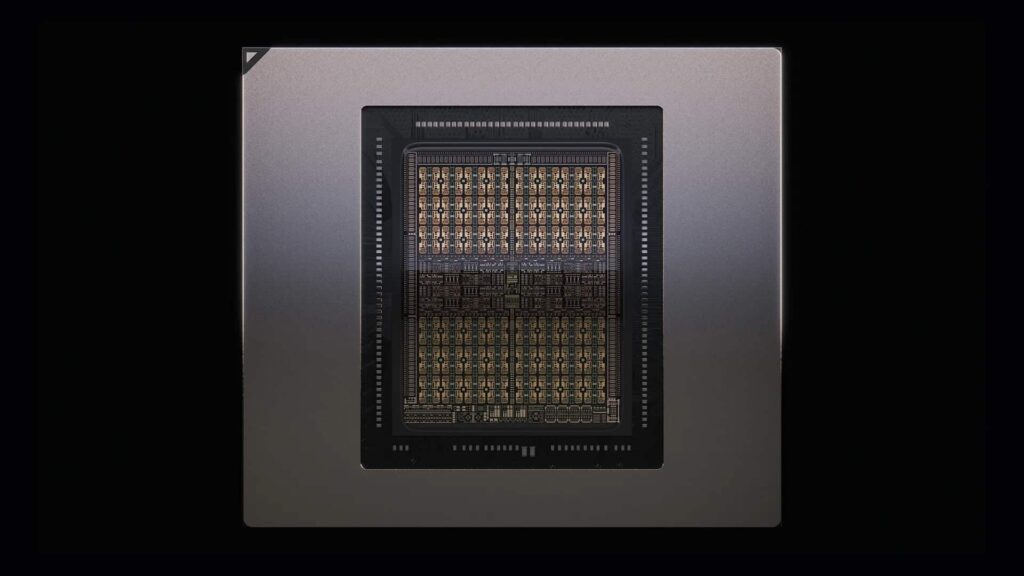

Rubin CPX : accélérer le contexte massif

Rubin CPX constitue la réponse au goulet d’étranglement de la phase de contexte. Conçue avec l’architecture Rubin, cette GPU offre :

- 30 petaFLOPS de calcul en NVFP4.

- 128 Go de mémoire GDDR7 haute efficacité.

- Une accélération 3 fois supérieure des mécanismes d’attention par rapport à la série GB300 NVL72.

- Support natif pour la décodification et la codification vidéo haute résolution.

Grâce à ces caractéristiques, Rubin CPX se positionne comme la pièce maîtresse pour des applications à forte valeur ajoutée, du développement logiciel IA à la génération vidéo HD, en passant par la recherche à grande échelle.

Vera Rubin NVL144 CPX : puissance à l’échelle exaFLOP

La nouvelle GPU ne vient pas seule. Elle fait partie de la plateforme NVIDIA Vera Rubin NVL144 CPX, un rack intégrant :

- 144 GPUs Rubin CPX pour la phase de contexte.

- 144 GPUs Rubin pour la phase de génération.

- 36 CPU Vera pour coordonner et optimiser le flux de travail.

Le résultat est une capacité de 8 exaFLOPS en NVFP4, avec 100 To de mémoire haute vitesse et 1,7 Po/s de bande passante, le tout dans un seul rack. Cette puissance dépasse de 7,5 fois celle de la plateforme GB300 NVL72, établissant un nouveau standard dans l’industrie.

L’interconnexion repose sur Quantum-X800 InfiniBand et Spectrum-X Ethernet, complétés par des ConnectX-9 SuperNICs, garantissant faible latence et scalabilité dans les déploiements IA distribués.

Économie de l’inférence : ROI au centre

Au-delà des performances, NVIDIA met en avant l’impact économique. Selon leurs calculs, un déploiement basé sur Rubin CPX peut offrir un retour sur investissement (ROI) entre 30 et 50 fois, générant jusqu’à 5 milliards de dollars de revenus par tokens avec un investissement de 100 millions de dollars en CAPEX.

Cette approche reflète un changement de métrique : on ne mesure plus uniquement en FLOPS, mais en tokens traités de manière rentable, un indicateur clé pour les entreprises proposant des services basés sur l’IA générative.

Cas d’usage des transformateurs

La valeur de Rubin CPX se traduit par des applications concrètes :

- Développement logiciel : assistants capables de comprendre des référentiels entiers, l’historique des commits et la documentation, sans nécessiter de réentraînement.

- Génération vidéo : IA pouvant maintenir une cohérence narrative et visuelle sur des contenus longs, avec une qualité cinématographique.

- Recherche et science : analyse de vastes bases de connaissances, permettant aux agents IA de travailler avec des corpus étendus en temps réel.

- Agents autonomes : systèmes aptes à prendre des décisions complexes grâce à des mémoires contextuelles de millions de tokens.

Un écosystème prêt

Rubin CPX s’intègre parfaitement dans le stack logiciel de NVIDIA :

- TensorRT-LLM, pour optimiser l’inférence des modèles de langage.

- NVIDIA Dynamo, en tant que couche d’orchestration et d’efficacité des ressources.

- Nemotron, famille de modèles multimodaux dotés de capacités avancées de raisonnement.

- NVIDIA AI Enterprise, garantissant des déploiements prêts pour la production dans le cloud, les centres de données et les stations de travail.

Disponibilité

NVIDIA prévoit la disponibilité de Rubin CPX à la fin de 2026, en réponse à la demande croissante pour l’inférence à long contexte et à l’essor des agents IA de nouvelle génération.

Conclusion

Avec Rubin CPX, NVIDIA ne se contente pas de présenter une GPU supplémentaire : elle propose une nouvelle façon de penser l’inférence, en séparant les phases de contexte et de génération, et en offrant un matériel spécialisé pour chacune d’elles.

Dans un monde où l’IA doit comprendre des référentiels complets, générer des vidéos de plusieurs heures et soutenir des agents autonomes, cette architecture apportent non seulement puissance, mais aussi efficacité et viabilité économique.

Rubin CPX et la plateforme Vera Rubin NVL144 CPX redéfinissent le futur de l’IA, plaçant l’inférence massive au cœur du débat technologique et entrepreneurial.

Questions fréquemment posées (FAQs)

Qu’est-ce qui différencie Rubin CPX des autres GPU de NVIDIA ?

Rubin CPX est conçue spécifiquement pour la phase de contexte de l’inférence, optimisant le traitement de longues séquences et offrant jusqu’à 3 fois plus de performance en mécanismes d’attention que les générations précédentes.

Qu’est-ce que l’inférence disaggregée ?

Il s’agit d’un modèle qui divise le traitement en deux phases — contexte et génération — permettant d’optimiser séparément le calcul et la mémoire pour améliorer l’efficacité et la latence.

Quel retour économique peut apporter Rubin CPX ?

NVIDIA estime un ROI de 30 à 50 fois, avec des revenus pouvant atteindre 5 milliards de dollars par tokens pour une investisssement de 100 millions de dollars en infrastructure.

Quand Rubin CPX sera-t-elle disponible ?

La GPU et la plateforme Vera Rubin NVL144 CPX seront prêtes pour les clients à fin 2026.

via : developer.nvidia