Une nouvelle étude de Morgan Stanley Research a quantifié l’activité de l’inférence en intelligence artificielle, confirmant ce que le marché pressentait : NVIDIA conserve un avantage colossal sur ses concurrents, non seulement en puissance hardware mais aussi en rentabilité commerciale.

L’analyse utilise un modèle standard simulant une « usine d’inférence IA » de 100 MW, équivalent à un centre de données de taille moyenne, pour mesurer le coût total de possession (TCO) et les revenus issus du traitement des tokens dans les modèles linguistiques et applications d’IA.

Dans ce contexte, l’étude révèle une marge opérationnelle moyenne supérieure à 50 % pour les grands fournisseurs, faisant de l’inférence l’un des segments les plus lucratifs de l’économie numérique.

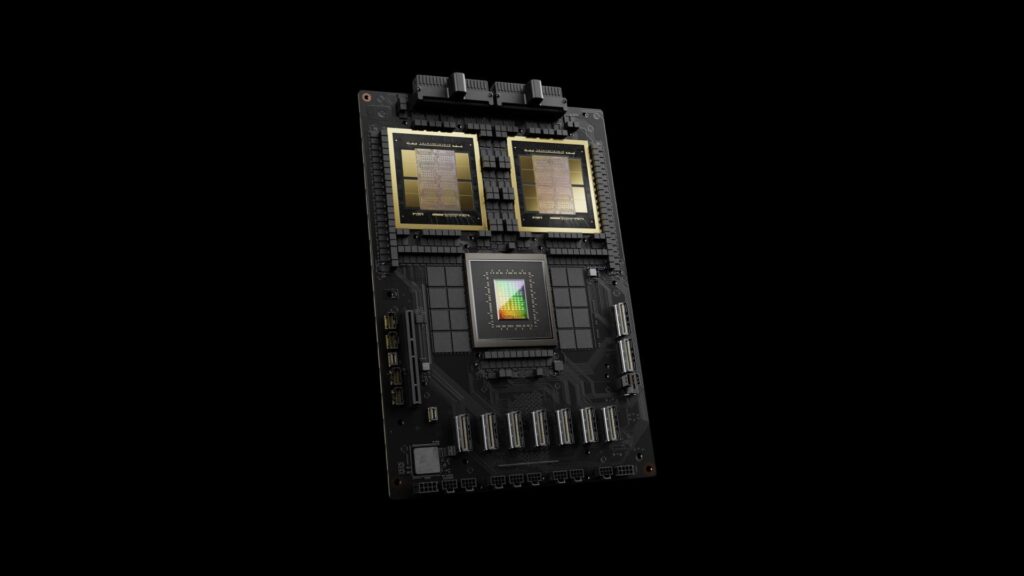

NVIDIA domine de façon incontestable. Sa plateforme GB200 NVL72 Blackwell affiche une marge de 77,6 %, avec des bénéfices estimés à 3,5 milliards de dollars pour une déploiement typique. Cette performance illustre non seulement la puissance de calcul et la mémoire du matériel, mais aussi la robustesse de son écosystème CUDA et ses optimisations pour FP4, qui améliorent considérablement l’efficacité par watt.

Morgan Stanley souligne également l’effet « fine wine » que la société obtient avec ses GPU : même les générations antérieures, comme Hopper, continuent d’évoluer avec des améliorations portées par le logiciel.

En seconde position, on trouve le TPU v6e de Google, avec une marge de 74,9 %, démontrant la capacité d’un fournisseur cloud à rentabiliser ses investissements hardware propriétaires couplés à une intégration logicielle étroite. Amazon Web Services (AWS) avec son Trn2 UltraServer arrive en troisième place, affichant une marge de 62,5 %, consolidant sa stratégie de diversification face à la domination de NVIDIA.

Huawei complète le tableau avec sa plateforme CloudMatrix 384, montrant une marge de 47,9 %, renforçant ainsi sa position sur le marché asiatique.

Du côté d’AMD, la surprise vient du fait que ses dernières plateformes, MI355X et MI300X, affichent des marges négatives de -28,2 % et -64,0 %, respectivement, malgré un TCO équivalent à celui de NVIDIA. La cause principale réside dans une faible efficacité en inference, qui ne génère pas d’entrées suffisantes pour couvrir l’investissement, rendant ces investissements déficitaires dans le scénario modélisé.

L’étude insiste sur le fait que l’inférence représentera près de 85 % de la part de marché de l’IA dans les années à venir, renforçant la position de NVIDIA. La société prépare déjà la nouvelle architecture Rubin, attendue pour 2026, suivie de ses itérations Rubin Ultra et Feynman.

Pendant ce temps, AMD prévoit de lancer le MI400, destiné à concurrencer directement Rubin, tout en promouvant la norme ouverte UALink, qui vise à offrir une alternative à NVLink, bien que l’adoption des écosystèmes reste à confirmer.

En conclusion, NVIDIA ne domine pas seulement sur le plan technologique, mais également sur le terrain financier. Avec des retours sur investissement nettement supérieurs, la société apparaît comme le choix préféré des centres de données et des fournisseurs d’IA. Les acteurs comme Google et AWS montrent que des architectures propriétaires intégrées verticalement peuvent aussi atteindre d’excellentes marges, alors qu’Huawei sécurise sa rentabilité sur le marché asiatique. AMD devra, quant à lui, surmonter le défi d’un écosystème logiciel moins mature, indispensable pour égaler la puissance de CUDA.

Ce panorama indique que, sauf surprise, NVIDIA conservera son leadership jusqu’à la maturité complète du marché de la inference IA, où la société se prépare déjà pour la suite avec ses nouvelles architectures.