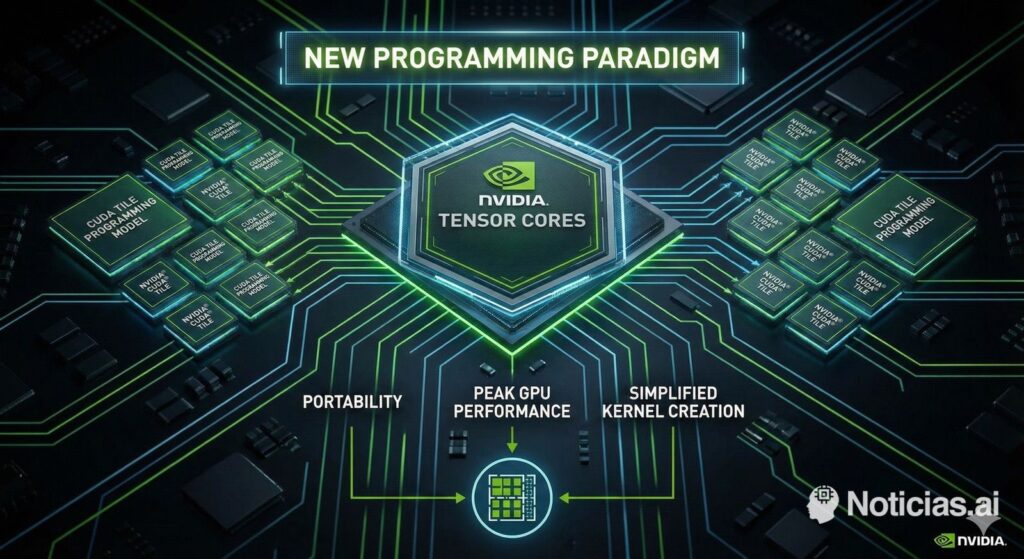

NVIDIA a décidé de franchir une étape sur le seul terrain où elle pouvait encore prendre une avance sur ses concurrents : le logiciel. Avec l’arrivée de CUDA 13.1 et l’introduction de CUDA Tile, la société opère un changement de paradigme majeur dans son modèle de programmation GPU depuis 2006, année où elle a lancé la première version de CUDA.

Le message est clair : après près de 20 ans à affiner les kernels au niveau du thread, du bloc et de la mémoire partagée, NVIDIA souhaite que les développeurs cessent de se concentrer autant sur le matériel et se tournent davantage vers l’algorithme. À court terme, si cette approche réussit, le futur consistera à programmer des “tiles” plutôt que des threads individuels.

Des threads et warps aux tiles : un changement de vision mentale

Jusqu’à présent, programmer en CUDA signifiait gérer avec précision :

- La répartition des threads et des blocs.

- La hiérarchie des mémoires (globale, partagée, registres).

- Les synchronisations au sein d’un bloc et, souvent, des fonctions spécifiques à chaque architecture.

Cette approche permettait d’optimiser au maximum les GPU, mais elle avait un coût : un code fortement lié à la microarchitecture et une courbe d’apprentissage difficile. Adapter un kernel pour une GPU Volta, Ampere ou Hopper n’était pas exactement la même chose, et les équipes expérimentées en programmation de bas niveau avaient un avantage certain.

CUDA Tile cherche à rompre avec ce schéma. Plutôt que de raisonner sur des milliers de threads indépendants, le développeur travaille avec des tiles, c’est-à-dire des fragments logiques de données sur lesquels des opérations de haut niveau sont définies. Ensuite, le compilateur et le runtime se chargent de transformer ce travail en instructions concrètes et de décider des unités du chip à utiliser à chaque étape.

Qu’est-ce que CUDA Tile et pourquoi cela compte

NVIDIA présente CUDA Tile comme un modèle de programmation basé sur des tiles, orienté vers les Tensor Cores et conçu pour être compatible entre différentes générations de GPU. Au cœur du système se trouve Tile IR, une représentation intermédiaire (Intermediate Representation) qui sert de langage virtuel entre le code du développeur et le matériel physique.

À partir de Tile IR, s’appuie cuTile, la première implémentation accessible aux programmeurs. Actuellement disponible en Python, avec des projets pour étendre ce modèle à C++. L’objectif est qu’un ingénieur puisse rédiger des kernels performants en utilisant une syntaxe familière, en définissant des opérations sur des tiles plutôt que de gérer manuellement threads et blocs.

Concrètement, cela signifie que :

- Le programmeur spécifie les calculs effectués sur quels fragments de données.

- Le compilateur décide comment répartir ces tiles entre Tensor Cores, unités de calcul classiques ou moteurs spécialisés comme TMA.

- Le même kernel devrait fonctionner sans modification majeure sur différentes générations de GPU, avec des améliorations automatiques lors de la migration vers du matériel plus récent.

On peut voir cela comme l’équivalent pour la computation de ce que furent, à leur époque, les API de haut niveau en graphisme : le développeur ne traite plus directement avec le “metal” mais délègue une partie de l’optimisation au compilateur.

Blackwell comme première plateforme d’expérimentation

Bien que NVIDIA ne limite pas CUDA Tile à une seule famille, l’entreprise a conçu Blackwell et Blackwell Ultra dès le départ en pensant à ce modèle de programmation. Les nouvelles architectures incluent des Tensor Cores et des chemins de données optimisés pour travailler avec des tiles, permettant ainsi au runtime :

- De décider quelles tiles exécuter sur les accélérateurs internes.

- De gérer la hiérarchie mémoire (L2, mémoire HBM, registres) de façon plus intelligente.

- De réduire latences et d’augmenter l’utilisation des unités spécialisées sans que le développeur ait besoin d’optimiser chaque kernel à la micro.

Ce qui est essentiel, c’est que, suivant la philosophie de CUDA Tile, la responsabilité passe du programmeur au compilateur. Chaque nouvelle génération de GPU peut intégrer de nouvelles instructions ou moteurs internes, et c’est le backend de Tile IR qui apprend à en tirer parti. Le code source reste en principe stable.

Avantages pour les équipes d’IA et de calcul scientifique

Pour celles qui développent des modèles d’IA, des simulations scientifiques ou des applications de high performance computing, cette évolution présente plusieurs bénéfices concrets :

- Moins de code spécifique au matériel

De nombreuses optimisations traditionnelles —comme la gestion micro-optimisée des banques de mémoire ou la conception manuelle de schémas d’accès— peuvent être remplacées par des concepts de haut niveau basés sur les tiles. - Développement plus rapide

Avec cuTile en Python, il est plus aisé de prototyper et d’affiner des kernels complexes. La transition d’un notebook Jupyter à un kernel optimisé devient plus fluide. - Portabilité entre générations

Passer d’une GPU à une autre n’exige plus de réécrire une grande partie du code. L’accent est mis sur la qualité de l’algorithme et l’ajustement des tiles, plutôt que sur l’architecture spécifique du hardware. - Performance plus homogène

En travaillant avec des blocs de données cohérents, le compilateur optimise mieux le flux de données, réduisant ainsi comportement erratique et goulets d’étranglement inattendus.

Un tournant stratégique dans la “guerre de l’écosystème”

Au-delà du volet technique, CUDA Tile renforcera un atout où NVIDIA possède une position quasi incontrounable : son écosystème logiciel. Tandis que d’autres acteurs privilégient des alternatives telles que ROCm, SYCL, oneAPI ou d’autres frameworks open source, NVIDIA consolide un environnement où :

- Le matériel, le compilateur, les bibliothèques et les outils de développement sont parfaitement intégrés.

- Le code écrit aujourd’hui avec CUDA a de fortes chances de continuer à fonctionner — et à performer — dans 5 ou 10 ans avec de nouvelles GPU.

- Les équipes profitent d’outils matures, d’une documentation abondante et d’une communauté mondiale active.

Pour la Chine et l’Europe, qui cherchent à bâtir des écosystèmes propres pour des raisons de souveraineté technologique, cette évolution représente un défi supplémentaire. Il ne suffit pas de produire des puces puissantes : il faut aussi atteindre — ou au moins se rapprocher de — l’avantage cumulé de près de deux décennies d’investissement dans CUDA, auquel s’ajoute une nouvelle étape de changement de paradigme, relevant encore davantage la barre.

Ce qui reste à résoudre

Malgré l’enthousiasme, plusieurs questions restent ouvertes :

- Courbe d’adoption : Les équipes disposant d’un code CUDA “traditionnel” devront décider quand et comment migrer certaines parties vers CUDA Tile.

- Niveau de contrôle : il existera toujours des applications extrêmes nécessitant un contrôle fin. NVIDIA devra équilibrer entre abstraction et puissance de personnalisation.

- Effet de verrouillage fournisseur : Plus ce modèle sera performant et pratique, plus la justification d’une migration vers d’autres plateformes que NVIDIA sera complexe, en particulier dans le cloud souverain.

Ce qui semble évident, c’est que la société a tracé la voie pour la prochaine décennie de la programmation GPU, en jouant sur son terrain privilégié : un matériel puissant associé à un logiciel exploitant chaque transistor de façon optimale.

Questions fréquentes

Quelle différence y a-t-il entre CUDA “classique” et CUDA Tile ?

CUDA classique impose une gestion explicite des threads, blocs et mémoire partagée. CUDA Tile permet de définir des opérations sur des tiles de données de haut niveau ; le compilateur décide comment ces tiles sont mappés au matériel.

Les développeurs doivent-ils tout réécrire avec CUDA Tile ?

Non. CUDA Tile est conçu comme un modèle complémentaire. Le code existant continue de fonctionner, mais les nouvelles applications — notamment en IA — pourront bénéficier d’écrire directement des kernels avec des tiles et cuTile.

CUDA Tile ne fonctionne-t-il que sur la famille Blackwell ?

Blackwell et Blackwell Ultra sont les premières architectures conçues dès le départ avec ce modèle en tête, mais NVIDIA prévoit d’étendre la compatibilité aux futures générations et, probablement, à une partie des GPU existants lorsque le matériel le permettra.

Quel impact cela a-t-il sur la concurrence et la souveraineté technologique ?

Plus l’écosystème CUDA sera avancé et productif, plus la dépendance de ceux qui s’appuient sur les GPU NVIDIA sera forte. Pour les régions souhaitant développer leurs propres solutions, cela alourdit la barre en termes d’outils, performances et stabilité.

Source : Nvidia CUDA Tile

Starlink contre la fibre optique : laquelle choisir, comment fonctionne chacune et à quoi s’attendre en termes de latence et de vitesse