NVIDIA fait face à un défi aussi prosaïque que crucial : la gestion de la chaleur. Au fur et à mesure que chaque génération d’accélérateurs IA augmente leur consommation et leur densité dans des châssis complets, la question ne se limite plus à “combien de TOPS” ou “quel est l’bande passante mémoire”, mais devient comment évacuer la chaleur de manière continue et sûre. Selon des informations avancées par le compte @QQ_Timmy, la société aurait commencé à coordonner avec ses partenaires un changement stratégique pour sa prochaine famille Rubin Ultra: des plaques froides à microcanaux (microchannel cold plates) avec refroidissement direct au puce (direct-to-chip, D2C). L’objectif n’est pas anodin : maximiser le rendement par watt tout en offrant une marge thermique pour une évolution générationnelle qui, de Blackwell à Rubin, vise une augmentation des capacités électriques dans des configurations à l’échelle des racks.

Ce rapprochement technique ne s’arrête pas là. Parallèlement, Microsoft a présenté sa solution de refroidissement microfluide, une approche liée aux microcanaux mais qui, dans son cas, privilégie le “refroidissement in-chip”: un liquide circulant dans le ou derrière le silicium pour maximiser l’échange thermique. Au-delà des nuances, cette convergence témoigne d’un message clair : l’industrie a besoin de nouvelles options pour répondre aux enjeux de puissance thermique qu’exige l’ère de l’IA.

Excessive Concerns Over Microchannel Cover Plate Issues; Growth in Rubin GPU and ASIC Demand to Boost Liquid Cooling Revenue in 2026.

Le marché rumore que le refroidissement du GPU Rubin (TDP 2.3kW) pourrait adopter une plaque à microcanaux (MCL), mais des mises à jour récentes… pic.twitter.com/JFCj1Yrc6C

— 駿HaYaO (@QQ_Timmy) 4 octobre 2025

Qu’est-ce qu’une “plaque à microcanaux” et pourquoi devient-elle cruciale maintenant ?

Les plaques à microcanaux (ou MCCP) représentent, en gros, une évolution des plaques froides traditionnelles déjà utilisées dans des systèmes à haute performance. À l’image des overclockeurs qui exploitent le “refroidissement direct du die” sur des CPU modernes, les MCCP approchent le liquide le plus près possible du dado du processeur, en utilisant des canaux microscopiques souvent usinés dans du cuivre. Ces microcanaux augmentent la convection locale et réduisent la résistance thermique entre le die et le liquide, ce qui se traduit par des températures de jonction plus basses ou, autrement dit, plus de marge pour maintenir les fréquences et les charges plus longtemps.

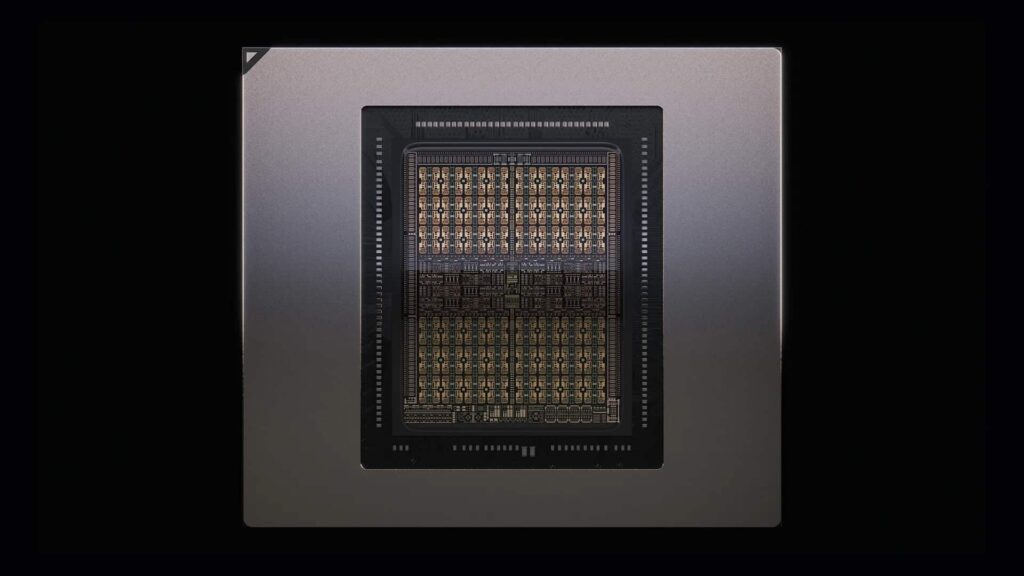

Ce n’est pas qu’une différence esthétique avec une plaque liquide classique : le design interne — largeur et hauteur du canal, géométrie, rugosité, distribution — est optimisé pour cibler les points chauds du die et homogénéiser le flux. Ce genre de détail est essentiel quand il s’agit d’accélérateurs dotés de dizaines de milliers de cœurs, de multi-stacks HBM et d’interconnexions qui totalisent des téraoctets par seconde. Dans la documentation NVIDIA, on évoque Rubin Ultra en configurations NVL orientées vers la inférence FP4 à environ 15 EF et des liaisons pouvant atteindre 115,2 TB/s (CX9 8x). De telles performances ne font pas que embellir le calcul : elles augmentent aussi la charge thermique.

De Blackwell à Rubin : pourquoi la gestion thermique devient une priorité

La fréquence des lancements de NVIDIA ne laisse que peu de répit. Chaque étape —Ampere, Hopper, Blackwell, et maintenant Rubin— introduit des avancées en architecture, mémoire et réseaux… mais aussi, le plus souvent, une augmentation de la consommation globale à l’échelle du système. Ce n’est pas seulement la GPU : ce sont aussi les topologies à l’échelle rack, les backplanes, les switches et tout l’hardware associé dans un “pod” IA moderne. À ce niveau, l’air ne suffit plus ; la refroidissement liquide conventionnel pourrait même ne pas être capable de suivre lorsque l’on veut densifier sans compromettre la stabilité.

C’est pourquoi, selon des fuites, NVIDIA aurait contacté des fournisseurs de solutions thermiques pour intégrer D2C à base de microcanaux dans Rubin Ultra. Un nom qui revient souvent est Asia Vital Components (AVC), un fabricant taïwanais spécialisé dans des solutions de refroidissement. La démarche n’est pas totalement nouvelle — leur expertise dans les plaques froides pour diverses applications est connue — mais cela représenterait une avancée en efficacité mieux adaptée aux défis actuels.

À préciser aussi, le timing : ces options étaient peut-être envisagées pour Rubin, mais les délais très serrés ont poussé NVIDIA à privilégier Rubin Ultra. Le tout, sans que la chaîne d’approvisionnement puisse être totalement adaptée pour le moment, en matière de design, matériaux, tests ou maintenance.

Microcanaux “direct-to-chip” : avantages et défis

Les points positifs

- Résistance thermique réduite : en rapprochant le liquide du silicium, le gradient thermique s’améliore, tout comme la uniformité de la température sur le die.

- Performance soutenue : moins de throttling lors de charges longues ; plus facile de maintenir le boost sans que les points chauds ne limitent la fréquence.

- Densité : permet de compacter davantage dans le rack sans sacrifier la fiabilité.

- Performance/Watt : une meilleure efficacité thermique se traduit par une utilisation optimisée de chaque watt consommé.

Ce qu’il faut encore résoudre

- Pertes de charge : les microcanaux nécessitent une plus grande pression ; des pompes plus puissantes et un filtrage plus fin sont nécessaires pour éviter l’encrassement.

- Matériaux : compatibilité (cuivre, joints, adjuvants dans le liquide) afin de réduire corrosion et dégradation.

- Maintenance : procédures de service, tests d’étanchéité, remplacement de modules et nettoyage du circuit.

- Intégration : manifolds, quick disconnects, capteurs (débit, pression, fuites) et surveillance intégrée au BMC du système.

Ces éléments ne sont pas nouveaux dans le HPC. La gestion direct-to-chip cohabite avec d’autres solutions — immersion en 1 ou 2 phases, ou microfluide microfluide présentée par Microsoft — chacune apportant un équilibre propre entre efficacité, complexité et opérationalité. L’essentiel est que le point de départ du secteur n’est plus “passons au liquide”, mais “quel liquide et dans quelle architecture”.

En quoi la microfluide “in-chip” de Microsoft se distingue-t-elle ?

La proposition de Microsoft pousse plus loin le contact plaque-die pour placer le liquide “dans” ou à l’arrière du silicium (backside cooling). C’est un concept plus avancé en termes de fabrication et de packaging, qui peut offrir des avantages dans le cas d’évacuation calorique depuis plusieurs couches du die (pensons en 3D stacking). Les plaques à microcanaux de NVIDIA — si elles se confirment — adopteraient une approche plus pragmatique : optimiser la plaque froide existante, en réduisant la résistance thermique et en améliorant la convection, sans empiéter sur la stack du die.

Les deux options ne s’excluent pas mutuellement. À terme, on peut envisager des combinaisons — microcanaux intégrés dans la plaque, associée à des améliorations derrière le die — lorsque architectures et fournisseurs seront mûrs.

De la plaque à la salle : implications pour les centres de données

Pour les opérateurs, cette évolution soulève des questions concrètes :

- Chauffe-eau : quelles températures d’entrée/sortie demander pour ces systèmes ? Plus la température de retour est élevée, meilleur sera le PUE du bâtiment.

- Circuit secondaire : quelles pressions et débits par “pod” ? Un filtrage fin est-il nécessaire pour les microcanaux ?

- Détection de fuites et traçabilité : capteurs et télémétrie intégrés au BMC et au DCIM.

- Maintenance : délais et outils pour remplacer un module sans arrêter le châssis (connecteurs rapides, systèmes sans goutte-à-goutte).

- Compatibilité : peut-on mélanger dans une même rangée des systèmes d’immersion et de refroidissement direct au chip ? Quels systèmes de manifolds permettent de faire évoluer sans reconstruction complète ?

Rien de tout cela n’est insurmontable. Plusieurs centres HPC de référence opèrent déjà avec du D2C et de l’immersion. La nouveauté, c’est qu’on parle maintenant d’échelle IA, avec des pods passant de dizaines à centaines de kW par rack, et de chaînes d’approvisionnement qui doivent standardiser et massofficer composants.

Partenaires, calendrier et ce que l’avenir réserve

Le nom d’Asia Vital Components (AVC) circule comme partenaire thermique pour les MCCP de Rubin Ultra. Selon les mêmes sources, le plan était de déployer cette technologie sur Rubin, mais les délais ayant été très serrés, NVIDIA aurait privilégié Rubin Ultra. La société maintient son rythme d’itérations sans communiquer précisément sur les dates ou les configurations finales.

Au-delà des fuites, il faut surveiller certains signaux :

- Annonces conjointes avec des fabricants de plaques froides et des OEM de châssis.

- Guides pour les manifolds, capteurs et procédures.

- Spécifications thermiques dans les futures publications de NVL (en W et températures d’entrée).

- Comparatifs en PUE/TUE et performance soutenue entre Rubin et Rubin Ultra.

- Écosystème : voisines de d’autres grands acteurs, pour voir si la tendance D2C microcanaux ou microfluide in-chip se répand.

Analyse approfondie : rendement par watt et coût total

Ce changement n’est pas qu’esthétique. Si les MCCP parviennent à baisser significativement la résistance thermique, NVIDIA pourra maintenir des boosts plus élevés et des charges plus longues, sans compromettre la fiabilité du silicium ni celle de la HBM. Dans un contexte où le calcul s’achète en temps et où l’air influence le taux d’utilisation, toute amélioration thermique impacte le TCO : plus de travail par énergie dépensée, moins d’intervalle pour le throttling lorsque la salle se refroidit moins.

Tout cela crée un cercle vertueux : meilleure température, moins de pression et débit dimensionnés intelligemment, maintenance anticipée, télémétrie précise pour prévenir les sédiments ou microfuites. Le risque d’un déploiement hâtif, sans préparation adéquate des installations, étant de générer des incidents inutiles.

En résumé

Ce retournement vers une refroidissement de précision reflète parfaitement la situation actuelle de l’IA : Rubin Ultra vise une augmentation du pouvoir de calcul, de la bande passante et de la densité. NVIDIA, semble-t-il, est prête à répondre avec des microcanaux directs au chip pour maîtriser le térmique sans ralentir le rythme de progrès. Et elle n’est pas seule : la microfluide in-chip de Microsoft confirme que la course au vatio utile est aussi une compétition d’ingénierie.

Les mois à venir diront si ce pas en avant se traduit en produits et procédures solides à grande échelle. Mais un message est clair : dans la course à la meilleure performance par watt, la plaques froides ne sont plus un simple accessoire, mais une technologie stratégique.

Questions fréquentes

Qu’est-ce qu’une plaque à microcanaux (MCCP) et en quoi améliore-t-elle une plaque froide traditionnelle ?

Une MCCP est une plaque — généralement en cuivre — dotée de canaux microscopiques où circule le fluide juste au-dessus du die. Cette configuration améliore la convection et diminue la résistance thermique comparée à une plaque avec cavités plus simples, permettant ainsi des températures de jonction plus basses et un rendement supérieur.

Que signifie le refroidissement “direct-to-chip” pour un centre de données IA ?

Cela implique d’amener un liquide au niveau de la puce via des manifolds et quick-disconnects, avec capteurs de débit, pression et fuites. Ce dispositif nécessite des usines d’eau tempérée, un filtrage précis et des procédures d’entretien. En contrepartie, il offre une densité, une efficacité thermique accrue et une réduction du throttling.

En quoi la microfluide “in-chip” de Microsoft diffère-t-elle de l’approche NVIDIA ?

Microsoft pousse le contact liquide plus loin : le liquide est placé dans ou derrière le silicium. C’est un procédé plus avancé, mais aussi plus complexe, adapté aux refroidissements multi-couches et 3D stacking. La solution NVIDIA, plus pragmatique, cherche à optimiser la plaque existante, pour réduire la résistance thermique sans empiéter sur la stack du die.

Pourquoi la gestion thermique de Blackwell à Rubin devient-elle si exigeante ?

Chaque génération augmente le calcul, la mémoire et l’interconnexion, ce qui augmente la consommation totale des systèmes — pas seulement de la GPU. Les topologies à l’échelle du rack, backplanes et autres composants y contribuent. La refroidissement liquide avancé, comme D2C ou microcanaux, devient donc une nécessité pour maîtriser cette montée en puissance.

vía : wccftech