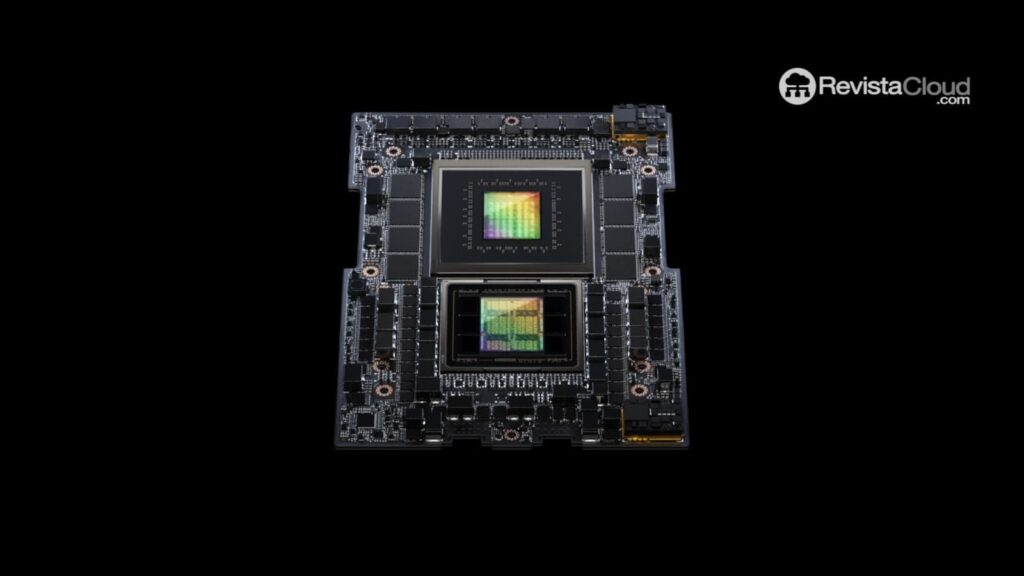

Dans un mouvement audacieux vers l’avenir de l’informatique accélérée et de l’intelligence artificielle générative, NVIDIA a présenté la plateforme GH200 Grace Hopper™, une révolution technologique incarnée dans le nouveau Superchip Grace Hopper avec le premier processeur HBM3e au monde. Conçue pour relever les défis des charges de travail d’intelligence artificielle générative les plus complexes, y compris des modèles de langage étendus, des systèmes de recommandation et des bases de données vectorielles, cette plateforme promet de transformer le paysage informatique.

Une Fusion de Puissance et de Capacité : Configuration Double pour une Performance Exceptionnelle

La configuration double de cette plateforme, qui offre jusqu’à 3,5 fois plus de capacité de mémoire et 3 fois plus de bande passante que sa prédécesseure, est composée d’un serveur unique équipé de 144 cœurs Arm Neoverse, huit pétaflops de performance en IA et 282 Go de la dernière technologie de mémoire HBM3e. Cette avancée représente une percée significative dans la capacité de traitement et de stockage de données, établissant une nouvelle norme dans l’industrie.

Vision de Jensen Huang : Des Plateformes d’Informatique Accélérée pour la Demande en IA Générative

Jensen Huang, fondateur et PDG de NVIDIA, souligne le besoin de plateformes informatiques accélérées avec des besoins spécialisés pour répondre à la demande croissante en IA générative. La plateforme Superchip GH200 Grace Hopper répond à ces exigences en offrant une technologie de mémoire exceptionnelle, la capacité de connecter plusieurs GPU et une conception de serveur facilement évolutive à travers tout le centre de donnéesUn centre de données ou un centre de traitement de données (CTD) ….

Connectivité et Mémoire de Pointe : Superchips Grace Hopper et HBM3e

Le Superchip Grace Hopper peut être interconnecté avec d’autres Superchips via NVIDIA NVLink™, facilitant le déploiement des modèles géants utilisés dans l’IA générative. Cette technologie cohérente à haute vitesse permet au GPU d’accéder entièrement à la mémoire du CPU, offrant 1,2 To de mémoire rapide en configuration double. La mémoire HBM3e, 50 % plus rapide que l’actuelle HBM3, fournit un total de 10 To/s de bande passante combinée, permettant à la nouvelle plateforme d’exécuter des modèles 3,5 fois plus grands que la version précédente et d’améliorer la performance avec une bande passante mémoire 3 fois plus rapide.

Adoption et Disponibilité : Un Avenir Brillant avec Grace Hopper

Des fabricants de premier plan proposent déjà des systèmes basés sur le Superchip Grace Hopper annoncé précédemment. Pour encourager une adoption large de la technologie, la plateforme de prochaine génération Grace Hopper GH200 avec HBM3e est entièrement compatible avec la spécification de serveur NVIDIA MGX™, présentée à COMPUTEX plus tôt cette année. Avec MGX, tout fabricant de systèmes peut ajouter rapidement et de manière rentable Grace Hopper dans plus de 100 variantes de serveurs.

Il est prévu que les principaux fabricants de systèmes fournissent des systèmes basés sur la plateforme au cours du deuxième trimestre de l’année civile 2024.

Découvrez plus sur Grace Hopper dans l’adresse de SIGGRAPH de Jensen Huang, disponible à la demande, ouvrant un nouveau chapitre dans l’histoire de l’informatique accélérée et de l’IA générative.