NVIDIA Face à une Nouvelle Menace : Les ASIC Pourraient Ils Dépasser les GPU ?

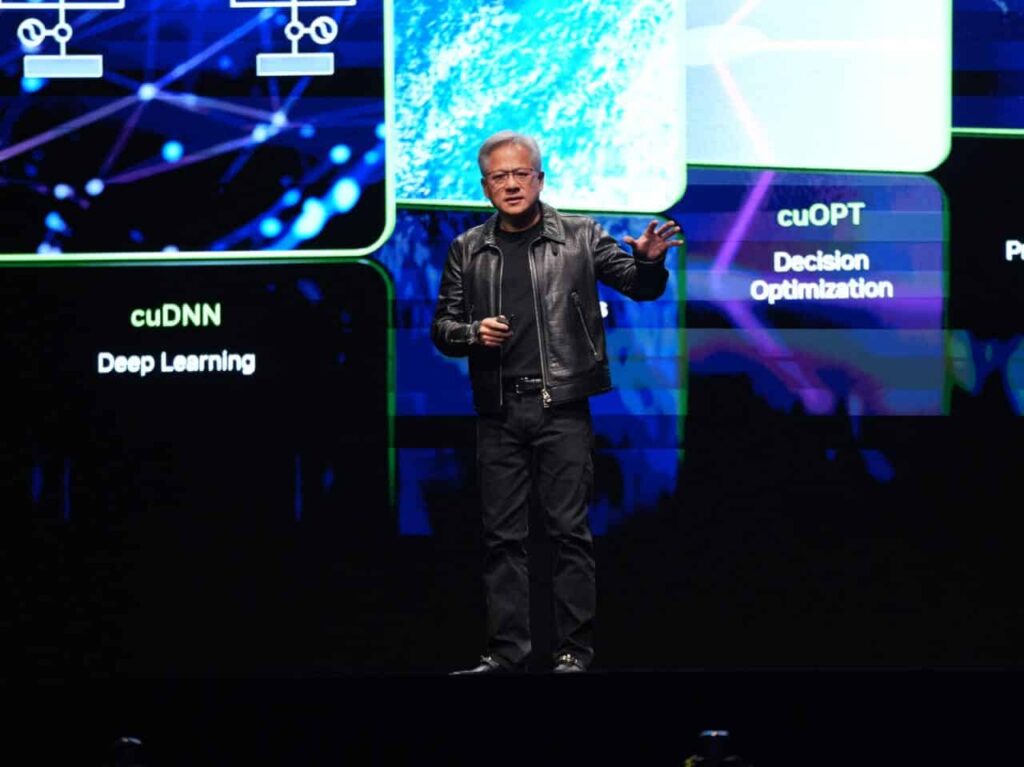

Jensen Huang, le PDG de NVIDIA, a soulevé un débat de plus en plus pertinent dans le secteur technologique : les circuits intégrés spécifiques (ASIC) pourraient-ils un jour détrôner les unités de traitement graphique (GPU) en tant que norme pour l’intelligence artificielle ? Actuellement, les GPU de NVIDIA représentent le cœur de l’entraînement et de l’inférence des modèles d’IA les plus avancés, mais l’avancée rapide des ASIC conçus sur mesure par des entreprises comme Google, Amazon et OpenAI pourrait transformer le marché dans les prochaines années.

GPU contre ASIC : La Bataille Technologique pour l’Intelligence Artificielle

Les GPU sont traditionnellement les chouchous pour entraîner des modèles d’IA. Leur principal atout réside dans leur polyvalence : elles peuvent effectuer des opérations en parallèle à grande échelle, s’adapter à de multiples charges de travail et sont compatibles avec un large écosystème d’outils et de bibliothèques (comme CUDA). Cela les rend idéales pour la recherche et le développement de nouveaux modèles.

En revanche, les ASIC sont conçus pour des tâches spécifiques. Tandis que les GPU peuvent accomplir une multitude de fonctions — parfois sans la plus grande efficacité — les ASIC sont créés pour exécuter une fonction précise avec une performance optimale. Concernant l’IA, cela signifie qu’un ASIC peut traiter des tâches d’inférence ou d’entraînement avec une consommation d’énergie réduite et un coût d’opération inférieur, bien qu’avec moins de flexibilité.

Avantages et Inconvénients : GPU versus ASIC

| Caractéristique | GPU (NVIDIA) | ASIC |

|---|---|---|

| Polyvalence | Très polyvalentes ; adaptables à diverses tâches | Limitées à des fonctions spécifiques |

| Écosystème | Large support logiciel (CUDA, TensorRT, PyTorch) | Écosystème fermé ; nécessite un développement sur mesure |

| Performance brute | Élevée pour les tâches générales d’IA et de graphisme | Performance maximale pour des tâches spécifiques |

| Coût par unité | Élevé, surtout pour les modèles haut de gamme | Moins cher, mais investissement initial requis pour le design |

| Consommation d’énergie | Élevée, surtout dans les opérations prolongées | Beaucoup plus efficace énergétiquement |

| Flexibilité future | Adaptables aux futures améliorations et modèles | Obsolètes si la tâche spécifique change |

| Disponibilité | Affectée par des problèmes d’approvisionnement | Dépendante de la production interne, sans intermédiaires |

La Position de NVIDIA et la Crainte d’un Changement de Paradigme

Lors de son intervention, Jensen Huang a affirmé que les ASIC ne sont pas encore compétitifs par rapport aux GPU pour des tâches complexes d’entraînement, mais il n’a pas caché son inquiétude : « Si les entreprises commencent à produire des ASIC en masse et qu’ils atteignent des niveaux compétitifs dans l’entraînement et l’inférence, notre leadership pourrait être menacé. »

Des entreprises comme Google, avec ses TPU, ainsi qu’Amazon et Microsoft, sont déjà en train de développer des puces IA propres. Même OpenAI a commencé à concevoir ses propres ASIC pour éviter la dépendance à NVIDIA.

Le Risque pour NVIDIA

Si les entreprises parviennent à obtenir des résultats similaires ou supérieurs avec des puces conçues sur mesure, le modèle économique de NVIDIA pourrait être gravement impacté. Le marché pourrait passer des commandes de dizaines de milliers de GPU à un choix de solutions propriétaires plus efficaces, laissant NVIDIA avec un surplus de production et une chute des ventes ayant des répercussions sur sa valeur boursière.

Conclusion : Qui Sera le Vainqueur de la Course ?

Pour l’instant, les GPU demeurent la solution la plus flexible et répandue. Cependant, l’optimisation et l’efficacité commencent à prendre de l’importance dans un secteur de plus en plus soucieux des coûts et de la durabilité énergétique. Les ASIC représentent une menace latente que NVIDIA ne peut pas se permettre d’ignorer. La grande question est de savoir si la firme saura se réinventer pour conserver sa domination ou si les géants technologiques préféreront investir dans des solutions personnalisées qui réduisent leur dépendance à un seul fournisseur.

L’avenir du matériel pour l’intelligence artificielle est en jeu, et la guerre entre GPU et ASIC ne fait que commencer.

Source : Actualités Intelligence Artificielle