Une équipe de l’Institute of Science Tokyo présente une méthode qui traduit l’information d’état du canal (CSI) des réseaux Wi-Fi en un espace latent d’un modèle de diffusion, générant des images RGB haute résolution de l’environnement, avec efficacité et contrôle par texte.

Le Wi-Fi peut-il “voir” à travers les changements que les personnes et objets apportent au canal radio ? Cette idée circule depuis des années dans les laboratoires : de la reconnaissance d’activités au suivi de la respiration, avec une bande passante suffisante. Ce qui manquait, c’était de faire un saut vers des reconstructions visuelles haute résolution, sans recourir à des entraînements coûteux ad hoc ni à des architectures complexes. C’est là qu’intervient LatentCSI, une approche qui prend la CSI (Channel State Information) d’un lien Wi-Fi multicarrier, la mappe dans un espace latent et laisse un modèle de diffusion latent pré-entraîné réaliser le reste, guidé par du texte pour affiner styles ou éléments de la scène.

Signé par Eshan Ramesh et Takayuki Nishio (School of Engineering, Institute of Science Tokyo), le travail — “High-resolution efficient image generation from WiFi CSI using a pretrained latent diffusion model” — décrit un système qui évite la génération pixel par pixel. Au lieu de cela, il entraîne un réseau léger pour prédire directement l’embedding latent que produirait un VAE (Variational Autoencoder) d’un LDM (modèle de diffusion latent) pour l’image correspondante. À partir de là, le pipeline connu du LDM débruite dans l’espace latent (optionnellement avec des instructions textuelles) et décode en image RGB.

Ce que résout LatentCSI et pourquoi c’est crucial

Les tentatives antérieures pour “voir” via Wi-Fi s’appuyaient sur des GANs ou des VAE sophistiqués : deux réseaux en compétition, calibration précise, entraînements instables… et des résultats limités en résolution. De plus, l’apprentissage end-to-end sur des images réelles tend à mémoriser des détails, avec des risques pour la vie privée : traits faciaux, arrière-plans reconnaissables, etc.

LatentCSI simplifie :

- Un seul réseau (l’encodeur CSI) apprend à prédire l’embedding latent que produirait le VAE d’un LDM pour l’image associée.

- On travaille toujours dans l’espace latent (beaucoup plus compact que l’espace pixels), avec moins de coûts et moins de mémoire.

- Le goulot d’étranglement dimensionnel réduit la probabilité de reconstruire détails sensibles (visages, textes), et la guidance par texte du LDM permet de reconstruire/styliser ce qui est nécessaire (vêtements, style de la scène, apparence générale) de manière contrôlée.

En résumé : meilleure qualité perceptuelle par rapport à des méthodes de complexité similaire qui prédisent pixels, plus d’efficacité computationnelle et contrôle par texte sans étapes supplémentaires de codage d’image.

Le fonctionnement (sans mystère) : du CSI à l’espace latent

- Données appariées lors de l’entraînement : CSI + image (la caméra n’est utilisée en entraînement que pour avoir une référence ; lors du déploiement, on infère seulement avec le CSI).

- Un VAE pré-entraîné du LDM code l’image dans un embedding latent μ (en pratique, ils utilisent la moyenne du postérieur Gaussien, la variance étant négligeable).

- Le codeur CSI (fw(x)) s’entraîne pour récupérer μ à partir de l’amplitude CSI (en évitant la phase pour simplifier et améliorer la robustesse avec des appareils non synchronisés).

- En inférence, le LDM ajoute du bruit contrôlé à l’embedding (paramètre “strength”) et débruite avec guidage textuel (si désiré), avant de décoder en image RGB.

La clé : seulement l’encodeur CSI s’entraîne ; le LDM (U-Net de débruitage, VAE, et encodeur de texte) est réutilisé sans fine-tuning. Cela rend l’entraînement plus économique et hérite de la qualité perceptuelle du LDM.

Jeux de données et évaluation : moins de pixels, plus de perception

Les auteurs valident LatentCSI sur deux jeux de données :

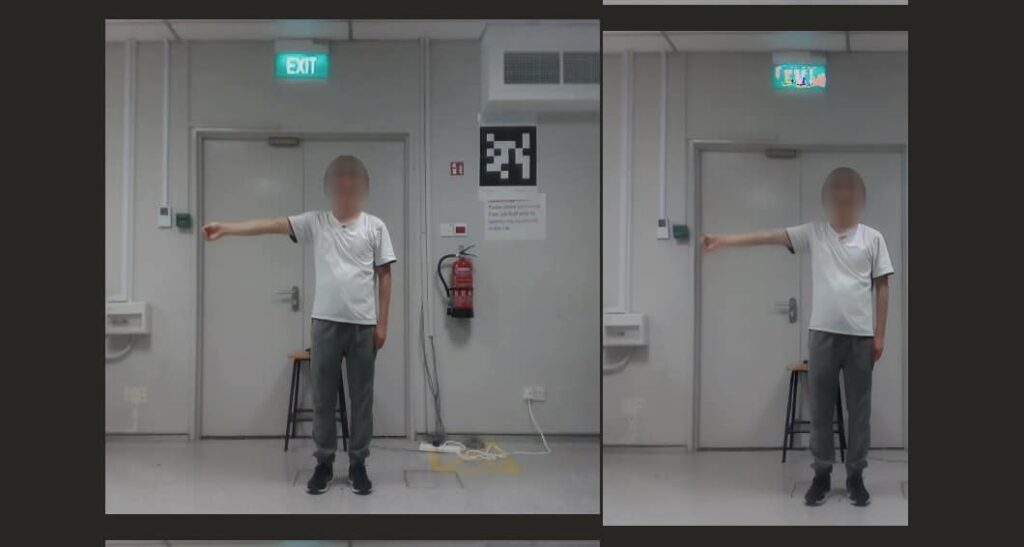

- Jeu 1 : environnement réaliste avec une personne en mouvement, occlusions fréquentes et diversité de vues. CSI à 10 Hz pendant 25 minutes avec deux NUC et Intel AX210 (canal 160 MHz, 1×1, 1992 sous-porteuses avec FeitCSI). Image 640×480 redimensionnée en 512×512.

- Jeu 2 (MM-Fi, sous-ensemble) : plus de cohérence visuelle (position fixe, fond stable), 3 antennes, 40 MHz × 114 sous-porteuses (total 342), axé sur poses et mouvements de bras.

Méthriques

Comparaison avec une ligne de référence qui prévoit directement les pixels avec une architecture équivalente (sauf pour la sortie), et avec CSI2Image (GAN hybride). Les mesures incluent RMSE, SSIM (fidélité structurale), et FID (perception visuelle), à la fois sur images complètes et sur des découpes de personnes (détectées avec YOLOv3).

- Sur le jeu 1, LatentCSI domine clairement en FID (meilleure perception), avec des temps d’entraînement considérablement inférieurs à la baseline pixel dû à la sortie à faible dimension.

- Sur MM-Fi, le baseline excelle en RMSE/SSIM (scène répétitive qui favorise la “mémoire”), mais LatentCSI remporte à nouveau en FID, particulièrement lorsqu’il se concentre sur les personnes. La GAN hybride est en retrait dans tous les cas.

Au-delà des chiffres, les auteurs soulignent que les sorties de LatentCSI constituent de meilleurs points de départ pour le raffinement par diffusion (réglages avec “strength” et prompts), alors que la baseline surentraine ou produit des artefacts lors du passage à haute résolution.

Privacité et contrôle : pourquoi le “goulot d’étranglement” est utile

Un aspect particulièrement intéressant est la tension entre utilité et vie privée. Le passage par l’espace latent évite de faire remonter des micro-détails potentiellement identifiables (visages précis ou textes lisibles en fond), tout en permettant néanmoins des reconstructions crédibles et des éditions guidées par texte (“photo d’une personne dans une petite salle, 4K, réaliste”; “dessin style anime en laboratoire”, etc.). En conservant la correspondance avec le CSI (qu’y a-t-il et où, à un niveau sémantique), le LDM synthétise les détails visuels sous contrôle utilisateur.

Pour des applications sensibles (santé, bureaux, foyers), cet approche réduit les risques par conception, contrairement à des pipelines qui “fixent” l’image originale.

Limitations et réalisme

LatentCSI part du principe que l’on dispose d’une information suffisante dans le CSI pour remplacer objets et personnes de manière cohérente sur le plan visuel, ce qui dépend de la scène, de la géométrie TX/RX, de la bande passante et du SNR. Il faut aussi des paquets CSI-image lors de l’entraînement (par ex. calibration avec caméra), même si en inférence, seul le CSI est utilisé. Enfin, le LDM pré-entraîné apporte une capacité perceptuelle apprise du monde, pas du CSI, ce qui peut entraîner des hallucinations stylistiques; la guidance par texte et l’ajustement du “strength” contrôlent ce phénomène.

Ce que cela apporte à la recherche actuelle

- Architecture simple: un seul encodeur CSI → embedding latent → pipeline LDM réutilisé.

- Efficience: entraîner en espace latent réduit le coût, la mémoire, et accélère les epochs par rapport à la prédiction pixel.

- Qualité perceptuelle: meilleure FID et cohérence sémantique dans des scènes dynamiques.

- Contrôle: prompts textuels pour modifier / styliser sans codage d’image (pas de processus classique img2img).

- Privacité par conception: moindre risque de reproduction de traits sensibles; contenu crédible sous contrôle explicite.

Intégration dans des produits réels

- Sécurité/IoT: monitoring non intrusif de lieux sans caméras actives; alertes sémantiques (“personne debout près de la porte”).

- Maisons intelligentes/Assistance: détection de chutes ou de présence avec un feedback visuel synthétique, sans exposer la personne réelle.

- Retail/Logistique: distribution d’objets ou activité dans des couloirs sans caméras, avec reconstruction visuelle contrôlée.

- Robotique/Edge: cartographie sémantique rapide via radio dans des endroits où la vision échoue (fumée, faible luminosité).

Toujours avec une calibration initiale et une évaluation légale: même si la reconstruction n’est pas photographique, il s’agit d’une représentation de personnes et d’espaces, nécessitant consentement, information et contrôles.

Questions fréquentes

Une caméra est-elle nécessaire en production ?

Non. La caméra n’est utilisée qu’en entraînement pour faire correspondre CSI et image, afin d’apprendre au codeur CSI l’embedding latent correct. En déploiement, l’inférence se fait seulement avec le CSI.

Quel modèle de diffusion est utilisé ?

Le système fonctionne avec un modèle de diffusion latent pré-entraîné (par ex., Stable Diffusion). Le codeur CSI s’entraîne pour imiter l’embedding que produirait le VAE de cet LDM, puis on utilise le débruiteur et le décoder préexistants.

Est-ce “voir à travers les murs” ?

Le CSI capte la trace de l’environnement (réflexions, multi-trajets). Avec une configuration adéquate et bande suffisante, on peut détecter la présence et des structures. Cependant, la méthode ne garantit pas une vision photographique à travers les murs; elle synthétise une image plausible, cohérente avec le CSI et le prompt, tout en respectant des limites physiques.

Et la vie privée ?

Le goulot d’étranglement latent complique la reconstitution de traits sensibles. La guidance textuelle permet d’anonymiser / styliser (par exemple, style dessin animé) ou d’éviter de produire des visages ou textes. Toutefois, en tant que représentations de personnes ou d’espaces, cela doit respecter la réglementation, le consentement, et les bonnes pratiques.

Quelle qualité attendre dans des scènes réelles et bruyantes ?

Dans des environnements dynamiques et avec occlusions, LatentCSI a montré une meilleure qualité perceptuelle que des baselines similaires, avec moins de coût d’entraînement. La fidélité précise dépendra de la bande passante, de la géométrie, du SNR, et de la calibration; les réglages de “strength” et prompts aident à équilibrer réalisme et contrôle.

Crédits et support : ce travail évoque un financement par JSPS KAKENHI et JST ASPIRE, ainsi que l’utilisation de l’ordinateur super puissant TSUBAME4 (Institute of Science Tokyo). Le code et les jeux de données tiers mentionnés incluent MM-Fi et des outils comme FeitCSI.