L’adoption de l’intelligence artificielle (IA) générative continue de croître, mais l’infrastructure nécessaire pour soutenir cette croissance fait face à un écart important entre l’offre et la demande. Selon une analyse d’IDC, 66% des entreprises du monde entier investiront dans cette technologie au cours des 18 prochains mois. En 2024, l’infrastructure représentera 46% des dépenses totales. Toutefois, une composante clé du matériel nécessaire à sa construction est en pénurie.

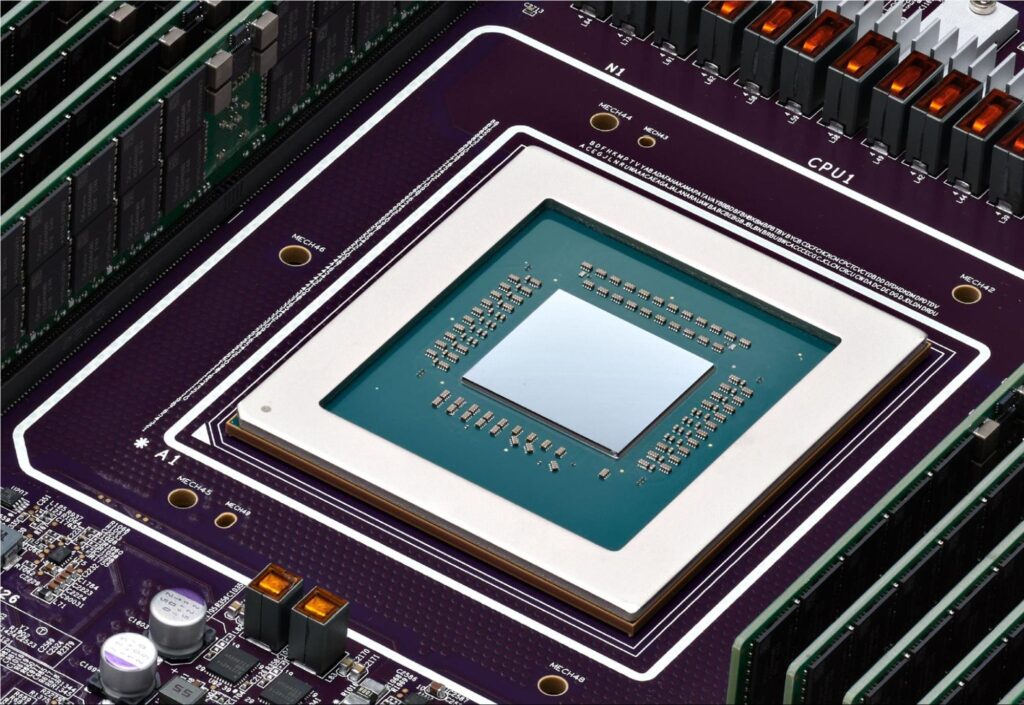

Le rythme effréné de l’adoption de l’IA ces deux dernières années a mis à l’épreuve la capacité de l’industrie à fournir les puces spéciales à haute performance, nécessaires pour exécuter des opérations intensives en traitement. Beaucoup d’attention a été portée sur la demande croissante en GPU de Nvidia et des alternatives par les concepteurs de puces comme AMD et Intel, ainsi que les exploitants de centres de données hyperscales, selon Benjamin Lee, professeur au Département d’Informatique et Science de l’Information de l’Université de Pennsylvanie. « On a beaucoup moins prêté attention à l’explosion de la demande de puces mémoire à large bande passanteLa bande passante est la capacité maximale de transfert d…, qui sont fabriquées dans des fonderies en Corée gérées par SK Hynix».

Demande pour la mémoire HBM

La semaine dernière, SK Hynix a signalé que ses produits de mémoire à haute bande passante (HBM), nécessaires en complément des GPU à haute performance pour gérer les exigences de traitement de l’IA, sont presque épuisés jusqu’en 2025 en raison de la forte demande. Le prix des HBM a récemment augmenté de 5% à 10%, stimulé par des primes importantes et des besoins accrus en capacité pour les puces d’IA, selon TrendForce.

On s’attend à ce que les puces HBM représentent plus de 20% de la valeur totale du marché de la DRAM à partir de 2024, et potentiellement dépassent les 30% d’ici 2025, selon Avril Wu, vice-présidente senior de la recherche chez TrendForce. « Tous les fournisseurs principaux n’ont pas passé les qualifications des clients pour [le HBM de haute performance], ce qui conduit les acheteurs à accepter des prix plus élevés pour sécuriser des approvisionnements stables et de qualité ».

L’importance de la mémoire à large bande passante

Selon Lee, sans les puces HBM, le système de mémoire du serveur d’un centre de donnéesUn centre de données ou centre de traitement de données (CTD) … ne pourrait pas suivre le rythme d’un processeur à haute performance, comme un GPU. Les HBM fournissent aux GPU les données qu’ils traitent. « Quiconque achète un GPU pour le calcul d’IA aura également besoin d’une mémoire à large bande passante ».

« En d’autres termes, les GPU à haute performance seraient sous-utilisés et, souvent, resteraient inactifs en attendant les transferts de données. La forte demande de puces mémoire SK Hynix est due à la forte demande pour les puces GPU de Nvidia et, dans une moindre mesure, à la demande pour des puces d’IA alternatives, comme celles d’AMD, Intel et d’autres », explique Lee.

Gaurav Gupta, analyste chez Gartner, ajoute que le HBM est relativement nouveau et gagne un élan fort en raison de ce qu’il offre : plus de bande passante et de capacité. « C’est différent de ce que vendent Nvidia et Intel. À l’exception de SK Hynix, la situation pour le HBM est similaire pour les autres fabricants de mémoire. Pour Nvidia, il existe des contraintes plus liées à la capacité de conditionner leurs puces avec les fonderies ».

Perspectives futures

Alors que SK Hynix atteint ses limites de fourniture, Samsung et Micron augmentent la production de HBM et devraient pouvoir répondre à la demande à mesure que le marché devient plus distribué, selon Lee. La pénurie actuelle de HBM est principalement due au conditionnement chez TSMC (c’est-à-dire la technologie Chip-on-Wafer-on-Substrate ou CoWoS), qui est le fournisseur exclusif de la technologie. Lee note que TSMC est en train de plus que doubler sa capacité SOIC et d’augmenter la capacité pour le CoWoS de plus de 60%. « Je m’attends à ce que la pénurie diminue vers la fin de cette année ».

En même temps, plus de fournisseurs de conditionnement et de fonderie se joignent et qualifient leur technologie pour soutenir NVIDIA, AMD, Broadcom, Amazon et d’autres qui utilisent la technologie de conditionnement de puces de TSMC, selon Lee.

On s’attend à ce que Nvidia, dont la production représente environ 70% de l’approvisionnement mondial en puces pour serveurs IA, génère 40 milliards de dollars de revenus grâce aux ventes de GPU cette année, selon des analystes de Bloomberg. En comparaison, on s’attend à ce qu’Intel et AMD génèrent respectivement 500 millions de dollars et 3,5 milliards de dollars. Mais tous les trois augmentent la production aussi rapidement que possible.

La réponse de l’industrie

Selon TrendForce, Nvidia aborde la pénurie de GPU en augmentant ses capacités de production de CoWoS et de HBM. « On s’attend à ce que cette approche proactive réduise de moitié le temps de livraison moyen actuel de 40 semaines pour le deuxième trimestre [de 2024], à mesure que de nouvelles capacités commencent à être en ligne », indique le rapport TrendForce.

Shane Rau, vice-président de la recherche sur les semi-conducteurs informatiques chez IDC, commente que, bien que la demande en capacité de puces d’IA soit très élevée, les marchés s’adaptent. « Dans le cas des GPU de type serveur, l’offre en plaquettes, conditionnement et mémoires est en augmentation. L’augmentation de l’offre est clé car, en raison de leur performance et de leur programmabilité, les GPU de classe serveur resteront la plateforme de choix pour entraîner et exécuter de grands modèles d’IA ».

On s’attend à ce que les dépenses mondiales en puces centrées sur l’IA atteignent 53 milliards de dollars cette année et qu’elles plus que doublent au cours des quatre prochaines années, selon Gartner. Les fabricants de puces lancent de nouveaux processeurs aussi rapidement qu’ils le peuvent.

Intel a annoncé ses plans pour des puces destinées à alimenter les fonctions d’IA avec ses processeurs Gaudi 3 et Xeon 6. Pendant ce temps, AMD a mis en avant son GPU MI300 pour les charges de travail de centres de données d’IA, qui a également une bonne traction sur le marché. En outre, plus de 80 fournisseurs de semi-conducteurs développent des puces spécialisées pour l’IA.

Du côté logiciel, les créateurs de LLM développent des modèles plus petits conçus pour des tâches spécifiques, ce qui nécessite moins de ressources de traitement. La stratégie d’Intel vise également à permettre l’IA générative sur tout type de dispositif informatique, des ordinateurs portables aux smartphones.

Toutefois, sans les HBM, ces processeurs auraient probablement du mal à suivre les exigences de performance élevée de l’IA générative.