Lorsque quelqu’un évoque une “perte de mémoire”, il fait généralement référence à la RAM. Cependant, la mémoire d’un système moderne constitue un véritable écosystème : plusieurs technologies distinctes, empilées en une hiérarchie pour équilibrer vitesse, coût, consommation et pérennité. La raison en est simple : il n’existe pas une mémoire qui soit à la fois ultrarapide, bon marché, volumineuse et capable de conserver les données sans énergie.

Cette “couche de mémoires” permet à une CPU de ne pas passer une moitié de journée à attendre des données (le fameux memory wall), à un serveur de traiter des milliers de requêtes web sans goulot d’étranglement, ou à votre portable de démarrer toujours avec le firmware approprié, même en cas de batterie déchargée.

Voici une explication claire (et utile) pour comprendre les quatre grandes familles de mémoire que l’on retrouve constamment dans les PC, mobiles et centres de données : ROM, DRAM, SRAM et mémoire flash.

1) La première distinction : volatile vs non volatile

La division essentielle est la suivante :

- Mémoire volatile : nécessite de l’énergie pour conserver les données. En éteignant, elles s’effacent. Voici où résident DRAM et SRAM.

- Mémoire non volatile : garde les données sans alimentation électrique. On trouve ici ROM (dans un sens large) et flash.

En tenant compte de cela, il devient évident pourquoi un système d’exploitation se charge depuis un SSD (flash) vers la RAM (DRAM), et pourquoi la CPU possède des caches ultrarapides (SRAM).

2) La ROM : mémoire de “démarrage” et sa famille de variantes

La ROM était à l’origine une “mémoire en lecture seule”, mais aujourd’hui, le terme est utilisé plus largement pour désigner le firmware et le stockage non volatile de bas niveau : BIOS/UEFI, microcode, pilotes intégrés, etc.

Dans cette famille, certains types se distinguent traditionnellement :

- Mask ROM : programmé en fabrication, inaltérable.

- PROM : programmable une seule fois.

- EPROM : effaçable via lumière ultraviolette (la fameuse “fenêtre”).

- EEPROM : effaçable et reprogrammable électriquement (souvent par octets), largement utilisée pour configurations et microprogrammes.

Dans la pratique, une grande partie du microcode moderne ou du firmware résident dans des mémoires flash spécialisées, mais le principe demeure : un stockage non volatile fiable pour démarrer et gérer le système.

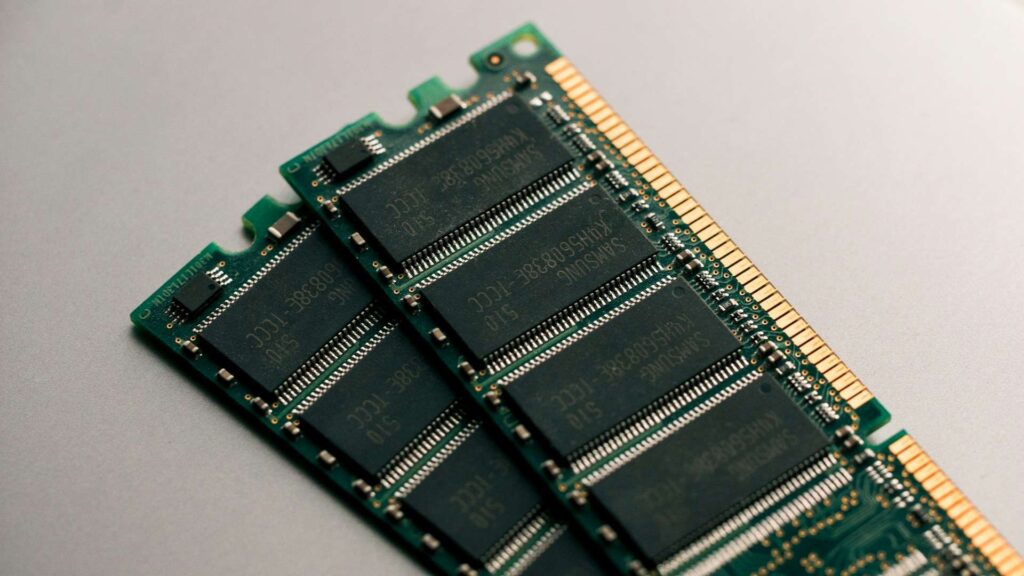

3) La DRAM : la RAM “de vrai” (et pourquoi elle doit être rafraîchie)

La DRAM (Dynamic RAM) est la reine de la mémoire principale des PC, serveurs et multiples appareils. Son astuce consiste à stocker chaque bit dans une combinaison très compacte de condensateur + transistor. Elle est ainsi relativement bon marché par gigaoctet… mais avec un inconvénient : le condensateur se décharge avec le temps, nécessitant un rafraîchissement régulier.

DDR, LPDDR, GDDR, HBM : mêmes bases, usages divergents

En pratique, presque toute la DRAM moderne est SDRAM (actualisée par la synchronisation d’horloge), déclinée selon l’utilisation :

- DDR : la RAM classique pour PC de bureau/serveurs (DIMMs).

- LPDDR : optimisée pour faible consommation (ordinateurs portables légers, mobiles, souvent soudée).

- GDDR : dédiée aux GPU (forte largeur de bande, consommation et chaleur élevés).

- HBM : DRAM empilée (2.5D/3D) pour un bandepassage extrême dans l’IA et le HPC.

L’importance des “timings”

Les chiffres tels que CL30 ou 30-36-36-76 indiquent des latences mesurées en cycles d’horloge : combien de temps la DRAM met à ouvrir une ligne, accéder à une colonne, ou fournir des données. C’est pourquoi deux kits avec “beaucoup de MHz” peuvent avoir des performances différentes selon leur latence effective.

4) SRAM : très chère, petite… mais essentielle

La SRAM (Static RAM) n’utilise pas de condensateurs : elle emploie des cellules bistables (généralement 6 transistors par bit) qui maintiennent leur état tant qu’il y a alimentation, sans besoin de rafraîchissement. Résultat : latence très faible et comportement très prévisible.

Pourquoi ne possède-t-on pas 512 Go de SRAM ? Parce qu’elle est extrêmement coûteuse et peu compacte. Son rôle naturel est plutôt :

- Cache L1/L2/L3 des CPU et GPU

- Buffers haute performance

- Équipements réseau et systèmes où la déterminisme prime

Dans la pratique, ces caches représentent une part considérable de la “sensations de vitesse” : elles évitent des accès fréquents à la DRAM, améliorant considérablement la réactivité globale.

5) La mémoire flash : le stockage moderne (SSD, mobile, USB) et ses deux visages : NOR et NAND

La mémoire flash est non volatile et domine le stockage contemporain : SSD, mobiles, cartes SD. Elle repose sur des transistors à porte flottante (ou technologies apparentées) qui retiennent la charge pour représenter un bit.

Historiquement, l’invention de la mémoire flash est attribuée à Fujio Masuoka (Toshiba) dans les années 80, constituant une étape clé permettant au stockage solide d’évoluer en capacité et en coût.

NOR vs NAND

- NOR flash : privilégie l’accès aléatoire et permet, dans certains cas, le execute-in-place (exécuter le code directement à partir de la mémoire), utilisé en firmware et systèmes intégrés.

- NAND flash : favorise la densité et les opérations par pages/bloques ; c’est la base des SSD et du stockage de masse actuel. Elle nécessite des contrôleurs avec ECC, wear leveling, gestion des blocs défectueux, etc.

SLC, MLC, TLC, QLC : pourquoi votre SSD “se dégrade”

Dans la mémoire NAND, chaque cellule peut stocker 1, 2, 3 ou 4 bits (SLC/MLC/TLC/QLC). Plus il y a de bits par cellule, plus la capacité et le coût diminuent… mais cela s’accompagne d’une moindre endurance et d’un débit réduit, ainsi que d’une complexité accrue du contrôleur.

6) Tout cela, qu’est-ce que ça a à voir avec un serveur (et WordPress)

Même si WordPress repose “simplement” sur PHP et MySQL, la physique de la matériel est déterminante :

- SRAM (caches) : si le modèle d’accès est optimal, la CPU travaille “près” du stockage et répond rapidement.

- DRAM (RAM du serveur) : abrite caches d’objets, buffers système, données actives de bases ; une RAM insuffisante entraîne un épisode d’IO intense.

- Flash (NVMe/SSD) : rapide mais pas équivalent à la RAM ; une écriture intensive ou un SSD saturé peut provoquer une chute du débit soutenu, avec des pics de latence.

- ROM / firmware : souvent invisible… jusqu’à ce qu’un problème survienne (microcode, compatibilités, démarrage, patchs).

Comprendre cette hiérarchie facilite le diagnostic : tout ne peut pas se résoudre “en mettant plus de RAM” si la limitation provient du stockage, des caches, de la latence ou des schémas d’accès.

Questions fréquentes

Quelle mémoire rend un PC “vitesse” : RAM ou SSD ?

Les deux, mais pour des usages différents : le SSD accélère le chargement et l’accès aux données persistantes ; la RAM accélère le traitement actif du système. La sensation de fluidité dépend beaucoup d’une RAM suffisante et d’un bon débit soutenu du SSD.

Pourquoi la DRAM doit-elle être rafraîchie alors que la SRAM non ?

Parce que la DRAM stocke des bits sous forme de charges dans des condensateurs qui fuient ; la SRAM utilise un circuit bistable qui maintient l’état tant qu’il y a de l’énergie, sans besoin de rafraîchir.

Quel est le meilleur stockage : TLC ou QLC ?

Cela dépend de l’usage. Pour une lecture majoritaire à faible coût, QLC peut suffire. Pour des écritures intensives et une performance soutenue, TLC (ou des solutions avec un meilleur overprovisioning et contrôleur) est généralement plus fiable.

La ROM existe-t-elle encore si tout devient “upgradable” ?

Oui, le microcode et le démarrage requièrent toujours une mémoire non volatile fiable. Ce qui a changé, c’est que la majorité de cette “ROM” moderne est réinscriptible (EEPROM/flash), mais sa fonction principale demeure.

source : wccftech