Un rapport publié par l’Institut Avancé de Science et Technologie de Corée (KAIST) et le laboratoire TERA révèle que l’**essor fulgurant de l’intelligence artificielle (IA) et le développement de nouvelles générations de mémoire HBM (High Bandwidth Memory) mettent à l’épreuve la consommation énergétique des GPU dédiés à l’IA**. Ce document prévoit une augmentation sans précédent des besoins énergétiques des systèmes de calcul haute performance.

HBM : la course vers des mémoires ultra-rapides et à grande capacité

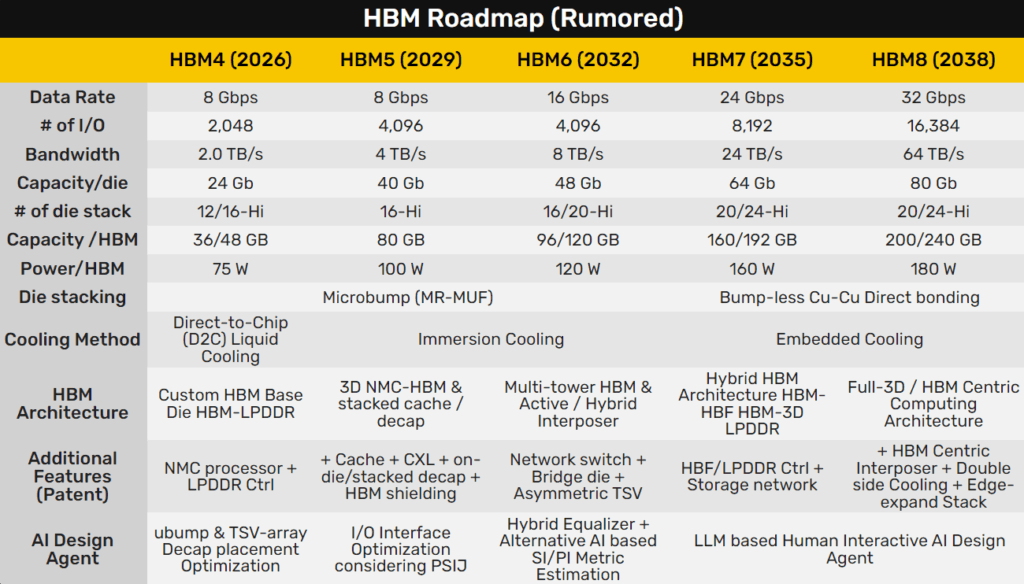

Actuellement, la technologie HBM3E permet à des accélérateurs comme la NVIDIA B300 et l’AMD MI350 d’atteindre des capacités allant jusqu’à 288 Go de mémoire haute bande passante. La prochaine génération, HBM4, fera passer la capacité à 384 Go pour NVIDIA (série Rubin) et jusqu’à 432 Go pour AMD (série MI400), avec des lancements prévus pour l’année prochaine.

La véritable révolution est attendue avec HBM5, HBM6 et HBM7, dont les projections estiment des capacités maximales astronomiques : HBM5 pourrait atteindre 500 Go, HBM6 entre 1,5 et 1,9 To, et HBM7 jusqu’à 6 To par accélérateur. Un bond qualitatif significatif pour les applications d’IA générative, le big data et la simulation scientifique.

GPU de prochaine génération : vers 15 000 W par carte

Le rapport souligne la spectaculaire augmentation de la consommation énergétique des GPU pour l’IA. Par exemple, la future GPU NVIDIA Rubin — prévue pour 2026 — sera dotée d’une consommation de puce de 800 W, et la carte complète, avec HBM4 et double puce intégrée, atteindra 2 200 W. Les actuelles AMD MI350 frôlent déjà les 1 400 W dans des systèmes de refroidissement liquide.

À moyen terme, la GPU NVIDIA Feynman (attendue pour 2029) pourrait atteindre 900 W de consommation dans le cœur et 4 400 W pour la carte complète, en utilisant quatre puces et HBM5 pour offrir une bande passante de 48 To/s.

Les projections pour la décennie vont encore plus haut : en 2032, un accélérateur basé sur 4 puces avec HBM6 pourrait frôler les 6 000 W, tandis qu’en 2035, une hypothétique carte de 8 puces, 32 modules de HBM7 et plus de 1 To/s de bande passante pourrait dépasser les **15 000 W**.

Un défi énergétique pour les centres de données

La croissance exponentielle de la consommation énergétique des GPU pour l’IA pose un défi sérieux pour les centres de données, qui pourraient avoir besoin d’infrastructures énergétiques propres, comme des centrales nucléaires ou des énergies renouvelables dédiées, pour alimenter ces systèmes. La consommation d’une seule carte de 15 000 W équivaut à celle d’un foyer moyen espagnol sur plusieurs jours.

Selon les experts, si la tendance ne se modère pas grâce à des innovations en matière d’efficacité et d’architecture, le modèle de croissance actuel pourrait devenir insoutenable, tant du point de vue environnemental qu’économique.

Cet avenir est-il viable ?

Le rapport se termine par une réflexion : « Si l’évolution technologique continue dans cette voie, chaque centre de données aura besoin de sa propre centrale électrique ». L’industrie doit relever le défi d’équilibrer la puissance brute demandée par l’IA avec l’efficacité énergétique et la durabilité, des éléments clés pour l’avenir numérique.

Source : MyDrivers, KAIST, TERA Lab, Fast Technology, NVIDIA, AMD