Kioxia annonce une mise à jour majeure de son logiciel AiSAQ pour optimiser la recherche vectorielle

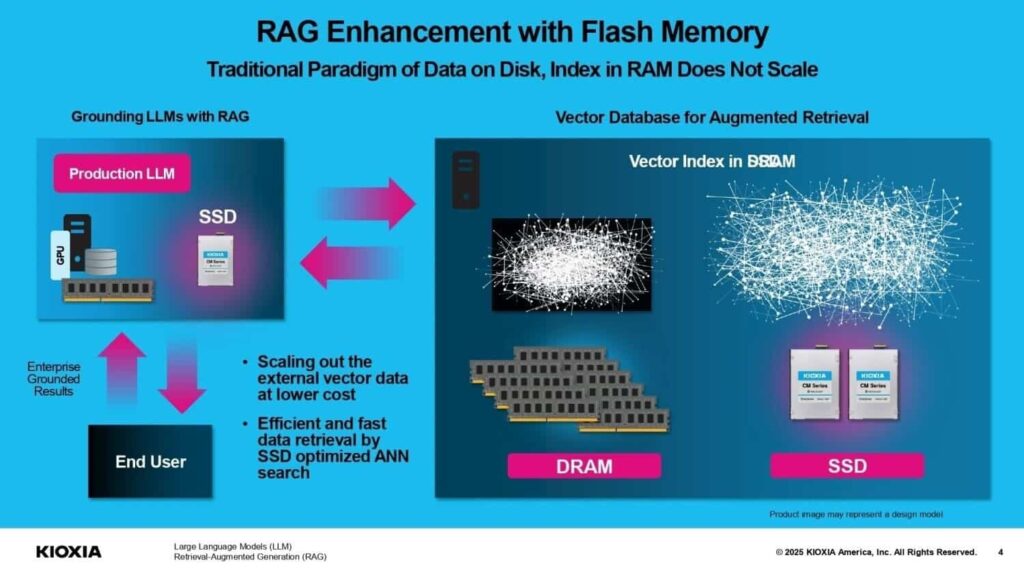

Kioxia Corporation, un leader mondial des solutions de mémoire, a dévoilé une importante mise à jour de son logiciel open source AiSAQ (All-in-Storage ANNS with Product Quantization). Cette nouvelle version vise à améliorer les performances de recherche vectorielle dans les systèmes de récupération augmentée par génération (RAG), en optimisant l’utilisation des capacités des disques SSD sans recourir à la mémoire DRAM.

La mise à jour d’AiSAQ introduit des contrôles configurables, permettant aux architectes système de définir un équilibre optimal entre le nombre de vecteurs stockables et le rendement de recherche (requêtes par seconde). Les utilisateurs peuvent ainsi adapter le système en fonction des besoins spécifiques de chaque charge de travail, sans nécessiter de modifications matérielles.

Un focus sur les SSD pour les recherches vectorielles

AiSAQ, présenté initialement en janvier 2025, utilise un algorithme optimisé pour les SSD, dérivé de la technologie DiskANN de Microsoft. Contrairement aux systèmes traditionnels qui chargent de vastes indices vectoriels en DRAM, AiSAQ autorise les recherches directement à partir du stockage, permettant une échelle plus efficace sans dépendre de la mémoire limitée du système hôte.

« Lorsqu’un SSD a une capacité fixe, améliorer le rendement de recherche implique de stocker moins de vecteurs, tandis que le stockage d’un plus grand nombre de vecteurs peut réduire le rendement », expliquent les représentants de Kioxia. Cette nouvelle version donne aux administrateurs la possibilité d’ajuster précisément le système, établissant l’équilibre adéquat entre performance et volume de données vectorielles, une exigence essentielle pour les applications telles que RAG, la recherche sémantique hors ligne ou les systèmes de recommandation.

Innovations clés du nouvel AiSAQ-DiskANN

Parmi les principales innovations du logiciel figurent :

- Recherche évolutive sans DRAM : les vecteurs Product Quantization (PQ) sont lus depuis le disque à la demande.

- Vecteurs PQ en ligne : intégrés dans le nœud de l’indice pour réduire les opérations d’E/S.

- Réorganisation optimisée des vecteurs : minimisant l’accès au disque lors des recherches.

- Points d’entrée multiples : permettant plusieurs accès à l’indice pour réduire le nombre d’itérations.

- Largeur du faisceau vectoriel : permettant la parallélisation des opérations de recherche par ajustement du nombre de nœuds par itération.

- Cache statique et dynamique de vecteurs PQ : accélérant l’accès grâce aux politiques LRU par thread.

Ces améliorations font d’AiSAQ une solution robuste et scalable pour des recherches vectorielles intensives, en particulier dans des environnements d’intelligence artificielle générative où l’efficacité d’espace de stockage et de latence est cruciale.

AiSAQ dans l’écosystème open source

Kioxia a publié le logiciel en open source sur GitHub (aisaq-diskann), facilitant son utilisation et sa contribution par la communauté. Le code repose sur l’algorithme DiskANN de Microsoft, largement utilisé dans des environnements nécessitant des recherches vectorielles rapides et évolutives.

Pour fonctionner, AiSAQ nécessite l’utilisation de liburing pour des lectures asynchrones sur des systèmes Linux, ainsi que l’installation de bibliothèques telles qu’Intel MKL pour une compilation optimisée. Des versions pour Windows, compatibles avec Visual Studio 2017 et ultérieures, sont également proposées.

Un pas de plus vers une IA scalable et durable

Avec la croissance rapide des modèles de langage génératif et des architectures comme RAG, le volume de données vectorielles devient un goulet d’étranglement pour de nombreuses organisations. L’approche de Kioxia, centrée sur les SSD, rompt avec la dépendance à la DRAM et permet de concevoir des systèmes plus scalables, durables et rentables pour la prochaine génération d’applications d’intelligence artificielle.

Cette évolution renforce l’engagement de Kioxia à faire progresser les solutions de stockage intelligent et à promouvoir des infrastructures efficientes pour l’ère de l’IA, où l’intégration entre matériel et logiciel est essentielle pour évoluer sans sacrifier la performance.

Émulation de SSD dans Proxmox : ce qui change vraiment et comment profiter de TRIM et de l’I/O dans vos VM