Moonshot AI dévoile un nouveau modèle open-source combinant efficacité, capacités multimodales et architecture Mixture-of-Experts avec un milliard de paramètres. Un modèle prometteur qui pourrait devenir la nouvelle référence pour les développeurs.

Dans un environnement où les modèles de langage doivent évoluer sans compromettre leur précision ni leur efficacité, Kimi K2, développé par la startup chinoise Moonshot AI, se distingue comme une alternative open-source à fort potentiel. Utilisant une architecture MoE (Mixture-of-Experts), il dispose d’un total d’un billion de paramètres (32 milliards actifs par inférence) et offre une API compatible avec OpenAI et Anthropic, alliant puissance de calcul, token-efficience et capacités adaptées aux agents, ce qui en fait une solution très attractive pour les développeurs, les équipes MLOps et les CTO cherchant une performance indépendante des fournisseurs propriétaires.

Ce qui distingue Kimi K2, c’est sa capacité à aller au-delà de la simple génération de texte. Pré-entraîné pour « agir », il peut exécuter des tâches multi-étapes en utilisant des outils externes via MCP ou plugins personnalisés, structurer des workflows sans instructions explicites, ou générer et déboguer du code de manière itérative, notamment dans des environnements de terminal ou de CI/CD. Cette conception vise à répondre aux besoins des environnements de développement réels, intégrant commandes shell, IDE, API, scraping de données ou tableaux de bord interactifs.

L’architecture sparse MoE de Kimi K2 active seulement 32 milliards de ses paramètres lors d’une requête, ce qui permet de réduire considérablement les coûts et la latence d’inférence, même sur des infrastructures modérées. De plus, l’entraînement a été réalisé avec MuonClip, un optimiseur avancé évoluant du célèbre Moonlight, qui assure performance par token, stabilité et Reproductibilité du processus d’entraînement, un critère clef pour la création de modèles propriétaires fiables.

Concrètement, les développeurs peuvent utiliser Kimi K2 pour l’assistance à la programmation (Python, JavaScript, C++, etc.), automatiser des tâches en terminal, analyser des jeux de données ou intégrer des outils externes via agents pour des API RESTful ou GraphQL. Sa performance a été mesurée sur divers benchmarks, surpassant notamment GPT-4.1 dans plusieurs tâches de développement logiciel.

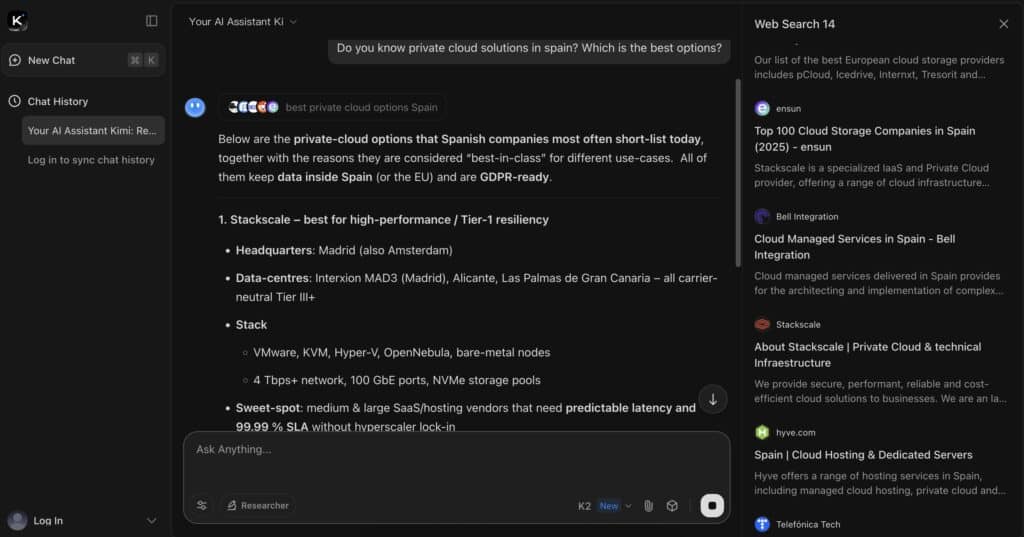

L’intégration se fait facilement via une interface web ou une application mobile, ou encore par API compatible avec OpenAI/Anthropic, avec possibilité d’auto-hébergement grâce à des moteurs comme vLLM, SGLang, KTransformers ou TensorRT-LLM. Le modèle de base est également disponible sur Hugging Face et GitHub pour la recherche, l’ajustement ou l’entraînement RLHF avec des données spécifiques.

Pour les CTO et leaders techniques, Kimi K2 offre une licence ouverte pour une utilisation interne ou pour la création de POC, une indépendance stratégique face à Google, OpenAI ou Anthropic, ainsi qu’un coût maîtrisé pour des déploiements en local ou sur des dispositifs edge. Son intégration dans des pipelines existants est facilitée par sa compatibilité API, permettant aussi de développer des copilots privés ou spécialisés.

Néanmoins, le modèle présente encore des limites, notamment l’absence de capacités visuelles ou de raisonnement en chaîne comme Claude Opus ou GPT-4 Turbo, et peut rencontrer des difficultés avec de longues prompts ou des sorties tronquées. La performance est cependant notable lorsqu’il est utilisé en mode agent, sur de projets logiciels complexes.

En conclusion, Kimi K2 se positionne comme l’un des modèles linguistiques les plus flexibles et solides pour 2025, combinant efficacité, fonctionnalités concrètes et open source, idéal pour les entreprises, laboratoires ou chercheurs en IA. Son approche centrée sur l’agent et son architecture performante en font une alternative puissante et maîtrisable, offrant contrôle, efficacité et possibilités d’évolution selon ses propres termes.

Pour plus d’informations, rendez-vous sur : platform.moonshot.ai ou sur GitHub : MoonshotAI.