Le débat s’intensifie dans le secteur : alors que l’intelligence artificielle passe d’une phase d’entraînement massif des modèles fondamentaux à une étape d’inférence à grande échelle, a-t-on encore du sens de continuer à saturer les centres de données avec des GPU ou est-il temps d’adopter des ASIC et des TPU conçus sur mesure ?

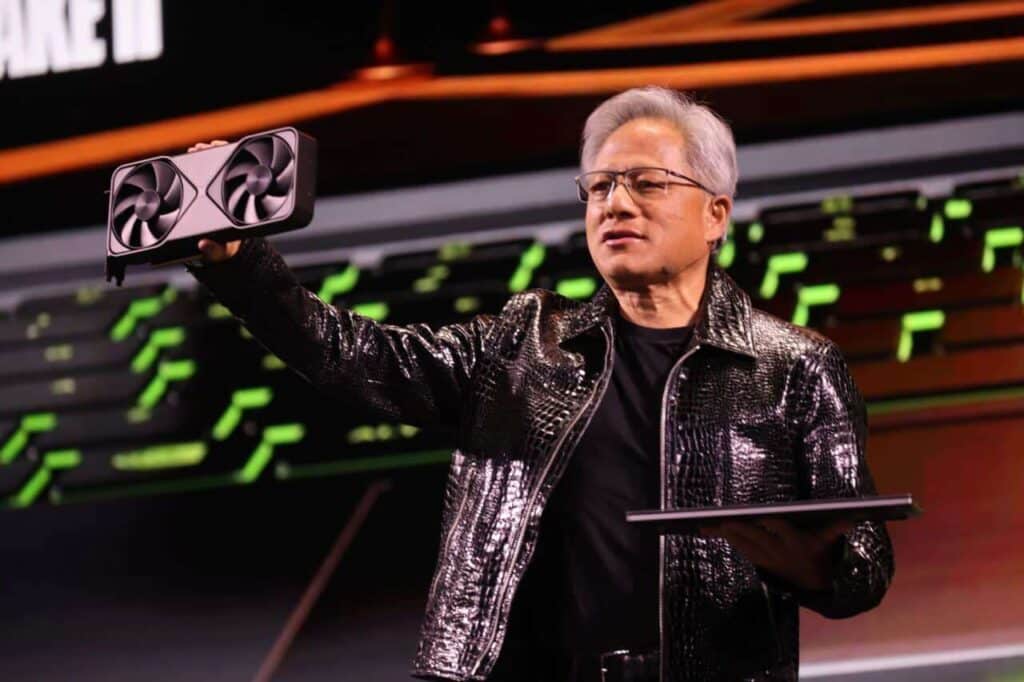

Pour Jensen Huang, PDG de NVIDIA, la réponse est claire. Lors d’une récente séance avec des analystes, il a réaffirmé que la véritable compétition en IA ne se joue pas entre entreprises, mais entre équipes d’ingénieurs, et que très peu dans le monde sont capables de suivre le rythme effréné d’innovation de sa société. Dans ce contexte, il a minimisé l’essor des ASIC (circuits intégrés spécifiques) et des TPU de géants comme Google, qui sont souvent perçus comme des alternatives aux GPU généralistes.

GPU versus ASIC/TPU : deux approches radicalement différentes pour le calcul en IA

Avant d’aborder le discours de Huang, il est utile de clarifier ce qui est en jeu. Dans les grands centres de données spécialisés en IA cohabitent, ou aspirent à le faire, deux familles de puces :

- GPU (Graphics Processing Unit) :

- Originellement conçus pour le traitement graphique, ils sont devenus le standard incontournable pour le deep learning.

- Il s’agit de puces à haut degré de parallélisme général, flexibles et programmables.

- Chez NVIDIA, elles sont accompagnées de l’écosystème CUDA, comprenant bibliothèques, compilateurs et outils optimisés pour l’IA.

- ASICs / TPU (Circuit intégré spécifique / Tensor Processing Unit) :

- Puces conçues sur mesure pour des tâches très précises, comme la multiplication et l’accumulation de tenseurs pour les réseaux neuronaux.

- Ciblant une efficacité énergétique maximale et un coût par opération réduit pour des modèles et charges spécifiques, notamment en inférence à grande échelle.

- Exemple emblématique : les TPU de Google, utilisés dans leurs services et proposés à leurs clients via leur cloud.

Tableau comparatif simplifié : GPU vs ASIC/TPU pour l’IA

| Caractéristique | GPU (ex. NVIDIA) | ASIC / TPU (ex. Google TPU) |

|---|---|---|

| Type de puce | Propósito général, haut degré de parallélisme | Spécifique à certaines opérations d’IA |

| Flexibilité | Très élevée (entraînement, inférence, autres) | Moyenne / Faible (optimisé pour cas précis) |

| Écosystème logiciel | Très mature (CUDA, cuDNN, TensorRT, etc.) | Limité aux plateformes contrôlées |

| Simplicité d’adoption | Élevée : grande communauté, support multi-cloud | Plus complexe : nécessite adaptation outils et modèles |

| Efficacité en inférence massive | Très bonne, s’améliorant continuellement | Excellente dans des scénarios bien adaptés |

| Risque de verrouillage (« lock-in ») | Moins élevé, disponible via plusieurs fournisseurs | |

| Rythme d’innovation | Continu, avec des familles annuelles de GPU |

Ce que dit vraiment Jensen Huang

Au dernier trimestre, NVIDIA a renforcé ses positions avec des résultats record dans ses activités de centres de données et des accords avec des acteurs clés de l’écosystème IA. Lorsqu’un analyste a demandé à Jensen Huang l’impact des programmes de puces dédiées — TPUs et autres ASIC — de sociétés comme Google ou Amazon, l’exécutif a répondu en soulignant une idée centrale :

On ne compete pas contre des entreprises, mais contre des équipes. Et peu d’équipes dans le monde sont capables de construire des choses aussi incroyablement complexes.

Ce nuance est importante. Huang ne nie pas l’existence ni l’utilité des ASIC tels que les TPU ; ce qu’il remet en question, c’est le fait qu’il y ait assez d’équipes capables de soutenir, version après version, tout ce que NVIDIA offre déjà :

- Un hardware optimisé pour l’IA dans plusieurs segments (entraînement, inférence, calcul scientifique).

- Un écosystème logiciel unifié : CUDA et un ensemble de bibliothèques, frameworks et outils qui sont devenus la norme de facto.

- Un support massif de la part de la communauté de développeurs, startups, universités et fournisseurs cloud.

En définitive, son message est que ratio technique égal ne suffit pas ; il faut aussi pouvoir proposer une plateforme intégrale.

L’exemple d’Anthropic : GPU et TPU cohabitent

Le cas d’Anthropic illustre parfaitement cette coexistence. La société a signé des accords à la fois avec NVIDIA, qui lui fournit des systèmes basés sur des architectures comme Blackwell ou Rubin, et avec Google, qui propose ses TPU de dernière génération (Ironwood) pour certaines charges spécifiques.

Aux yeux de certains analystes, cette combinaison pourrait être perçue comme un signe que les GPU sont voués à disparaître. Huang, cependant, présente la situation inverse :

- Les grandes entreprises en IA diversifient leur hardware pour optimiser coûts et performances selon la tâche.

- Mais pour de nombreuses charges critiques, notamment l’entraînement à grande échelle et les pipelines complexes, elles continuent d’utiliser l’écosystème NVIDIA.

Cela signifie que l’émergence des ASICs ne remplace pas les GPU, mais s’inscrit plutôt dans un paysage plus hétérogène où chaque type de puce occupe un créneau spécifique.

Les avantages des GPU : flexibilité et écosystème robuste

Pourquoi les centres de données continuent-ils d’acheter des GPU à un rythme si soutenu, même face à des ASICs plus efficaces pour certaines tâches ?

- Flexibilité extrême

Une GPU moderne ne se limite pas à l’inférence de modèles entraînés : elle permet aussi de :- Former de nouveaux modèles fondamentaux.

- Faire du fine-tuning pour des cas d’usage spécifiques.

- Réaliser des simulations, du calcul haute performance, du rendu graphique avancé, etc.

- Écosystème CUDA consolidé

La majorité des frameworks de deep learning (PyTorch, TensorFlow, JAX, etc.) proposent un soutien mature et optimisé pour les GPU NVIDIA.

Transférer tout cela vers un ASIC spécifique est possible, mais très coûteux en termes de temps, compétences et maintenance. - Portabilité entre fournisseurs

Les GPU NVIDIA sont disponibles auprès de multiples fournisseurs cloud et hébergeurs, permettant aux entreprises et laboratoires d’éviter le verrouillage total à une plateforme propriétaire. - Rythme d’innovation soutenu

Chaque nouvelle génération de GPU amène des améliorations en performance par watt, mémoire, bande passante et support d’instructions nouvelles pour l’IA. Reproduire ce rythme dans un ASIC interne n’est pas trivial.

Les forces des ASIC et TPU : efficacité et contrôle à l’échelle

Cela dit, ASIC et TPU ne sont pas du marketing creux. Ils présentent des avantages clairs dans certains environnements :

- Volume massif d’inférences répétitives

Pour des services globaux traitant des milliards de requêtes quotidiennes avec des modèles relativement stables, un ASIC bien conçu peut fournir un coût par inférence nettement inférieur à celui d’un GPU. - Contrôle total de la stack

Quand une entreprise gère l’intégralité du hardware, middleware et logiciels, comme Google avec ses TPU, elle peut exploiter la plateforme au maximum et l’adapter parfaitement à ses produits (recherches, publicité, vidéo, etc.). - Optimisation énergétique extrême

Dans des centres de données où le défi n’est pas seulement financier, mais aussi lié à l’énergie disponible et la capacité de refroidissement, un ASIC très optimisé peut faire la différence.

En résumé : les TPU et autres ASIC ont tout leur sens pour des hyperscalaires capables d’investir des milliards en silicium propre et ayant des charges de travail très prévisibles. Pour la majorité des entreprises, en revanche, les GPU restent la solution la plus pragmatique.

Menace réelle ou simple bruit concurrentiel ?

Les déclarations de Jensen Huang se doivent d’être comprises en plusieurs couches :

- À court terme, la demande en GPU pour l’IA reste exceptionnellement forte, et ses accords avec des acteurs comme Anthropic renforcent cette position.

- À moyen terme, les ASIC et TPU de Google, Amazon ou autres géants technologiques ne disparaissent pas, mais ont tendance à être intégrés dans des architectures hybrides où les GPU gardent un rôle central.

- À long terme, la grande inconnue n’est pas seulement la composante matérielle, mais aussi qui pourra maintenir le meilleur calibre d’ingénierie et l’écosystème logiciel le plus attractif.

Et c’est précisément là que Huang insiste : même si des ASIC performants existent, très peu d’équipes dans le monde peuvent maintenir le rythme d’innovation que NVIDIA impose dans le hardware, le software et le support à l’industrie.

Pour l’instant, la compétition GPU contre ASIC ne semble pas être une partie à somme nulle. Elle s’oriente plutôt vers un scénario hybride où chaque technologie occupe sa place… mais NVIDIA reste déterminée à rester le moteur principal autour duquel gravite la majorité de l’IA moderne.

Source : Noticias inteligencia artificial