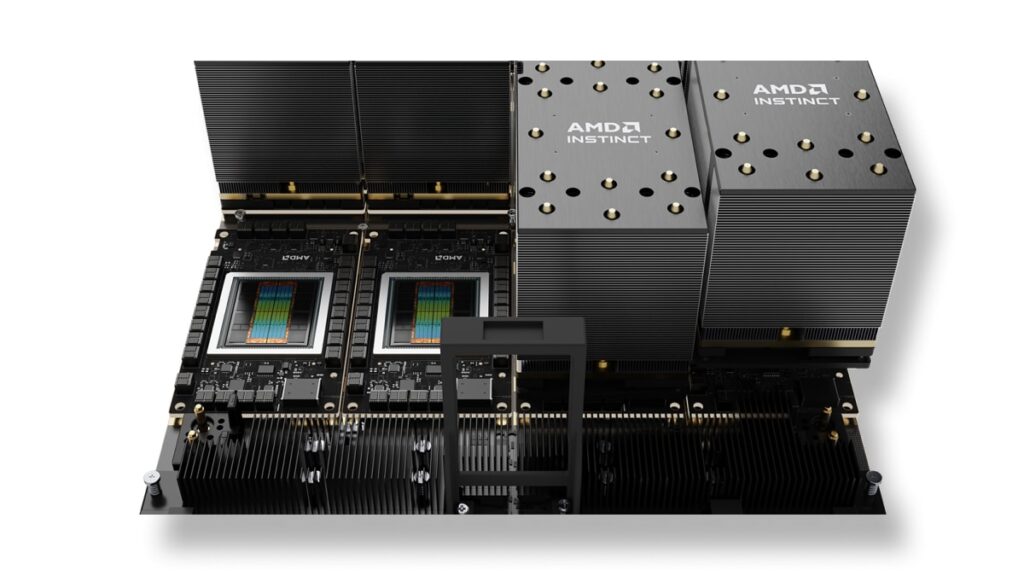

IBM et AMD ont annoncé une collaboration pour fournir à Zyphra, une start-up basée à San Francisco spécialisée dans la superintelligence open-source, une infrastructure avancée d’entraînement de modèles d’IA sur IBM Cloud, basée sur les GPU AMD Instinct™ MI300X. Ce partenariat pluriannuel positionne IBM comme fournisseur d’un gros cluster dédié avec des accélérateurs AMD, destiné à entraîner des modèles fondamentaux multimodaux (langage, vision et audio). Selon les entreprises, il s’agit du premier déploiement à grande échelle sur IBM Cloud intégrant l’ensemble de la pile AMD pour l’entraînement — du calcul au réseau — et s’appuie également sur AMD Pensando™ Pollara 400 AI NICs et AMD Pensando Ortano DPUs. La première étape a été lancée au début septembre, avec une expansion prévue en 2026.

Ce développement intervient peu après la levée de fonds de la Série A de Zyphra, valorisée à 1 milliard de dollars. La société vise à bâtir un laboratoire de recherche en science ouverte et codenature ouverte, afin de promouvoir de nouvelles architectures neuronales, une mémoire à long terme et un apprentissage continu. Son produit phare, à l’horizon, est Maia, un « superagent » généraliste conçu pour améliorer la productivité des employés du savoir en entreprise.

« C’est la première fois que la plateforme d’entraînement AMD — englobant calcul et réseau — s’intègre et se déploie à grande échelle sur IBM Cloud. Chez Zyphra, nous sommes honorés de diriger le développement de modèles de pointe utilisant l’électronique AMD, sur cette plateforme », déclare Krithik Puthalath, PDG et président de Zyphra.

Ce que comporte le pack : GPU, réseau intelligent et cloud d’entreprise

Le cluster dédié pour Zyphra combine plusieurs éléments de la pile AMD :

- GPU AMD Instinct MI300X pour l’entraînement génératif et les charges HPC associées.

- AMD Pensando Pollara 400 AI NICs (cartes réseaux intelligentes axées IA) pour alimenter un flux de données à grande échelle avec faible latence et haut débit.

- AMD Pensando Ortano DPUs (unités de traitement de données) pour délester les tâches réseau et sécurité, tout en orchestrant les services d’infrastructure sans « voler » de cycles au calcul principal.

De son côté, IBM Cloud apporte sa couche de cloud d’entreprise — sécurité, fiabilité, extensibilité et multi-cloud hybride — qui proposait déjà en 2024 le MI300X en mode service. La synergie vise un usage très précis : fermes d’entraînement dédiées, « isolées » pour des clients ayant des besoins extrêmes en calcul, tout en offrant l’élasticité et la gouvernance d’un hiper-échelle.

« Faire évoluer les charges d’IA plus rapidement et plus efficacement impacte directement le ROI, tant pour les grandes entreprises que pour les startups », souligne Alan Peacock, directeur général d’IBM Cloud. Pour AMD, cette collaboration traduit une « innovation à la vitesse et à l’échelle attendues par nos clients » — selon Philip Guido, EVP et Chief Commercial Officer — et souhaite établir un nouveau standard d’infrastructure IA, en combinant l’expérience d’IBM en cloud d’entreprise avec le leadership d’AMD en HPC et accélération IA.

Pour quoi Zyphra l’utilisera : modèles multimodaux et Maia, le « superagent »

Zyphra développera sur cette plateforme des modèles fondamentaux multimodaux intégrant langage, vision et audio. La priorité est d’alimenter Maia, ce superagent généraliste qui promet d’accélérer les processus intensifs en connaissances (recherche, analyse, rédaction, coordination) dans le contexte d’entreprise. L’objectif : que l’agent comprenne des documents, résume des appels, croise des sources internes et externes, et prenne des mesures (ou sugère le meilleur next step) dans les systèmes d’entreprise, sans obliger l’humain à changer d’application.

Le fait que Zyphra qualifie son approche d’open-source / open science n’est pas anodin : dans un marché dominé par des modèles fermés, cette transparence et cette collaboration scientifique offrent un fort attractif pour les entreprises soucieuses d’auditer ou d’adapter leurs outils en mode on-prem.

Pourquoi cette annonce est importante (au-delà de Zyphra)

- « Full-stack » AMD testé sur un hyperéchelle. Il s’agit du premier macrocluster dédié sur IBM Cloud combinant GPU + NIC + DPU AMD pour l’entraînement. Ce cas de référence démontre la capacité de déploiement d’IA à haute performance, sans compromis sur l’isolation, en mode cloud.

- Un signal pour la chaîne d’approvisionnement. La réussite des grands projets IA dépend autant du silicium que du packaging avancé et de la HBM. La coordination IBM–AMD avec un client en forte demande anticipe dès maintenant ses besoins en capacité et service pour 2026.

- Concurrence réelle face à NVIDIA. Malgré l’avantage de CUDA et d’un écosystème logiciel sans égal, NVIDIA n’est pas la seule option. La pile AMD (ROCm, libraries, kernels optimisés) gagne du terrain, notamment grâce à la co-ingénierie avec des partenaires extrêmes en calcul.

- Le cloud comme vecteur “time-to-model”. Les hiper-échelles proposant des offres « GPU as-a-service » et des contrats dédiés auront un avantage pour capter les entraînements d’avant-garde : réduction des délais, accès à des réseaux et services prêts pour la production.

Vers un « supercalcul quantique » centré sur l’innovation : la voie alternative IBM-AMD

Au-delà de cette annonce, IBM et AMD ont également indiqué leur intention d’explorer les architectures de prochaine génération dans le domaine du « supercalcul quantique » : fusionner quantiques (où IBM est leader en matériel et logiciel) avec le HPC et l’accélération IA (où AMD excelle). Bien que le calendrier précis ne soit pas détaillé, la vision est claire : orchestrer des ressources hétérogènes (classiques, accélérés et quantiques) en fonction du problème, du coût et de la fenêtre de calcul.

Ce qu’il faut suivre (et les risques potentiels)

- Logiciel : la parité fonctionnelle et le rendement de ROCm face à CUDA dans des charges réelles (performance efficace, MoE, entraînement dense, serving à faible latence) seront clés pour le TCO.

- HBM et OSAT : la mémoire à large bande passante et le packaging avancé restent sous tension ; toute extension dépendra de la gestion des commandes globales.

- Énergie et thermique : des clusters de cette taille requièrent plusieurs mégawatts et une réfrigération liquide (D2C, immersion). La localisation et le coût du kWh influencent autant que la puce elle-même.

- Networking : même si les NICs AI et DPUs soulageant en partie la charge, la topologie et les backplanes à terabits/s restent cruciales dans ces grandes architectures.

- Calendrier : l’expansion de Zyphra en 2026 dépendra d’entrées progressives de capacité, sans goulots d’étranglement.

Lecture rapide pour CTOs et équipes infrastructure

- Cas d’usage : entraînement multimodal de pointe (texte + image + audio) sur cluster dédié dans IBM Cloud.

- Technologie : MI300X + Pensando NICs/DPUs (réseau et gestion des données proche du rack), sécurité et multicloud hybride.

- Objectif : optimiser la productivité des modèles et la efficacité (moins de latence, plus de débit, meilleure PUE/TUE).

- Produit : alimenter Maia, le superagent Zyphra dédié à la collaboration et à l’automatisation en environnement professionnel.

En résumé

La collaboration entre IBM, AMD et Zyphra enrichit la cartographie de l’IA à grande échelle : un macrocluster dédié sur IBM Cloud, intégrant l’ensemble de la pile AMD (GPU, NIC, DPU), orienté modèles multimodaux de pointe, avec une croissance anticipée en 2026. Pour Zyphra, c’est le carburant nécessaire pour soutenir sa démarche open-source / open-science et transformer Maia du laboratoire à la production ; pour IBM, un cas de référence consolidant son offre GPU as-a-service ; et pour AMD, une démonstration que sa pile full-stack pour l’entraînement peut évoluer à l’échelle d’un hiperéchelle avec un SLA d’entreprise. Dans un marché où les fenêtres d’entraînement se resserrent et où la consommation électrique efficace prime, ces alliances opérationnelles deviennent la monnaie la plus précieuse.

Questions fréquentes

En quoi ce cluster est-il « différent » des autres déploiements IA dans le cloud ?

C’est le premier macrocluster dédié sur IBM Cloud qui intègre l’ensemble de la pile AMD pour l’entraînement (GPU MI300X, Pensando Pollara 400 AI NICs et Pensando Ortano DPUs), réunissant calcul et réseau intelligent avec la couche entreprise.

À quoi servira Zyphra sur cette infrastructure ?

Elle se consacrera à modèles fondamentaux multimodaux (texte, image, audio) qui alimenteront Maia, son superagent généraliste visant à améliorer la productivité en entreprise, ainsi qu’à la recherche sur nouvelles architectures, mémoire à long terme et apprentissage continu.

Pourquoi ont-ils choisi IBM et AMD ?

Pour leur feuille de route innovative et la capacité à fournir des accélérateurs à la cadence exigée par Zyphra. IBM apporte sécurité, fiabilité et scalabilité ; AMD, HPC et accélération via GPU, NICs AI et DPU.

Quel est le calendrier ?

Le premier déploiement a été opérationnel début septembre 2025 ; l’extension est planifiée pour 2026, avec une capacité susceptible de continuer à croître selon les besoins de Zyphra.

source : amd