La start-up américaine Groq, fondée en 2016, a développé une unité de traitement de langage (LPU) innovante qui promet de transformer le domaine de l’intelligence artificielle générative. Cette technologie avancée génère du contenu de manière quasi instantanée, surpassant en vitesse les GPU (unités de traitement graphique) traditionnels de Nvidia.

Une Alternative aux GPU de Nvidia

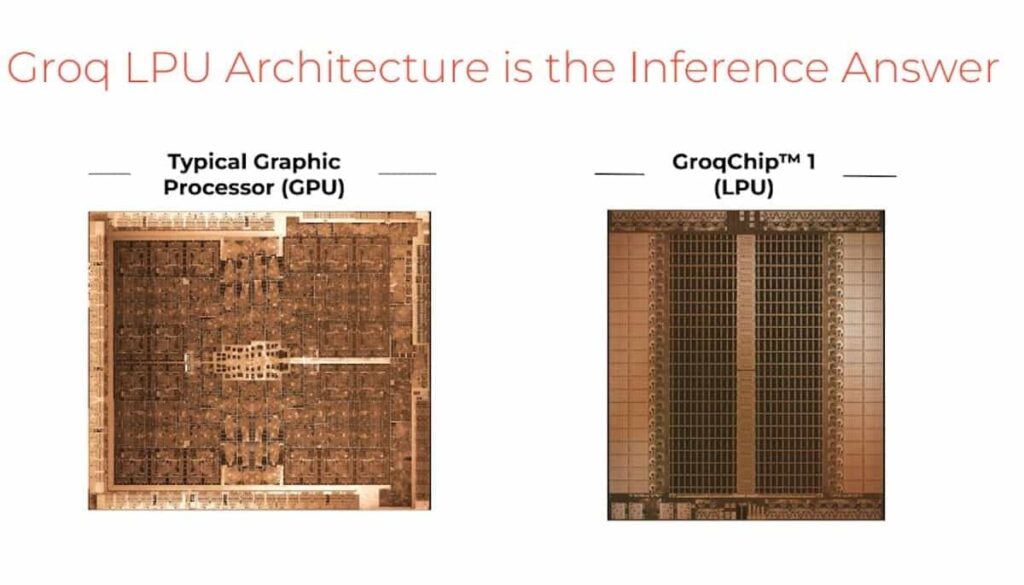

Groq a récemment été sous les feux de la rampe en raison de l’essor de l’intelligence artificielle générative. L’entreprise a créé des LPU (Language Processing Unit), des processeurs conçus spécifiquement pour l’inférence de modèles d’IA comportant des milliards de paramètres. Contrairement aux GPU, qui sont mieux adaptés à l’entraînement de modèles d’IA, les LPU de Groq sont optimisées pour l’exécution rapide et efficace de ces modèles.

Jonathan Ross, fondateur de Groq et ancien ingénieur chez Google, souligne que « sur les appareils mobiles, les gens n’ont pas de patience ». Avec les LPU de Groq, l’interaction avec l’IA vise à être quasi instantanée, supprimant la sensation de converser avec une machine.

Des Caractéristiques Techniques Impressionnantes

Les GroqChips, comme sont appelées ces LPU, sont capables de réaliser un quadrillion d’opérations par seconde, générant jusqu’à 400 mots par seconde, comparé aux 100 mots par seconde que les GPU de Nvidia peuvent gérer. Cette vitesse supérieure pourrait positionner Groq comme un leader sur le marché de l’IA générative.

Bien que les LPU de Groq atteignent une performance de 188 Tflops, considérablement moins que les 1 000 Tflops des GPU Nvidia H100, leur architecture simplifiée et leur efficacité énergétique les rendent idéales pour l’inférence de modèles de langage. Les LPU consomment nettement moins d’énergie, une carte PCIe de Groq consommant dix fois moins d’énergie qu’une carte similaire de Nvidia.

Un Design Innovant pour l’Efficacité

L’architecture des LPU de Groq ressemble à un assemblage de plusieurs mini-DSPs (processeurs de signal numérique), montés en série. Cette structure permet à chaque circuit de se spécialiser dans une fonction unique, maximisant l’efficacité énergétique et la vitesse de traitement. Cette approche modulaire et spécialisée réduit considérablement la consommation d’énergie par rapport aux GPU, qui ont été à l’origine conçus pour le traitement graphique.

Focus sur l’Inférence et l’Efficacité

Groq souligne que ses puces ne sont pas destinées à l’entraînement de modèles d’IA, mais à l’exécution de modèles déjà formés. « Nous avons développé une puce qui accélère par dix l’exécution de ces modèles. Cela signifie que lorsque vous posez une question à une IA qui fonctionne sur un serveur équipé de notre puce, vous obtenez une réponse en temps réel », explique Ross.

L’Avenir de l’Inférence avec Groq

Le moteur d’inférence Groq LPU™ est un système d’accélération d’inférence conçu pour offrir des performances, une efficacité et une précision considérables dans un design simple. Avec la capacité d’exécuter des modèles comme Llama-2 70B à plus de 300 tokens par seconde et par utilisateur, les LPU de Groq promettent d’établir une nouvelle norme dans l’expérience de l’IA.

Conclusion

Groq redéfinit la manière dont nous interagissons avec l’intelligence artificielle, en offrant une technologie qui n’est pas seulement plus rapide, mais aussi plus efficace sur le plan énergétique. Avec son focus sur l’inférence et l’exécution efficace de modèles de langage, Groq se positionne comme un concurrent redoutable dans le domaine de l’IA générative.

Pour plus d’informations sur Groq et ses LPU innovantes, visitez Groq.