Google a clôturé ses présentations sur le machine learning lors de la conférence Hot Chips en annonçant une avancée majeure : Ironwood, la nouvelle génération de ses unités de traitement tensoriel (TPU). Conçue spécifiquement pour l’inférence de modèles de langage et le raisonnement à grande échelle, cette nouvelle architecture dépasse largement ses prédécesseurs, qui se concentraient principalement sur l’entraînement.

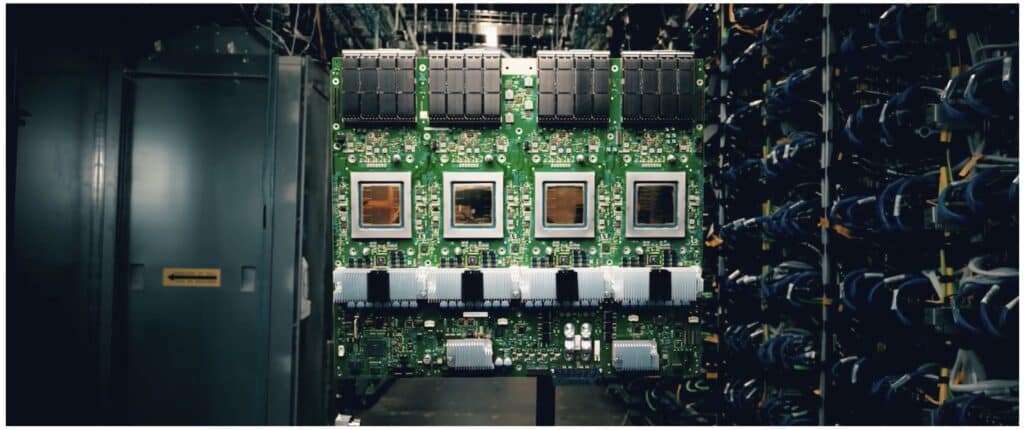

Contrairement aux générations antérieures, Ironwood a été développée pour exécuter en production de grands modèles de langage (LLMs), des architectures « mixture-of-experts » et des modèles de raisonnement, où la latence et la fiabilité sont cruciales. Elle permet notamment de faire évoluer jusqu’à 9 216 puces dans un seul nœud, atteignant une performance de 42,5 exaflops (FP8), tout en disposant de 1,77 pétaoctets de mémoire HBM3e directement adressable via des commutateurs optiques, doublant la capacité de la TPUv4.

Le design intègre également de la redondance, avec un nombre de puces supérieur à une puissance de deux pour permettre des racks de secours en cas de défaillance. En termes d’efficacité énergétique, Ironwood offre le double de performance par watt par rapport à Trillium et jusqu’à six fois l’efficacité de TPUv4, grâce à une architecture multi-chiplet, huit stacks de mémoire de 192 Go, un refroidissement liquide de troisième génération et un contrôle précis des pics de consommation électrique, favorisant la stabilité en déploiement.

La fiabilité constitue aussi une priorité, avec des fonctionnalités telles que le checkpointing automatique, la détection de corruption silencieuse des données, ainsi que la sécurité avancée intégrée, assurant un démarrage sécurisé et la prise en charge du calcul confidentiel.

Une innovation remarquable réside dans l’utilisation de l’intelligence artificielle dès la phase de conception du hardware : même la conception interne du chip a été optimisée à l’aide de l’IA, en collaboration avec le projet AlphaChip, illustrant la tendance croissante à concevoir du hardware à l’aide de l’IA.

Ironwood intègre également la quatrième génération de SparseCore, des accélérateurs spécialisés dans les embeddings et opérations collectives, essentiels pour les architectures de modèles gigantesques. À l’échelle de chaque rack, on trouve 64 TPUs réparties sur 16 racks de CPU hôtes, tous reliés par un réseau sophistiqué de commutateurs optiques dans une structure tridimensionnelle.

Ce nouveau système ne sera pas commercialisé sous forme de matériel indépendant, mais réservé à Google Cloud, renforçant l’approche de Google qui conçoit ses propres infrastructures pour fournir ses services, tels que YouTube, Gmail ou la recherche, où l’intelligence artificielle joue un rôle transversal. Les utilisateurs de Google Cloud bénéficieront d’une inférence en temps réel pour des modèles complexes, d’une stabilité accrue en production, ainsi qu’une optimisation énergétique et de fiabilité adaptée aux centres de données modernes.

Avec Ironwood, Google entend consolider sa position de leader en matière de hardware dédié à l’intelligence artificielle, en proposant une solution spécialisée pour l’inférence massive et le raisonnement, contrastant avec les GPU de NVIDIA, comme la série GB300, qui visent à couvrir aussi bien l’entraînement que l’inférence. La puissance offerte par cette nouvelle plateforme, capable d’atteindre 42,5 exaflops avec une mémoire partagée de 1,77 pétaoctets, est taillée pour l’ère des modèles comptant des milliards de paramètres et des agents d’IA nécessitant fiabilité, efficacité énergétique et sécurité en contexte de production.

Questions fréquentes :

– Ironwood se distingue principalement par son orientation vers l’inférence à grande échelle, contrairement aux TPU antérieures, axées sur l’entraînement.

– Les commutateurs optiques (OCS) permettent de partager la mémoire entre des milliers de puces et de reconfigurer le système lors de défaillances.

– La mémoire comprend huit stacks de HBM3e, totalisant 192 Go par puce avec un débit de 7,3 téraoctets par seconde, indispensables pour alimenter les grands modèles de langage.

– Ironwood sera réservé aux clients de Google Cloud TPU, sans option d’achat en standalone.