Google a officiellement lancé Gemini 3, la troisième génération de sa famille de modèles d’intelligence artificielle, envoyant un message clair au secteur technologique : la compétition ne se limite plus à la génération de textes ou d’images, mais concerne désormais le raisonnement, l’utilisation d’outils et l’action en tant qu’agent autonome dans des environnements réels.

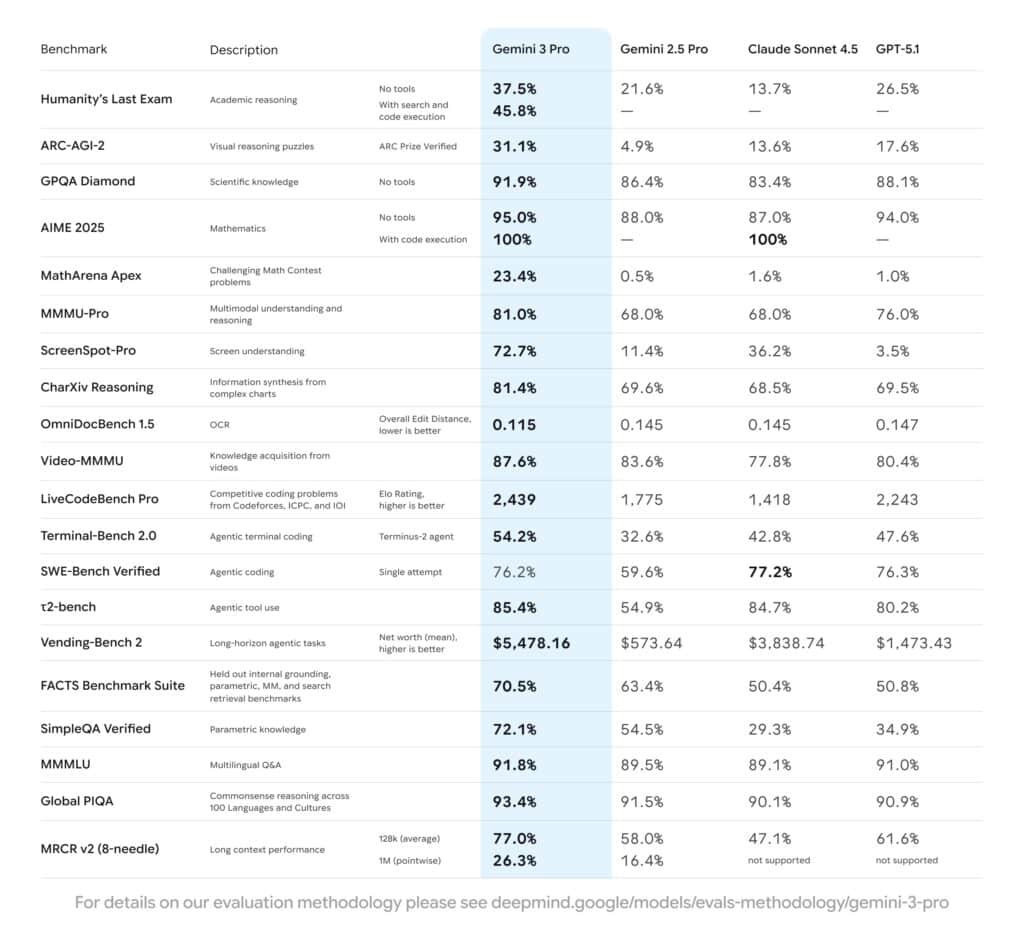

Pour un public technique, la société présente plus que de simples promesses. Elle a publié un tableau de benchmarks très détaillé et mis en ligne une nouvelle plateforme de développement basée sur des agents, Google Antigravity, qui positionne Gemini 3 davantage comme un opérateur de systèmes ou ingénieur virtuel que comme un simple assistant conversationnel.

De Gemini 1 à Gemini 3 : deux années d’itérations accélérées

En moins de deux ans, la famille Gemini est passée du statut de réponse de Google aux premiers modèles génératifs généralistes à celui d’une offre complète orientée agents et planification à long terme.

- Gemini 1 a introduit la multimodalité native et des fenêtres de contexte très larges.

- Gemini 2 et 2.5 Pro ont porté cette base à une architecture agent-centric, avec des modèles capables d’enchaîner des actions et de dominer les classements communautaires tels que LMArena pendant des mois.

- Gemini 3 constitue une synthèse de ces étapes, renforçant le raisonnement, l’utilisation robuste des outils et la capacité à planifier des flux complexes.

L’activation est immédiate : Gemini 3 Pro est disponible dès le premier jour en Mode IA du moteur de recherche, dans l’application Gemini, via l’API pour développeurs dans AI Studio et Vertex AI, et constitue le moteur central de la nouvelle plateforme Antigravity.

Benchmarks : où Gemini 3 Pro progresse et où la compétition se resserre

Pour tout observateur de l’évolution des modèles à la pointe, le tableau de benchmarks de Gemini 3 Pro est le point le plus remarquable de cette annonce. Google a comparé son modèle à Gemini 2.5 Pro, Claude Sonnet 4.5 et GPT-5.1 sur un ensemble varié d’évaluations : raisonnement, multimodalité, utilisation d’outils et planification.

Raisonnement académique et scientifique

Sur des tâches complexes de raisonnement, Gemini 3 Pro affiche des performances notables :

- Humanity’s Last Exam (HLE) : test de raisonnement doctoral sans outils, avec un taux de réussite de 37,5 %, contre 21,6 % pour Gemini 2.5 Pro, 13,7 % pour Claude Sonnet 4.5 et 26,5 % pour GPT-5.1.

- GPQA Diamond : axé sur des connaissances scientifiques avancées, le modèle atteint 91,9 %, surpassant ses concurrents proches.

- ARC-AGI-2 : puzzle de raisonnement visuel vérifié par ARC Prize, avec un taux de réussite de 31,1 %, nettement supérieur au 4,9 % de Gemini 2.5 Pro et aux 13–18 % des autres modèles.

En mathématiques compétitives, les résultats sont nuancés. Dans MathArena Apex, Gemini 3 Pro atteint 23,4 %, bien au-dessus des moins de 2 % des autres modèles analysés. Cependant, en AIME 2025, un autre ensemble de problèmes mathématiques, le score est plus équilibré : 95 % sans outils, surpassant la fourchette de 88–94 % de ses concurrents, et 100 % avec exécution de code, à égalité avec Claude Sonnet 4.5.

Multimodalité avancée

Dans le domaine du raisonnement multimodal, point fort historique de Google, Gemini 3 Pro affiche :

- 81,0 % en MMMU-Pro, test combinant images et texte dans diverses disciplines, en tête devant Gemini 2.5 Pro et Claude Sonnet, dépassant GPT-5.1.

- 87,6 % en Video-MMMU, évaluant la compréhension de l’information vidéo, avec une nouvelle avance sur ses concurrents.

- 72,7 % en ScreenSpot-Pro, compréhension d’écrans et interfaces, avec une progression significative par rapport à 11,4 % de Gemini 2.5 Pro.

Concernant la lecture OCR et la compréhension de documents complexes (OmniDocBench 1.5), Gemini 3 atteint une erreur moyenne de 0,115, meilleure que ses homologues, indiquant une capacité accrue à traiter PDFs, captures d’écran et documents scannés.

Codage, agents et utilisation d’outils

Le véritable point fort de Gemini 3 Pro réside probablement dans le domaine des agents et du codage :

- LiveCodeBench Pro : une évaluation équivalente à des compétitions comme Codeforces ou ICPC, avec un score ELO de 2 439, supérieur à 2 243 pour GPT-5.1 et largement devant les autres.

- Terminal-Bench 2.0 : évalue l’usage d’outils en terminal simulé, avec un taux de réussite de 54,2 %, contre 32,6 % pour Gemini 2.5 Pro, et entre 42,8 % et 47,6 % pour Claude et GPT-5.1.

- t2-bench : focalisé sur l’utilisation agentique d’outils, avec 85,4 %, en tête de la compétition.

- Vending-Bench 2 : planification à long terme pour la gestion simulée d’un réseau de ma-chines automatiques, avec un patrimoine moyen d’environ 5 478 dollars, nettement supérieur aux 573 dollars de Gemini 2.5 Pro, 3 838 dollars pour Claude, et 1 473 dollars pour GPT-5.1.

Sur le test SWE-Bench Verified, référence clé pour l’évaluation des agents de correction de code, Gemini 3 Pro est très proche de ses concurrents : 76,2 % contre 77,2 % pour Claude Sonnet 4.5 et 76,3 % pour GPT-5.1. La différence avec Gemini 2.5 Pro (59,6 %) est significative, mais aucun modèle ne domine encore clairement cette catégorie.

Connaissances factuelles, multilinguisme et contexte étendu

Concernant la précision factuelle et l’ancrage au réel, le modèle affiche :

- 70,5 % en FACTS Benchmark Suite, un ensemble de tests internes combinant vérification des connaissances, multimodalité, récupération d’informations par recherche et ancrage paramétrique.

- 72,1 % en SimpleQA Verified, bien supérieur aux 30–35 % observés chez Claude et GPT-5.1.

En matière de sens commun et multilingue, Gemini 3 dépasse également ses prédécesseurs :

- 91,8 % en MMLU (Multilingual Knowledge & Language Understanding) et 93,4 % en Global PIQA.

En capacité de gestion de contexte prolongé :

- 77,0 % en MRCR v2 (8-needle) pour 128 000 tokens de mémoire à moitié pleine.

- 26,3 % en MRCR v2 à un million de tokens, contre 16,4 % pour Gemini 2.5 Pro, sans support pour ces longues longueurs chez certains concurrents.

Globalement, ces résultats confirment l’ambition de Google : Gemini 3 Pro n’est pas seulement une évolution incrémentale, mais une tentative de proposer un modèle équilibré en raisonnement, multimodalité et capacités agentiques, avec certains domaines où la compétition reste féroce ou même en avance.

Deep Think : davantage de calculs pour les cas vraiment difficiles

Pour les situations où la précision prime sur la latence, Google introduit Gemini 3 Deep Think, un mode spécifique permettant au modèle d’effectuer davantage d’étapes internes de raisonnement avant de produire une réponse.

Les premiers tests montrent des améliorations notables : 45,1 % de réussite sur Humanity’s Last Exam, GPQA Diamond ou ARC-AGI, notamment avec exécution de code. Deep Think reste en phase d’évaluation de sécurité : la société le réservera initialement aux abonnés de Google AI Ultra.

Gemini 3 en produits : moteur de recherche, applications, cloud et agents

Au-delà des chiffres, la feuille de route est ambitieuse :

- Mode IA dans le moteur de recherche : Gemini 3 alimente les nouvelles interfaces dynamiques, intégrant générateurs visuels, simulations et outils interactifs adaptés à chaque requête.

- Application Gemini : les utilisateurs de Google AI Pro et Ultra commenceront à interagir avec Gemini 3 Pro, puis avec Deep Think et des capacités avancées d’agents.

- AI Studio, Vertex AI et Gemini Enterprise : développeurs et entreprises peuvent intégrer le modèle via API et services gérés, avec un accent sur les agents, la recherche augmentée et l’automatisation des processus métiers.

- Google Antigravity : la nouvelle plateforme de développement focalisée sur les agents, où Gemini 3 sert de moteur pour la planification, la codification, et l’utilisation du navigateur ou de la ligne de commande.

Antigravity représente probablement la pièce maîtresse stratégique pour les professionnels techniques : elle transforme l’assistance IA en un véritable runtime d’agents collaborant à la réalisation de tâches complexes en code, avec accès direct à l’IDE, au terminal et au navigateur pour des tests en boucle fermée.

Sécurité, alignement et aspects moins visibles de l’annonce

Google affirme que Gemini 3 est son modèle le plus sécurisé à ce jour. Après avoir subi le plus complet ensemble d’évaluations internes et d’analyses externes par des partenaires spécialisés et des organismes publics, plusieurs améliorations ont été identifiées :

- Réduction des réponses « complaisantes » lorsque l’incertitude est présente.

- Renforcement contre l’injection de prompts et les techniques de jailbreak.

- Sécurisation contre des usages malveillants en cyberattaques.

Pour un média technologique, l’information clé est que le modèle a été évalué selon le cadre de sécurité propre aux modèles avancés de Google, et que Deep Think ne sera pas rendu accessible au public tant qu’il n’aura pas passé des filtres supplémentaires.

Questions fréquentes pour les experts techniques à propos de Gemini 3

Que révèlent réellement les benchmarks publiés de Gemini 3 Pro ?

Les benchmarks couvrent plusieurs dimensions : raisonnement académique (Humanity’s Last Exam, GPQA), mathématiques (AIME 2025, MathArena), multimodalité (MMMU-Pro, Video-MMMU, ScreenSpot-Pro), précision factuelle (FACTS, SimpleQA), codage et agents (SWE-Bench, LiveCodeBench, Terminal-Bench, t2-bench, Vending-Bench) et gestion de contexte long (MRCR v2). Bien qu’étant reconnus dans la communauté, ces évaluations ont été réalisées par Google ; il faudra observer comment des tests indépendants confirmer ces résultats quand d’autres auront accès au modèle.

Comment se positionne Gemini 3 en matière de codage et d’agents face à ses concurrents ?

En codage compétitif et utilisation d’outils en terminal simulé, Gemini 3 Pro affiche clairement une avance, notamment avec un score ELO de 2 439 en LiveCodeBench Pro et 54,2 % en Terminal-Bench 2.0. Sur SWE-Bench Verified, la différence avec Claude Sonnet 4.5 et GPT-5.1 est minime, laissant penser que la discipline des agents de codage reste très disputée et qu’aucun modèle ne domine largement.

Quel rôle joue Google Antigravity dans l’écosystème Gemini 3 ?

Antigravity constitue la couche qui transforme Gemini 3 en plus qu’un modèle de génération de texte : une plateforme de développement basée sur des agents, avec accès direct à l’éditeur, au terminal et au navigateur. Ces agents peuvent planifier des tâches complexes, modifier du code, exécuter des tests et valider les résultats, en permanence sous supervision humaine. Pour les équipes d’ingénierie, c’est un levier potentiel pour décupler la productivité au-delà de la simple création ponctuelle de snippets.

Quels aspects doivent surveiller entreprises et développeurs avant de déployer Gemini 3 en production ?

Au-delà de la puissance brute, plusieurs points clés sont à considérer : le coût par token selon le mode (Pro ou Deep Think), la latence des flux agentiques, la compatibilité avec vos politiques internes de sécurité et de conformité, ainsi que la robustesse face à des évaluations indépendantes sur la sécurité et la confidentialité, notamment dans des domaines sensibles comme la finance, la santé ou l’administration publique.

Source : Gemini 3