Une startup soutenue par NVIDIA lance une solution innovante pour soulager la pression sur la mémoire HBM et optimiser les coûts d’inférence dans les modèles génératifs

La société émergente Enfabrica Corporation a annoncé cette semaine le lancement d’Emfasys, le premier système commercial de mémoire élastique pour l’intelligence artificielle basé entièrement sur Ethernet. Cette nouvelle architecture promet de bouleverser l’efficacité des charges de travail d’inférence à grande échelle, permettant d’augmenter la capacité de mémoire des serveurs GPU via de la DRAM DDR5 connectée par réseau, sans modifier l’infrastructure du système.

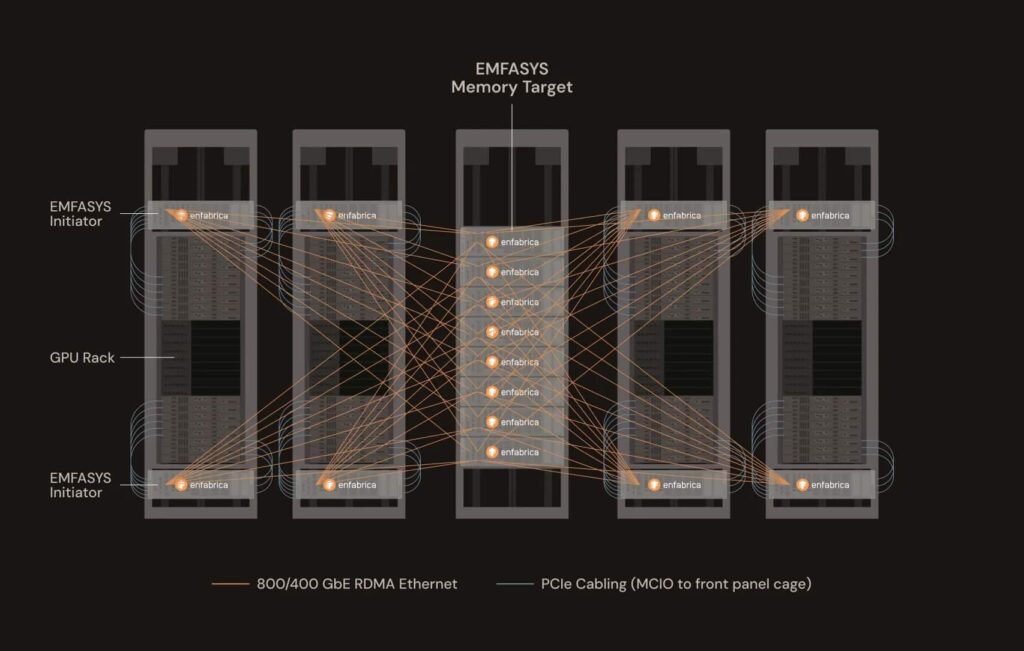

Conçue pour répondre aux défis de scalabilité posés par les grands modèles de langage (LLM), Emfasys offre jusqu’à 18 To de mémoire DDR5 par nœud, accessible via des connexions Ethernet standards de 400 et 800 GbE, en utilisant des technologies telles que RDMA et CXL. Selon la société, cette solution pourrait réduire de 50 % le coût par token généré, notamment dans les charges comprenant plusieurs tours, des fenêtres de contexte élargies ou l’inférence d’agents autonomes.

« L’inférence en IA rencontre un problème de scalabilité en bande passante mémoire et de surcharge de marges », déclare Rochan Sankar, PDG d’Enfabrica. « À mesure que les modèles deviennent plus volumineux et moins conversationnels, l’accès à la mémoire nécessite une nouvelle approche. Emfasys est notre réponse à ce défi. »

Une nouvelle ère dans l’architecture mémoire

La technologie repose sur la puce ACF-S SuperNIC, qui offre un débit de 3,2 Tbps et permet d’interconnecter des serveurs GPU avec mémoire DDR5 via le protocole CXL.mem. Cette architecture fonctionne comme un « contrôleur de mémoire par Ethernet », où les données se transfèrent sans intervention du CPU, avec des latences en microsecondes, bien inférieures à celles proposées par les systèmes basés sur le stockage flash.

Le système comprend un logiciel de mémoire distante compatible RDMA et avec des environnements opérationnels standards, facilitant son déploiement sans nécessiter une refonte du logiciel ou du matériel existant. Grâce à cette approche, l’utilisation des ressources de calcul est optimisée, le gaspillage de mémoire HBM — coûteuse et limitée — est réduit et les goulets d’étranglement dans les environnements multi-utilisateurs ou intensifs sont atténués.

Applications pour la nouvelle génération d’IA générative

La croissance exponentielle des modèles génératifs et agents, avec des besoins 10 à 100 fois supérieurs à ceux des déploiements précédents de LLM, met sous tension l’infrastructure mondiale d’IA. Enfabrica propose Emfasys comme une solution d’échelle pour les environnements cloud, où le nombre de tokens par seconde et la mémoire par contexte déterminent le coût total de possession (TCO).

Les premiers clients testent déjà cette technologie. La société n’a pas encore indiqué la date de disponibilité publique, mais la solution est en phase d’évaluation active et de pilote. Enfabrica fait également partie du consortium Ultra Ethernet (UEC) et collabore avec la norme émergente Ultra Accelerator Link (UALink).

Une startup avec un appui stratégique

Cette annonce s’ajoute au récent soutien financier recueilli par la société, qui en 2023 a bouclé une levée de fonds Série B de 125 millions de dollars, avec l’intervention de Sutter Hill Ventures et NVIDIA. En avril 2025, Enfabrica a commencé à distribuer des échantillons de sa puce ACF-S, et en février, elle a ouvert un nouveau centre de R&D en Inde pour accélérer le développement de solutions réseau pour l’IA.

Avec Emfasys, Enfabrica ambitionne de positionner sa société en leader d’un nouveau segment d’infrastructure mémoire distribuée pour l’IA générative, où la performance d’accès à la mémoire pourrait faire la différence entre une viabilité économique et un effondrement des ressources lors de la prochaine vague d’applications cognitives.