La startup affirme que sa technologie sera jusqu’à 10 fois plus rapide et efficace que la mémoire HBM pour les charges d’inférence, marquant ainsi un changement de paradigme dans la relation entre calcul et mémoire.

La mémoire à large bande passante (HBM) est devenue la référence incontournable en intelligence artificielle et calcul haute performance. Utilisée par des géants comme NVIDIA, AMD ou Intel, sa conception modulable empilée permet d’atteindre des débits de bande passante inimaginables avec des mémoires classiques. Toutefois, elle ne constitue peut-être pas la solution idéale pour toutes les tâches.

La startup d-Matrix pense avoir trouvé un substitut plus adapté à l’un des principaux goulets d’étranglement actuels de l’IA : l’inférence. Sa proposition, baptisée 3D Digital In-Memory Compute (3DIMC), promet d’être jusqu’à 10 fois plus rapide et 10 fois plus efficace que la HBM dans ce type de charges de travail.

De l’entraînement à l’exécution des modèles : un défi différent

Alors que la HBM est cruciale pour l’entraînement de modèles d’IA, requérant d’énormes quantités de mémoire et de bande passante, l’inférence — la phase où des modèles déjà entraînés traitent des données en temps réel — a des besoins différents.

Selon d-Matrix, l’inférence est “ostrée par la mémoire”, davantage que par la puissance brute de calcul (FLOPs). « La croissance rapide des modèles, et le coût croissant, la consommation d’énergie et les limitations de bande passante des systèmes HBM traditionnels deviennent un enjeu majeur », explique Sid Sheth, fondateur et PDG de l’entreprise.

La solution consiste à rapprocher le calcul de la mémoire et à effectuer directement les opérations à l’intérieur de celle-ci.

Comment fonctionne 3DIMC

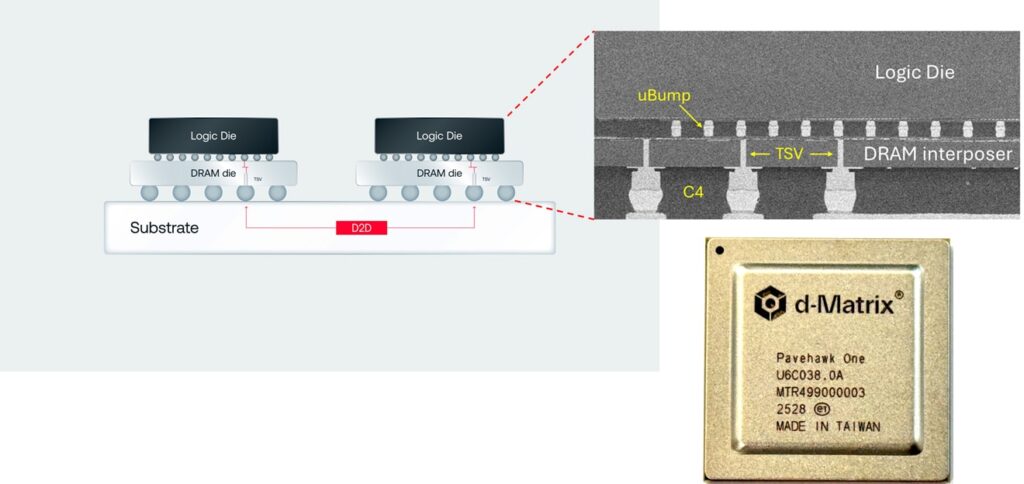

Dans son puce Pavehawk, actuellement en phase de tests en laboratoire, d-Matrix combine des mémoires LPDDR5 avec des chiplets DIMC empilés en 3D via un interposer. Ces chiplets intègrent une logique spécialisée pour la multiplication matrice-vecteur, une opération récurrente dans les modèles d’IA basés sur les transformeurs.

La clé réside dans le fait que les opérations sont effectuées directement dans la mémoire, ce qui réduit drastiquement la latence, augmente le débit et, en théorie, améliore l’efficacité énergétique jusqu’à 90 % par rapport à la HBM.

L’entreprise travaille déjà sur la génération suivante, nommée Raptor, qui cherchera à surpasser définitivement la HBM dans les charges d’inférence.

Implications économiques et stratégiques

La HBM reste une ressource limitée et coûteuse. Seuls trois fabricants dominent le marché : SK hynix, Samsung et Micron, et leurs prix devraient continuer à augmenter. SK hynix prévoit une croissance annuelle de 30 % du marché HBM jusqu’en 2030, ce qui exerce une pression croissante sur les centres de données et les fournisseurs cloud dépendant de ces mémoires.

Dans ce contexte, une alternative comme 3DIMC apparaît particulièrement attractive. Un design spécialisé pour l’inférence pourrait réduire les coûts et libérer les grands clients — hyperscaleurs et entreprises d’IA — de la dépendance envers quelques fournisseurs. Toutefois, certains analystes mettent en garde contre une spécialisation trop étroite, risquant d’être “excessivement limitée” dans un secteur déjà en proie à des signes de surinvestissement ou de bulle technologique.

Révolution ou niche ?

La démarche de d-Matrix s’inscrit dans une tendance plus large : concevoir du matériel spécifique pour chaque étape du cycle de vie de l’IA. Si l’entraînement et l’inférence ont des profils si distincts, pourquoi imposer à une seule technologie de mémoire de couvrir ces deux besoins ?

La réponse pourrait émerger dans les prochaines années, à mesure que des hyperscalers comme Google, Microsoft ou Amazon envisagent d’incorporer un écosystème parallèle de mémoires dédié à l’inférence. Pour l’heure, d-Matrix veut démontrer que sa solution n’est pas simplement un prototype de laboratoire, mais une alternative viable pour le marché réel.

Questions fréquentes (FAQ)

En quoi 3DIMC diffère-t-elle de la mémoire HBM ?

Alors que la HBM se limite à transférer rapidement des données entre la mémoire et le processeur, 3DIMC effectue des calculs directement dans la mémoire, réduisant la nécessité de déplacer les données et améliorant ainsi l’efficacité lors de l’inférence.

3DIMC constitue-t-elle un remplacement direct de la HBM ?

Pas dans tous les cas. Elle est principalement destinée à l’inférence en IA, alors que l’entraînement de modèles nécessite encore la HBM, plus adaptée à cette tâche.

Quels avantages économiques offre 3DIMC ?

Elle pourrait diminuer la dépendance aux principaux fabricants de HBM et réduire les coûts d’infrastructure, notamment dans les centres de données traitant de très grands volumes d’inférence.

Quand pourrait-elle être commercialisée ?

Pour l’instant, seul le Pavehawk fonctionne en laboratoire. Le futur chip Raptor sera celui de la validation réelle face à la HBM dans les années à venir.

Source : d-matrix.ai