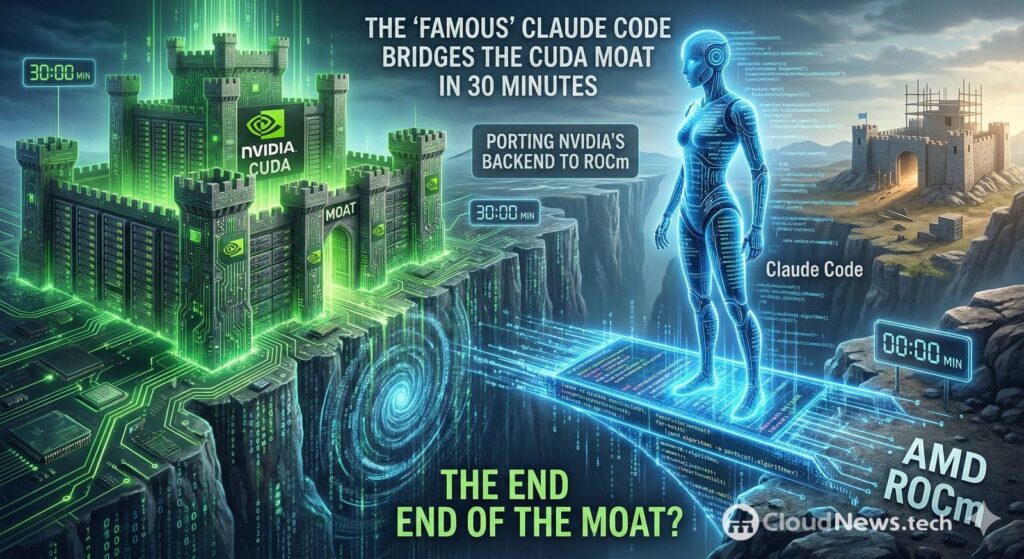

Une discussion sur Reddit a ravivé un débat qui mijotait depuis des mois dans la communauté GPU : dans quelle mesure la « muraille » de CUDA — combinant API, bibliothèques, outils et expérience accumulée autour de NVIDIA — reste une barrière réelle si les outils de programmation assistée par agents commencent à automatiser le travail ardu de portage.

Le point de départ de cette polémique est une affirmation aussi directe que polémique : un utilisateur affirme avoir porté un backend CUDA complet vers ROCm en une trentaine de minutes grâce à Claude Code, l’environnement de codage assisté d’Anthropic, sans recourir à des couches de traduction « intermédiaires » type wrapper, et avec un seul obstacle majeur : les différences de data layout.

Pourquoi cela importe : ROCm n’est pas nouveau, mais le « coût de sortie » pourrait évoluer

AMD pousse depuis plusieurs années ROCm comme plateforme de calcul accéléré sur GPU, en misant sur HIP, une approche visant à rendre une partie du code CUDA portable avec des modifications raisonnables. En effet, AMD propose des outils officiels comme HIPIFY pour convertir automatiquement du code source CUDA en HIP C++.

Le problème pratique, c’est que « porter » ne signifie pas simplement compiler : cela implique de garantir la correction (résultats identiques), d’optimiser les performances (ou de minimiser la perte) et de remplacer des dépendances (par exemple, des bibliothèques spécifiques à CUDA). C’est là où beaucoup d’organisations se heurtent à la réalité : le coût n’est pas seulement technique, il concerne aussi les tests, le profilage des performances, la gestion des regressions et le maintien.

Si un outil assisté par agent peut réduire drastiquement le temps de traduction initiale, cela déplace le débat : il ne s’agit plus de « si le portage est possible », mais de « combien coûte la validation et l’optimisation du portage » et « quels cas restent hors automatisation ».

Ce que révèle ce cas : une affirmation virale et une contribution réelle

Dans le fil Reddit, l’utilisateur associe son expérience à un cas précis : un pull request dans le dépôt de Leela Chess Zero (lc0) intitulé « backend ROCm complet ».

Ce détail est important car il distingue deux niveaux :

- Niveau vérifiable : un PR public qui introduit effectivement un backend ROCm dans un projet concret.

- Niveau discutable : le fait de dire « je l’ai fait en 30 minutes avec Claude Code » repose sur le témoignage de l’auteur et le contexte précis (taille du code, complexité des kernels, couverture fonctionnelle, tests, etc.).

En résumé : il existe une réalisation technique tangible, mais la conclusion « la muraille de CUDA est tombée » reste, à ce jour, davantage un titre émotionnel qu’une preuve universelle.

Pourquoi un agent peut « porter rapidement »… et pourquoi cela ne supprime pas CUDA

Les outils assistés par agents sont particulièrement efficaces pour les transferts mécaniques :

- Mapper des appels CUDA courants vers leurs équivalents en HIP/ROCm lorsque possible.

- Renommer types, macros et utilitaires.

- Réorganiser fichiers, CMake et options de compilation.

- Réaliser des refactorings systématiques qui nécessitaient auparavant des heures de travail répétitif.

Cette logique correspond à ce que AMD formalise avec HIP/HIPIFY : automatiser la partie la plus « éditoriale » du portage.

Et Claude Code, en tant qu’environnement conçu pour manipuler des dépôts et des tâches de développement, apparaît comme un outil permettant d’effectuer d’importants changements avec l’aide d’un agent.

Cependant, le « moat » de CUDA ne se limite pas à des noms de fonctions. Là où la promesse du « portage en minutes » se brise, c’est dans le travail qui n’est pas simplement syntaxique :

- Optimisation spécifique au hardware

Les kernels à haute performance sont intimement liés aux hiérarchies de caches, aux modèles d’accès, à l’occupation, à la synchronisation et aux micro-décisions qui ne se traduisent pas toujours de façon équivalente entre architectures. - Differences sémantiques et d’exécution

Même quand deux plateformes « se ressemblent », de petites différences dans le comportement ou les hypothèses peuvent générer des bugs subtils visibles seulement sous charge, avec des tailles précises ou dans des scénarios de concurrence. - Dépendances de l’écosystème

CUDA n’est pas seulement le runtime : il inclut bibliothèques, profils, outils, documentation, exemples et une énorme base installée. Portée un projet sérieux implique souvent de remplacer ou de valider des composants auxiliaires. - Validation et maintenance

Le vrai coût apparaît après : CI, tests de performance, tolérances numériques, regressions, et la question stratégique pour l’entreprise : « qui maintiendra cette branche portable lorsque la branche principale évoluera ? »

Impact réel : moins de barrières à l’entrée, mais pas de « fin du verrouillage »

Ce qui change — si ces cas se multiplient — c’est la psychologie du marché :

- Pour les équipes considérant le multi-fournisseur de GPU, réduire le coût initial du portage diminue la crainte de rester bloqué.

- Pour AMD et son écosystème, chaque histoire de « migration rapide » devient un argument marketing et une pression concurrentielle.

- Pour NVIDIA, le risque n’est pas la disparition de CUDA, mais que certains commencent à traiter CUDA comme une cible supplémentaire, plutôt que comme « le seul chemin raisonnable ».

Cependant, l’expression « fin de la muraille » reste prématurée. La muraille n’est pas uniquement technique ; elle inclut aussi formation, outils avancés, bibliothèques leaders, support et disponibilité des talents.

Contexte général : l’industrie cherche depuis des mois des failles

Ce phénomène intervient à un moment où fleurissent diverses initiatives (aux approches variées) pour réduire la dépendance : des couches de compatibilité aux projets communautaires visant à exécuter ou adapter des workloads CUDA hors de NVIDIA. Parmi celles-ci, ZLUDA est souvent évoqué, un projet visant à rendre CUDA compatible dans des environnements non NVIDIA.

Ce qui change désormais, c’est « l’effet agent » : si un modèle peut prendre en charge la plupart du travail répétitif, l’humain se concentre sur la validation et l’optimisation, la relation des coûts évolue.

Questions fréquentes

Qu’est-ce que ROCm et comment diffère-t-il de CUDA ?

ROCm est la plateforme d’AMD pour le calcul sur GPU, avec son propre stack de compilation et runtime. CUDA est le stack propriétaire de NVIDIA. AMD promeut HIP comme moyen d’écrire du code plus portable entre GPU, tandis que CUDA est optimisé pour l’écosystème NVIDIA.

HIPIFY permet-il de porter CUDA « automatiquement » ?

HIPIFY traduit de manière automatique une partie du code source CUDA en HIP C++, ce qui facilite le démarrage d’une migration. Ceci ne garantit toutefois pas une équivalence fonctionnelle complète ni des performances identiques : ces étapes requièrent tests et optimisation.

Claude Code peut-il remplacer HIPIFY ou une équipe d’ingénierie ?

Il peut accélérer des tâches répétitives (refactors en masse, changements d’API, ajustements de build), mais pour des projets complexes, le cœur du travail reste validation, débogage et tuning de performance. La qualité du résultat dépend également du contexte, des tests disponibles et de la revue humaine.

Que doit faire une entreprise souhaitant réduire sa dépendance à CUDA ?

En général : repérer les composants « portables » (kernels propres), isoler les dépendances de bibliothèques, élaborer une batterie de tests et benchmarks, et aborder le portage comme un projet d’ingénierie avec des KPIs (correctitude et performance). Les outils automatiques peuvent faire gagner du temps, mais ils ne remplacent pas la gouvernance technique.