ASUS Présente Son Infrastructure Avancée pour l’IA à COMPUTEX 2025

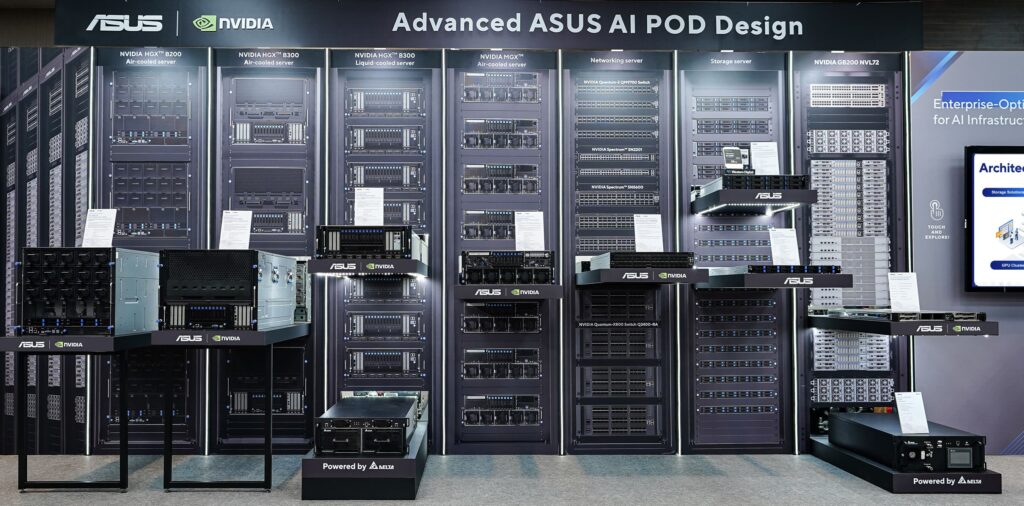

Taipei, 2025 – Aujourd’hui, lors de COMPUTEX 2025, ASUS a dévoilé une nouvelle infrastructure avancée pour l’intelligence artificielle (IA) en partenariat avec NVIDIA. Nommée AI POD, cette architecture de référence validée pour la NVIDIA Enterprise AI Factory offre des solutions optimisées et évolutives pour les agents d’IA, l’IA physique, et les charges de travail HPC.

Ces nouveaux designs sont certifiés pour fonctionner avec les plateformes Grace Blackwell, HGX et MGX de NVIDIA, et sont disponibles pour des centres de données dotés de refroidissement liquide ou de solutions air-cooled. Cela permet une flexibilité, un rendement et une efficacité thermique sans précédent pour les entreprises désireuses de déployer l’IA à grande échelle.

Architecture de Référence pour la Fabrique d’IA

La solution d’ASUS propose une architecture de référence validée, conçue pour simplifier le développement, le déploiement et la gestion des applications d’IA avancée en environnement local. Celle-ci inclut :

- Calcul accéléré avec des GPU NVIDIA GB200/GB300 NVL72

- Réseaux de haute performance utilisant NVIDIA Quantum InfiniBand ou Spectrum-X Ethernet

- Stockage certifié avec des racks ASUS RS501A-E12-RS12U et VS320D

- Logiciel d’entreprise par le biais de NVIDIA AI Enterprise et d’outils de gestion ASUS

Parmi les configurations remarquables, on trouve un cluster de 576 GPU répartis sur huit racks avec refroidissement liquide, ou une version compacte avec 72 GPU dans un unique rack air-cooled, redéfinissant ainsi les performances pour des charges telles que l’entraînement de modèles de langage (LLMs) et l’inférence massive.

Racks MGX et HGX Optimisés pour l’IA de Prochaine Génération

ASUS a également lancé de nouvelles configurations conformes aux standards MGX avec sa série ESC8000, intégrant des processeurs Intel Xeon 6 et des GPU RTX PRO 6000 Blackwell Server Edition, en partenariat avec l’adaptateur NVIDIA ConnectX-8 SuperNIC capable d’atteindre jusqu’à 800 Gb/s. Ces plateformes sont optimisées pour les tâches de génération de contenu, l’IA générative et immersive.

De plus, les racks HGX optimisés par ASUS (XA NB3I-E12 avec HGX B300 et ESC NB8-E11 avec HGX B200) offrent une densité de GPU élevée et une efficacité thermique exceptionnelle, qu’ils soient refroidis par air ou liquide.

Infrastructure pour Agents d’IA Autonomes

Avec les dernières innovations en IA agentique, l’infrastructure d’ASUS se concentre sur des modèles d’IA capables de prendre des décisions autonomes et d’apprendre en temps réel, permettant des applications avancées dans diverses industries. Pour soutenir cela, ASUS propose :

- ASUS Control Center – Data Center Edition et Infrastructure Deployment Center (AIDC) pour faciliter le déploiement de modèles

- WEKA Parallel File System et ProGuard SAN Storage pour la gestion des données

- Gestion SLURM avancée et NVIDIA UFM pour les réseaux InfiniBand, optimisant ainsi l’utilisation des ressources

Un Pas de Plus Vers la Fabrique d’IA

ASUS vise à se positionner comme partenaire stratégique dans la création de fabriques d’IA à l’échelle mondiale, en combinant matériel validé, logiciel orchestré et support commercial. Ces solutions sont conçues pour réduire le temps de déploiement, améliorer le coût total de possession (TCO), et assurer une scalabilité fluide et sécurisée.

ASUS et NVIDIA établissent ainsi un nouveau standard pour les centres de données intelligents du futur, axé sur l’adoption massive de l’IA de prochaine génération et l’évolution vers des agents autonomes au sein des infrastructures d’entreprise.