Au Computex 2024, AMD a souligné la dynamique croissante de sa gamme d’accélérateurs AMD Instinct™ lors du discours d’ouverture de la présidente et PDG, Dr. Lisa Su. AMD a révélé une feuille de route étendue et pluriannuelle pour les accélérateurs AMD Instinct, promettant un leadership annuel en performances d’IA et en capacités de mémoire avec chaque nouvelle génération.

La feuille de route mise à jour commence avec le nouvel accélérateur AMD Instinct MI325X, disponible au quatrième trimestre de 2024. Ensuite, la série AMD Instinct MI350 sera lancée en 2025, équipée de la nouvelle architecture AMD CDNA™ 4, qui offrira une augmentation jusqu’à 35 fois des performances d’inférence IA par rapport à la série AMD Instinct MI300 basée sur l’architecture AMD CDNA 3. Pour 2026, la série AMD Instinct MI400 est attendue, et s’appuiera sur l’architecture AMD CDNA « Next ».

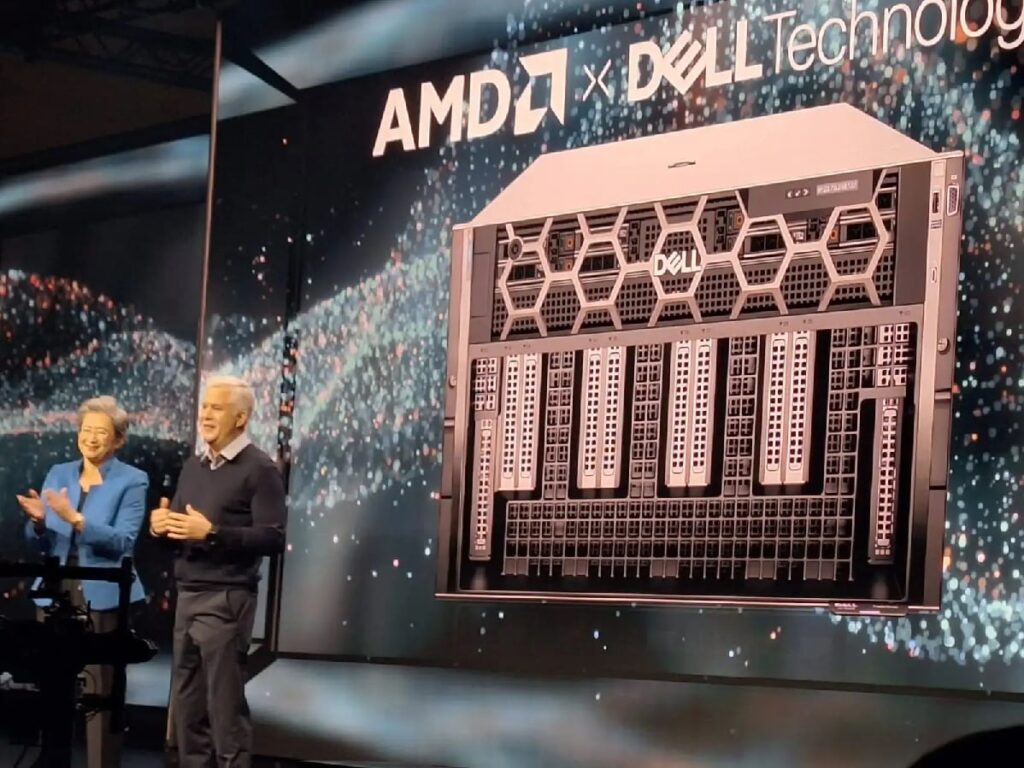

« Les accélérateurs AMD Instinct MI300X continuent leur forte adoption par de nombreux partenaires et clients, y compris Microsoft Azure, Meta, Dell Technologies, HPE, Lenovo et d’autres, résultat direct de l’excellente performance et proposition de valeur de l’accélérateur AMD Instinct MI300X », déclare Brad McCredie, vice-président corporate de la Compute Acceleration pour les data centers chez AMD. « Avec notre cadence annuelle de produits mise à jour, nous sommes implacables dans notre rythme d’innovation, fournissant les capacités de leadership et la performance que l’industrie de l’IA et nos clients attendent pour conduire la prochaine évolution de l’apprentissage et de l’inférence IA dans le centre de donnéesUn data center ou un centre de traitement de données (CTD)…« .

L’écosystème de logiciels IA d’AMD mûrit

La pile de logiciels ouverts AMD ROCm™ 6 continue de mûrir, permettant aux accélérateurs AMD Instinct MI300X de propulser une performance impressionnante pour certains des LLM les plus populaires. Dans un serveur utilisant huit accélérateurs AMD Instinct MI300X et ROCm 6 exécutant Meta Llama-3 70B, les clients peuvent obtenir une performance d’inférence et de génération de tokens 1,3 fois meilleure comparée à celle de la concurrence. Sur un seul accélérateur AMD Instinct MI300X avec ROCm 6, les clients peuvent obtenir une performance d’inférence et de génération de tokens 1,2 fois supérieure à celle de la concurrence dans Mistral-7B. AMD a également souligné que Hugging Face, le plus grand et le plus populaire répertoire de modèles d’IA, teste 700 000 de ses modèles les plus populaires chaque nuit pour garantir qu’ils fonctionnent immédiatement sur les accélérateurs AMD Instinct MI300X. De plus, AMD continue de travailler sur des cadres de travail d’IA populaires comme PyTorch, TensorFlow et JAX.

AMD progresse avec de nouveaux accélérateurs et révèle la feuille de route annuelle de la cadence

Lors de la keynote, AMD a dévoilé une cadence annuelle mise à jour pour la feuille de route de l’accélérateur AMD Instinct afin de répondre à la demande croissante de calcul IA. Cela aidera à garantir que les accélérateurs AMD Instinct alimentent le développement de modèles d’IA de pointe de la prochaine génération. La feuille de route annuelle mise à jour d’AMD Instinct souligne :

- Le nouvel accélérateur AMD Instinct MI325X, qui apportera 288 Go de mémoire HBM3E et 6 téraoctets par seconde de bande passanteLa bande passante est la capacité maximale de transfert… de mémoire, utilisera le même design de serveur à base plate universelle standard de l’industrie utilisé par la série AMD Instinct MI300, et sera disponible de manière générale au quatrième trimestre 2024. L’accélérateur aura une capacité de mémoire et une bande passante leaders dans l’industrie, 2 fois et 1,3 fois meilleurs que ceux de la concurrence, respectivement, et une performance de calcul 1,3 fois supérieure à celle de la concurrence.

- Le premier produit de la série AMD Instinct MI350, l’accélérateur AMD Instinct MI350X, est basé sur l’architecture AMD CDNA 4 et devrait être disponible en 2025. Il utilisera le même design de serveur à base plate universelle standard de l’industrie que les autres accélérateurs de la série MI300 et sera fabriqué avec la technologie de processus avancée de 3 nm, sera compatible avec les types de données d’IA FP4 et FP6 et aura jusqu’à 288 Go de mémoire HBM3E.

- On s’attend à ce que l’architecture AMD CDNA « Next », qui alimentera les accélérateurs de la série AMD Instinct MI400, soit disponible en 2026, offrant les dernières caractéristiques et capacités qui aideront à débloquer des performances et une efficacité supplémentaires pour l’inférence et l’entraînement d’IA à grande échelle.

Enfin, AMD a souligné que la demande pour les accélérateurs AMD Instinct MI300X continue de croître avec de nombreux partenaires et clients utilisant les accélérateurs pour alimenter leurs charges de travail d’IA exigeantes, y compris :

- Microsoft Azure utilisant les accélérateurs pour les services Azure OpenAI et les nouvelles machines virtuelles Azure ND MI300X V5.

- Dell Technologies utilise des accélérateurs MI300X dans le PowerEdge XE9680 pour des charges de travail d’IA d’entreprise.

- Supermicro offre plusieurs solutions avec des accélérateurs AMD Instinct.

- Lenovo propulse l’innovation IA hybride avec le ThinkSystem SR685a V3.

HPE les utilise pour accélérer les charges de travail d’IA dans le HPE Cray XD675.