Le secteur mondial des semi-conducteurs amorce 2026 avec une sensation de tournant historique. Il ne s’agit pas uniquement de nouveaux processeurs, mais d’un reprofilage de la valeur: les flux financiers et les priorités technologiques se déplacent vers l’infrastructure de l’intelligence artificielle, et dans ce mouvement, la mémoire — DRAM, HBM et stockage d’entreprise — passe d’un rôle secondaire à celui de composant clé pour la performance et la rentabilité.

C’est la thèse centrale de l’analyse de SK hynix sur le marché en 2026 : l’expansion de l’IA entraîne un cycle haussier dans la mémoire que certains banques et analystes qualifient déjà de “supercycle”. La firme sud-coréenne vise à en être au cœur grâce à sa position de leader en HBM3E et sa préparation pour la prochaine génération, HBM4. Le ton est révélateur : il ne s’agit plus de se demander si l’IA va transformer le marché, mais quelle part de la chaîne d’approvisionnement en tirera le plus grand bénéfice.

Un marché atteignant le “billion” et une mémoire en plein essor

Les prévisions du secteur pour 2026 pointent vers une croissance forte. La organisation World Semiconductor Trade Statistics (WSTS) estime que le marché mondial des semi-conducteurs croîtra de plus de 25 % d’année en année pour atteindre environ 975 milliards de dollars, frôlant le seuil du billion (au sens anglo-saxon). Dans ce contexte, la mémoire et la logique de circuit ressortent comme les segments principaux, avec des augmentations prévues de plus de 30 %.

Ce qui importe, ce n’est pas seulement la taille du marché, mais sa composition. L’IA modifie profondément la manière de “rendre opérationnel” un serveur : plus de DRAM par système, plus de HBM par accélérateur, et parallèlement, une croissance du stockage d’entreprise (eSSD) pour accueillir les datasets, checkpoints, vecteurs, ainsi que tout le processus d’entraînement et d’inférence. Certaines estimations placent d’ailleurs le marché de la mémoire en 2026 au-dessus de 440 milliards de dollars, avec une traction particulièrement forte dans le segment des serveurs et centres de données.

En termes d’infrastructure : à mesure que les modèles d’IA ne cessent de s’étendre, la demande en mémoire proche, rapide et efficace ne cesse d’augmenter. Et cette demande ne se limite pas à plus d’unités ; elle exige des générations nouvelles, davantage d’empilement et un packaging de pointe.

Le “supercycle” de la mémoire : prix, demande et mutation structurelle

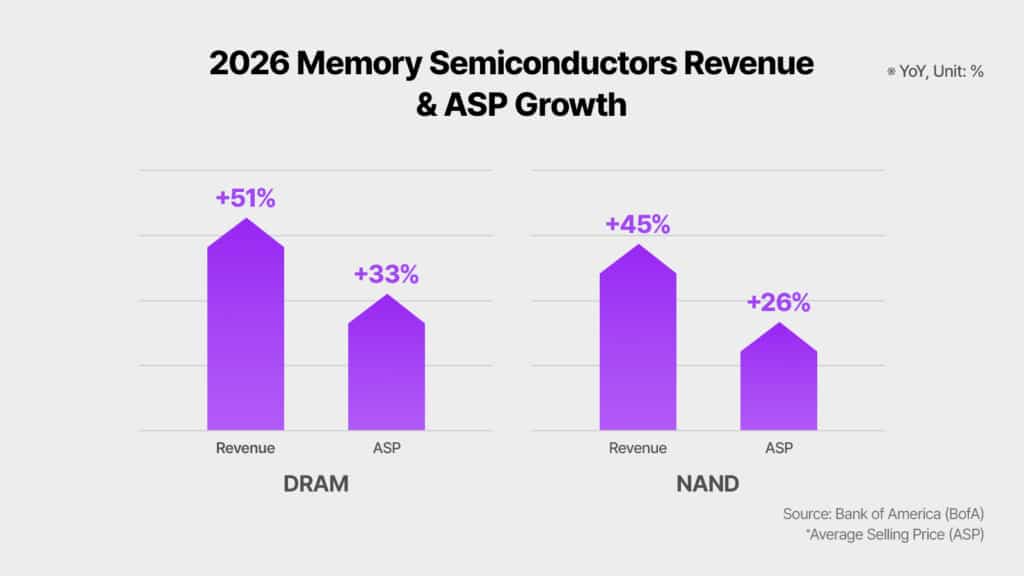

Depuis 2024, l’expression “supercycle” circule pour décrire la dynamique de la mémoire. Selon l’analyse de SK hynix, Bank of America compare 2026 avec le boom des années 90, anticipant une hausse interannuelle de 51 % des revenus mondiaux de la DRAM et de 45 % pour la NAND, avec des prix moyens (ASP) en hausse de 33 % et 26 %. Ces prévisions ne reposent pas uniquement sur la demande : elles reflètent aussi un changement de l’offre. Quand les fabricants et clients priorisent les produits liés à l’IA, une partie de la capacité de production est orientée vers cette filière, modifiant l’équilibre du marché.

Par ailleurs, Reuters a récemment évoqué un contexte de tension d’approvisionnement et de hausse des prix dans la mémoire, associée au boom de l’IA, avec des investisseurs interprétant cette période comme un cycle haussier qui pourrait durer. Ce contexte renforce l’idée que le marché ne vit pas une relance passagère, mais un mouvement de plusieurs années.

HBM : Le point central de l’IA

Dans la mémoire, le terme clé est HBM (High Bandwidth Memory). L’analyse de SK hynix résume cette mutation par une comparaison frappante : certains prévisionnistes estiment que la taille du marché HBM en 2028 pourrait dépasser le marché total de la DRAM de 2024. Ce n’est pas une assertion anodine. Elle indique que le centre de profit et l’influence se déplacent vers cette mémoire qui alimente directement les GPUs et ASICs spécialisés en IA, grâce à son haut débit.

Dans cette même optique, Bank of America prévoit que le marché HBM en 2026 pourrait atteindre 54,6 milliards de dollars, soit une hausse de 58 % par rapport à l’année précédente. Goldman Sachs prévoit également une accélération forte de la demande pour HBM, notamment pour les ASICs de IA personnalisés, avec une croissance estimée à 82 % et un poids d’environ un tiers du marché. La tendance est claire : l’infrastructure IA se diversifie au-delà de la GPU classique et pousse la mémoire vers des solutions sur mesure.

HBM3E, leader en 2026, et HBM4 sur le devant de la scène

La transition entre générations ne sera pas instantanée. Selon les experts, HBM3E restera le produit emblématique du marché HBM tout au long de 2026. La raison ? Il s’agit de la technologie adaptée aux accélérateurs et plateformes IA qui seront massivement déployés cette année, tant dans les clouds que dans les développements propriétaires des grandes entreprises technologiques.

Simultanément, HBM4 progressera graduellement. La stratégie adoptée par SK hynix est “à double voie” : maintenir le leadership en volume avec HBM3E tout en développant un système solide pour le déploiement de HBM4.

Le leadership de SK hynix : parts de marché, clients et capacité opérationnelle

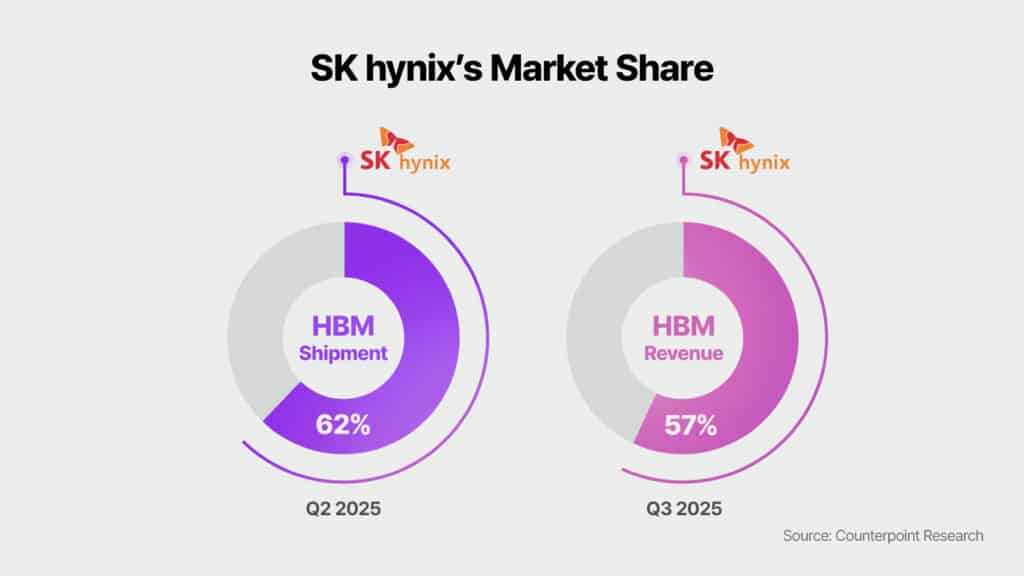

La stratégie concurrentielle de SK hynix repose sur deux piliers : sa part de marché actuelle et sa préparation industrielle. Selon Counterpoint Research, la société détenait au deuxième trimestre 2025 une part de marché de 62 % pour les expéditions de HBM et 57 % pour les revenus au troisième trimestre. Goldman Sachs, citant la même source, prévoit que SK hynix maintiendra sa position dominante sur HBM3/HBM3E jusqu’en 2026, conservant une part de plus de 50 % sur le marché global de la mémoire HBM.

De plus, UBS souligne la relation étroite avec de grands clients et positionne SK hynix comme premier fournisseur de HBM3E pour certaines plateformes. Elle avance aussi une projection ambitieuse : une part proche de 70 % pour HBM4 sur la plateforme Rubin de NVIDIA en 2026. Bien que ce soit une prévision, cela illustre comment le marché anticipe la poursuite de la domination lors du changement de génération technologique.

Concernant la capacité industrielle, l’analyse met en avant la position unique de SK hynix : sa capacité à fournir HBM3E tout en préparant efficacement HBM4. Cela inclut des jalons et des investissements, notamment l’assurance d’un système de production en masse pour HBM4, la collaboration renforcée avec TSMC, la modernisation de l’usine Cheongju M15X, ainsi que la création d’entités spécialisées comme une organisation HBM dédiée et un Global AI Research Center.

Risques : combien de temps durera le cycle et quels facteurs pourraient le freiner ?

L’analyse admet également une certaine prudence. Parmi les risques évoqués, figurent d’éventuelles corrections de prix après 2026 dues à la concurrence et à l’expansion de la capacité, ainsi que des variables liées à l’approvisionnement, aux régulations ou aux tensions géopolitiques.

Le secret réside dans l’équilibre entre deux forces : d’une part, la demande structurelle impulsée par l’IA qui semble difficile à stopper ; de l’autre, l’industrie qui accélère ses investissements pour préserver ses marges. La technologie HBM étant particulièrement complexe, elle limite généralement les changements radicaux de leadership à court terme, mais le risque de corrections lors d’un “respir” du marché reste présent.

2026, année de transition : HBM3E en standard et HBM4 en préparation

Le marché tel que le perçoit SK hynix peut être résumé ainsi : 2026 sera une année charnière où coexisteront trois dynamiques. La première : l’expansion de l’infrastructure IA continuera à faire augmenter la part de la mémoire et du stockage dans les dépenses globales. La deuxième : HBM3E s’imposera comme le standard de facto dans les serveurs et centres de données IA. La troisième : HBM4 débutera son déploiement, anticipant la croissance à moyen et long terme.

Dans ce contexte, la mémoire cesse d’être une simple commodité pour devenir un facteur stratégique majeur. Si le supercycle se confirme, la valeur ne résidera pas seulement dans la fabrication en volume, mais dans une livraison précise, fiable et un packaging avancé, prêt pour la prochaine étape de l’IA.

Questions fréquentes

Quelle différence entre HBM3E et HBM4 pour les serveurs IA, et pourquoi cela sera-t-il important en 2026 ?

La HBM3E devrait dominer en 2026 grâce à sa compatibilité avec les plateformes actuelles, tandis que la HBM4 représentera la nouvelle génération qui gagnera progressivement des parts. La différence principale réside dans la capacité, le débit et la calendrier d’adoption par les nouvelles plateformes.

Pourquoi parle-t-on de “supercycle” de la mémoire avec la croissance de l’intelligence artificielle ?

Parce que l’IA augmente la mémoire par serveur (DRAM et HBM) et intensifie le besoin en eSSD pour stocker données et modèles. Cette demande, combinée à des contraintes d’offre et à la focalisation sur des produits à forte valeur, pourrait maintenir plusieurs années de croissance et de pression sur les prix.

Que signifie que le marché HBM pourrait surpasser le marché traditionnel de la DRAM dans quelques années ?

Cela implique que le composant critique pour alimenter les accélérateurs IA (HBM) pourrait devenir la principale source de valeur en mémoire, dépassant en importance la DRAM classique.

Quels risques pourraient freiner ce développement à partir de 2026 ?

Les analystes évoquent d’éventuelles corrections de prix dues à la compétition et à l’expansion de capacité, ainsi que l’incertitude géopolitique et réglementaire. Toutefois, la complexité technique de la HBM tend à limiter les changements rapides de domination, même si des ajustements restent possibles lors des phases de marché en répit.

Sources : news.skhynix